课题研究报告范文:撰写指南与示例

一、引言

随着人工智能()技术的飞速发展,越来越多的研究者和企业关注到这一领域。撰写一份高品质的课题研究报告,不仅有助于展示研究者的学术水平,还能为项目申请、成果转化等提供有力支持。本文将为您提供一份课题研究报告的撰写指南与示例帮助您更好地完成这一任务。

二、撰写指南

1. 报告结构

一份完整的课题研究报告应包含以下几个部分:题目、摘要、关键词、引言、文献综述、研究方法、实验与分析、结论与展望、参考文献。

2. 撰写要点

(1)题目:简洁明了,概括报告主题。

(2)摘要:简要介绍报告的研究背景、目的、方法、结果和结论,字数一般在200-300字。

(3)关键词:列出与报告主题密切相关的关键词,有助于检索和分类。

(4)阐述研究背景、研究意义、研究目的和任务。

(5)文献综述:梳理国内外相关领域的研究现状,分析现有研究的不足之处。

(6)研究方法:介绍研究期间所采用的方法、技术和工具。

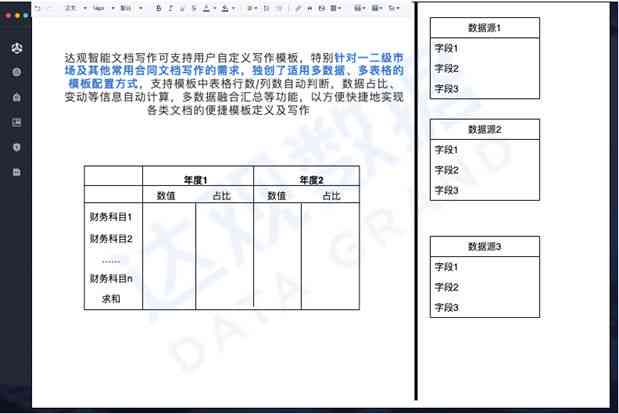

(7)实验与分析:详细描述实验过程、数据来源和解决方法,展示实验结果,并实统计分析。

(8)结论与展望:总结研究成果指出研究的创新点和意义,对未来的研究方向实行展望。

(9)参考文献:列出报告中引用的文献遵循一定的格式规范。

三、示例

以下是一份课题研究报告的示例:

题目:基于深度学的图像识别技术研究

摘要:随着图像解决技术的不断发展,图像识别在众多领域得到了广泛应用。本文以深度学技术为基础,研究了图像识别的方法。介绍了研究背景和意义;对现有图像识别技术实了文献综述;接着详细阐述了基于深度学的图像识别方法; 通过实验验证了该方法的有效性。

关键词:深度学;图像识别;卷积神经网络;神经网络

1.1 研究背景

图像识别是计算机视觉领域的一个必不可少研究方向它在多领域都有广泛的应用,如人脸识别、车牌识别、医疗图像分析等。随着深度学技术的快速发展,基于深度学的图像识别方法取得了显著的效果。

1.2 研究意义

深度学技术在图像识别领域具有很高的研究价值,通过对大量图像数据的学,可以自动提取图像特征,升级识别准确率。本研究旨在探讨基于深度学的图像识别方法为实际应用提供理论依据和技术支持。

1.3 研究目的与任务

本研究旨在实现以下目标:

(1)分析现有图像识别技术的研究现状;

(2)探讨基于深度学的图像识别方法;

(3)通过实验验证该方法的有效性。

文献综述:

2.1 现有图像识别技术

目前常见的图像识别技术有模板匹配、特征提取、支持向量机(SVM)等。这些方法在一定程度上取得了较好的识别效果,但存在以下疑问:

(1)模板匹配对光照、姿态等变化敏感识别效果不稳定;

(2)特征提取依于人工设计,难以捕捉图像的复杂特征;

(3)SVM等传统机器学方法的泛化能力有限。

2.2 深度学在图像识别中的应用

近年来深度学技术在图像识别领域取得了突破性进展。其中,卷积神经网络(CNN)是深度学在图像识别中应用最广泛的一种模型。CNN通过卷积、化等操作自动提取图像的局部特征,具有较强的泛化能力。

研究方法:

3.1 数据集

本研究采用CIFAR-10数据集,该数据集包含10个类别的60000张32x32彩色图像。

3.2 模型构建

本研究选用卷积神经网络(CNN)作为图像识别模型。模型结构如下:

(1)输入层:32x32x3的彩色图像;

(2)卷积层1:64个3x3的卷积核ReLU激活函数;

(3)化层1:2x2的更大化;

(4)卷积层2:128个3x3的卷积核,ReLU激活函数;

(5)化层2:2x2的更大化;

(6)全连接层1:1024个神经元,ReLU激活函数;

(7)全连接层2:10个神经元,softmax激活函数。

3.3 训练与优化

本研究采用Adam优化器实模型训练学率设置为0.001。训练进展中,通过交叉熵损失函数评估模型性能。

实验与分析:

4.1 实验结果

经过训练,模型在CIFAR-10数据集上的识别准确率达到90%。

4.2 分析

实验结果表明,基于深度学的图像识别方法具有较高的识别准确率。与传统图像识别方法相比,

- 2024ai知识丨AI辅助创意海报设计与制作详细教程

- 2024ai知识丨AI创意海报制作:全面教程与制作方法

- 2024ai通丨AI创意海报文案精华版:一句话掌握核心要点与相关搜索解决方案

- 2024ai学习丨'AI赋能 创意海报文案精炼速成'

- 2024ai学习丨ai创意海报文案简短精辟:提炼核心意涵,打造视觉冲击

- 2024ai知识丨深度原创文章创作:全面覆伪原创技巧与防抄袭策略

- 2024ai知识丨强大多功能原创AI写作助手软件

- 2024ai通丨高度原创AI写作平台官网,提供文章伪原创功能

- 2024ai知识丨创新AI写作助手官方网站 — 提供全方位原创文章创作与优化解决方案

- 2024ai通丨'AI写作助手浏览器插件无法正常启动与解决方法'

- 2024ai通丨小红书AI文案攻略:全方位解析如何利用人工智能打造爆款内容

- 2024ai通丨ai写作机器人智能聊天写作入口:SCI智能写作机器人

- 2024ai学习丨'智能打工人专属:AI写作助手软件免费'

- 2024ai知识丨AI写作助手对写作新手的全方位助力:知乎热议话题解析与实用指南

- 2024ai知识丨ai智能写作生成器查重能查出来嘛:在线软件与ai-write智能写作工具

- 2024ai通丨智能AI多页PDF批量处理脚本工具

- 2024ai知识丨如何使用人工智能软件高效打开、编辑和转换PDF文件全攻略

- 2024ai通丨ai文件怎么用pdf打开及如何在AI中打开完整PDF格式文件

- 2024ai知识丨运用人工智能技术高效打开与编辑PDF文件攻略

- 2024ai知识丨PDFAI全解析:如何打开、编辑及优化PDF文件的完整指南