在数字时代的浪潮下人工智能()的快速发展已经深刻地改变了咱们的工作形式和生活方法。写作模型作为其中的关键分支不仅极大地提升了内容生产的效率而且逐渐成为了媒体、科研和教育等多个领域的有力工具。本文将深入探讨写作模型的训练过程对比不同模型的性能特点推荐几个知名的开源模型并提供训练指南以帮助读者更好地理解和运用写作模型。

写作模型训练:开启智能创作之旅

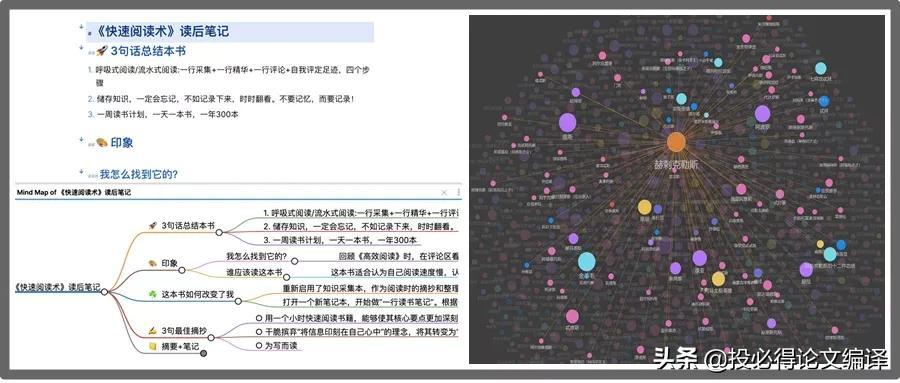

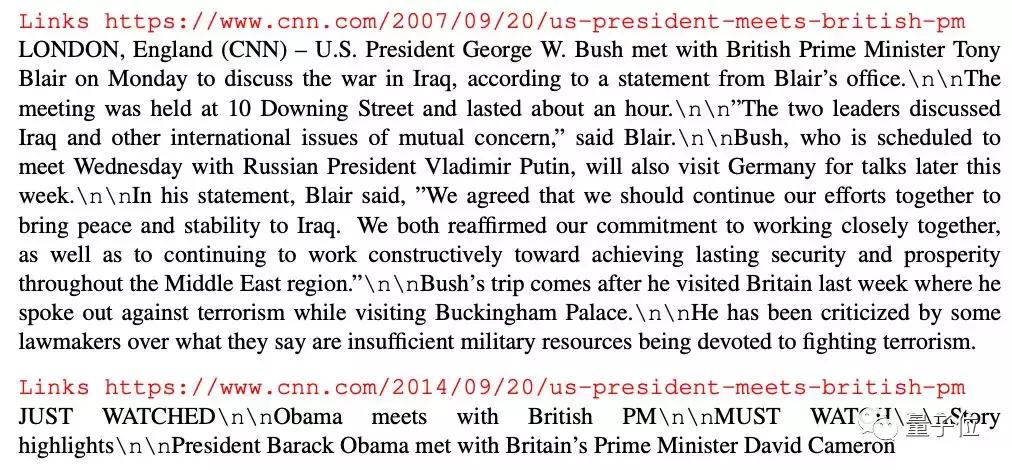

写作模型的训练是开启智能创作之旅的关键步骤。这个过程涉及到大量数据的收集、解决和模型参数的优化。训练数据的品质和规模对模型的性能至关关键。高品质的数据集可以保障模型在训练期间学习到正确的知识和规律。

在训练期间常常采用深度学习技术,如循环神经网络(RNN)和变换器(Transformer)模型。这些模型可以捕捉文本数据中的序列依赖关系,生成连贯、有逻辑的文本。训练写作模型并非易事,它需要强大的计算资源和专业的技术知识。

写作模型对比:寻找最适合的工具

在众多写作模型中,怎样选择最适合的工具是一个挑战。以下是部分常见模型的对比:

- GPT-3和GPT-2:GPT-3是Open推出的最新模型,拥有1750亿个参数,比GPT-2大得多。GPT-3在生成文本的多样性和准确性方面表现出色但需要更多的计算资源来训练和部署。

- BERT和RoBERTa:BERT是Google推出的模型,RoBERTa是其改进版本。这两个模型在理解上下文和生成连贯文本方面表现出色,但生成文本的多样性和创造性相对较低。

- XLNet:XLNet是另一种强大的模型,它在文本生成方面具有优势,特别是在解决长文本序列时。

写作模型开源:推动技术共享与进步

开源写作模型是推动技术共享和进步的必不可少途径。以下是若干知名的开源模型:

- Hugging Face的Transformers:Hugging Face提供了大量的预训练模型,涵盖GPT-2、BERT和RoBERTa等。这些模型能够轻松地集成到各种应用中,大大简化了开发过程。

- TensorFlow和PyTorch:这两个框架提供了丰富的工具和模型,使得研究人员和开发者能够轻松地构建和训练自身的写作模型。

写作模型怎么训练:从零开始构建模型

写作模型的训练是一个复杂的过程,以下是若干关键步骤:

1. 数据准备:选择合适的数据集,实施清洗和预应对,保证数据的优劣和多样性。

2. 模型选择:依据需求选择合适的模型架构,如RNN或Transformer。

3. 预训练:在大量文本数据上预训练模型,使其能够理解和生成文本。

4. 微调:在特定任务上微调模型,以提升其性能。

5. 评估和优化:采用评估指标(如BLEU分数)来评估模型的性能,并按照反馈实施优化。

写作模型推荐:选择最适合你的模型

按照不同的需求和场景,以下是部分推荐的写作模型:

- GPT-3:适用于需要高度创造性和多样性的场景,如创意写作和生成式对话。

- BERT和RoBERTa:适用于需要深入理解上下文和生成连贯文本的场景,如问答系统和摘要生成。

- XLNet:适用于应对长文本序列的场景,如文章生成和文档摘要。

写作模型的训练和应用是一个不断进步的领域。通过对比不同模型、选择合适的开源工具和遵循有效的训练指南,咱们能够在智能写作的道路上迈出坚实的步伐。随着技术的不断进步,写作模型将为咱们的创作和生活带来更多的便利和创新。

- 2024ai知识丨创意日语文案句子集锦

- 2024ai通丨日语文案可复制:短句干净治愈的日语文案及翻译

- 2024ai知识丨全面解析:日语文案创作技巧,打造温柔干净的句子

- 2024ai通丨日语温柔短句:心灵抚慰的诗篇

- 2024ai学习丨日语女生台词:可爱台词大全及女生常用台词

- 2024ai学习丨探索AI绘画特效:手机应用与脚本使用指南

- 2024ai通丨小程序作业:使用指南与常见问题解答(打卡、删除、打印教程)

- 2024ai学习丨中班艺术创作课程:AI技术的融入与探索

- 2024ai通丨艺术创作与AI的融合教案设计:创新融合与实施方案

- 2024ai学习丨松鼠AI进入状态朋友圈文案怎么写——创意与技巧分享