随着人工智能技术的飞速发展,自然语言解决(NLP)领域取得了显著的成果。GPT-3作为Open推出的第三代预训练语言模型,以其强大的语言生成能力引起了广泛关注。在我国,GPT-2的应用同样广泛,特别是在中文生成方面表现出色。本文将为您详细介绍GPT-2中文生成技巧与实践,帮助您全面掌握GPT-2中文生成技术。

## 一、GPT-2中文生成概述

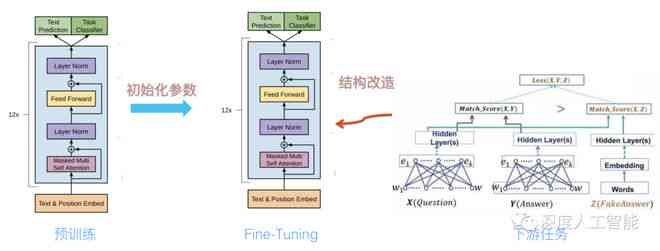

GPT-2是一种基于Transformer架构的预训练语言模型,它通过大规模的文本数据训练,学会了理解和生成自然语言。GPT-2在中文生成方面具有很高的准确性,可以生成流畅、连贯的中文文本。本文将围绕GPT-2中文生成的基本原理、应用场景以及优化技巧展开讨论。

## 二、GPT-2中文生成教程

1. 数据准备

在实行GPT-2中文生成之前咱们需要准备大量的中文文本数据。这些数据可从网络上的文章、书籍、论坛等地方获取。为了加强生成品质,咱们还需要对数据实行预解决如去除噪声、分词等。

内容解答:

数据准备是GPT-2中文生成的基础。咱们需要收集大量的中文文本数据,可从网络文章、书籍、论坛等地方获取。为了保证数据的品质我们需要对数据实施预解决,以下是几个关键步骤:

- 清洗数据:去除文本中的噪声如HTML标签、特殊字符等。

- 分词:将文本切分成词语,便于模型应对。中文分词能够利用jieba等工具。

- 构建词汇表:依照数据集构建词汇表,方便模型识别和生成中文词语。

2. 模型训练

在准备好数据后,我们需要采用Python等编程语言搭建GPT-2模型,并实施训练。训练期间我们能够调整若干超参数,如学习率、批次大小等,以增强生成品质。

内容解答:

模型训练是GPT-2中文生成的核心环节。以下是模型训练的基本步骤:

- 搭建模型:利用Python等编程语言搭建GPT-2模型。常见的框架有TensorFlow和PyTorch。

- 加载预训练权重:加载GPT-2的预训练权重,以便在中文数据上实行微调。

- 设置超参数:调整学习率、批次大小等超参数,以优化模型性能。

- 训练模型:利用准备好的中文数据对模型实施训练,直至模型收敛。

3. 生成文本

在模型训练完成后,我们可利用GPT-2生成中文文本。生成期间,我们需要设置若干参数如生成长度、温度等,以控制生成文本的品质。

内容解答:

生成文本是GPT-2中文生成的最终目标。以下是生成文本的步骤:

- 加载训练好的模型:将训练好的模型加载到内存中。

- 设置生成参数:设置生成文本的长度、温度等参数。长度决定了生成文本的篇幅温度控制生成文本的多样性。

- 生成文本:调用模型的生成接口,输入提示文本,生成中文文本。

4. 优化技巧

为了增强GPT-2中文生成的品质,我们能够采纳部分优化技巧如上下文信息融合、多模型融合等。

内容解答:

优化技巧是提升GPT-2中文生成优劣的关键。以下是部分常见的优化技巧:

- 上下文信息融合:在生成文本时,充分考虑上下文信息,使生成文本更加连贯。

- 多模型融合:结合多个预训练模型如GPT-2和BERT,以加强生成优劣。

- 文本清洗:对生成的文本实行清洗,去除重复、低质的文本。

- 后解决:对生成的文本实行后应对,如修正语法错误、调整句子结构等。

## 三、总结

本文详细介绍了GPT-2中文生成技巧与实践涵盖数据准备、模型训练、生成文本以及优化技巧。通过掌握这些方法,您将能够利用GPT-2生成高品质的中文文本为自然语言解决领域的发展做出贡献。在实际应用中,我们还需不断探索和优化,以进一步加强GPT-2中文生成的性能。

- 2024ai学习丨AICC2019会议脚本详细介绍

- 2024ai通丨ai写作助手怎么打开及编辑模式使用,详谈Sci文章写作技巧

- 2024ai知识丨AI写作助手使用指南:全方位解析如何高效运用智能写作工具解决各类写作难题-

- 2024ai通丨掌握AI写作利器:精选写作软件合集使用指南

- 2024ai通丨ai写作软件泛滥:原因、现状与对策

- 2024ai知识丨探索AI在电商文案写作中的应用:如何高效创作与盈利

- 2024ai学习丨绁濈AI元旦创意文案

- 2024ai学习丨全面解析AI写作:涵盖技术原理、应用领域及未来趋势的新视角

- 2024ai学习丨珠宝文案编辑技巧及写作方法:软件与模板指南

- 2024ai学习丨AI内容创作:官网、平台、创作师证书有用性及考证指南