应对生成模型训练中显存不足与内存不够用的有效方法

一、引言

生成模型训练是深度学领域中的必不可少任务,然而在训练进展中,显存不足与内存不够用的疑惑常常困扰着研究人员和工程师。本文将详细介绍生成模型训练中显存不足与内存不够用的起因,并提出一系列有效的应对方法。

二、显存不足与内存不够用的原因

1. 数据量过大:生成模型训练需要解决大量的数据,这会致使显存和内存的占用过大。

2. 模型参数过多:随着模型复杂度的增加模型参数量也会增大,从而增加显存和内存的占用。

3. 训练算法不够高效:算法复杂度较高或数据结构不合理,会造成显存和内存利用率减低。

4. 系统与软件设置疑问:操作系统、软件设置等因素也可能致使显存和内存不足。

三、解决显存不足的有效方法

1. 减少batch size

减小每次训练时输入的数据量,从而减少显存的占用。这是最简单且常用的方法。但需要关注的是减小batch size可能存在作用模型的训练效果,需要在保证模型性能的前提下实行。

2. 利用4bit量化模型

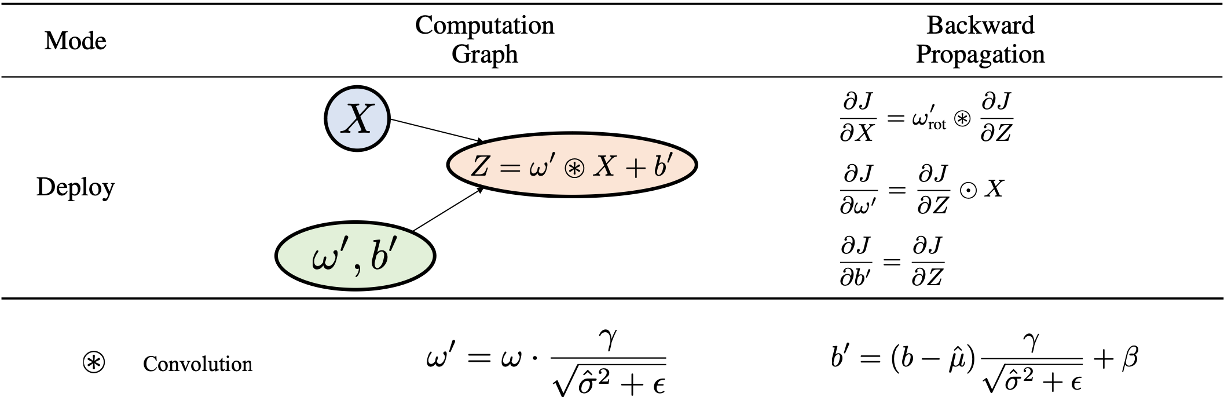

采用4bit的量化模型来取代原生的16bit的模型,可显著减少显存的占用。量化模型可在一定程度上保持模型性能,同时减低显存需求。

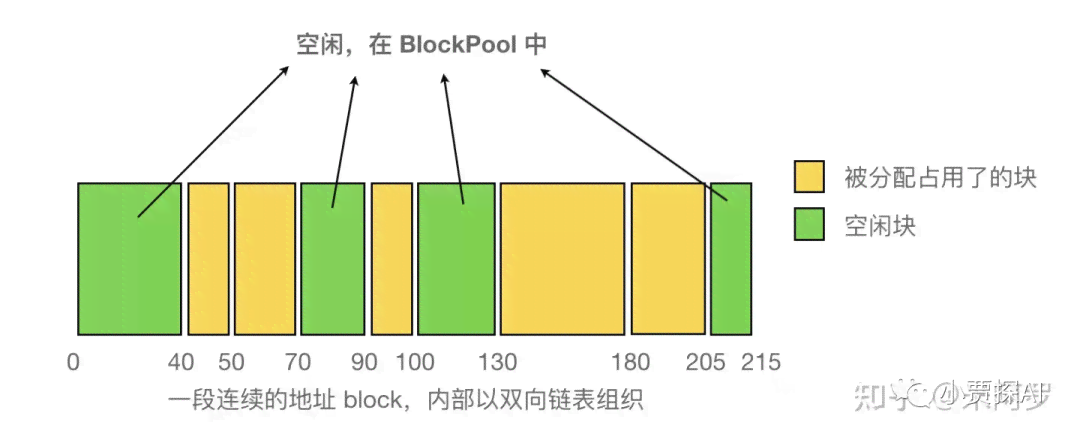

3. 优化数据结构

对生成模型中的算法和数据结构实行优化利用更高效的数据结构,减少内存占用。例如,利用哈希表、树等数据结构代替数组。

4. 清除显存垃圾

在训练进展中,及时释放和清除显存垃圾,可以有效地减少显存占用。可通过调用相关API来清理显存。

四、解决内存不够用的有效方法

1. 增加物理内存

升级计算机的物理内存容量,是解决内存不足的直接方法。但这需要一定的硬件成本。

2. 优化软件设置

调整软件的暂存盘位置,将其设置到空间较大的硬盘。还可在软件设置中调整内存利用策略,加强内存利用率。

3. 减少文件优劣

在导出模型或数据时能够适当减少文件优劣,以减少内存占用。但需要留意减低文件品质可能存在影响模型的性能。

4. 分批次导出

当软件导出文件时可尝试将文件分批次导出,以避免一次性占用过多内存。

五、其他解决方案

1. 利用分布式训练

通过分布式训练,将模型训练任务分散到多个计算机上,从而减低单个计算机的显存和内存需求。

2. 优化算法复杂度

对生成模型中的算法实优化减少算法复杂度,从而减少内存占用。

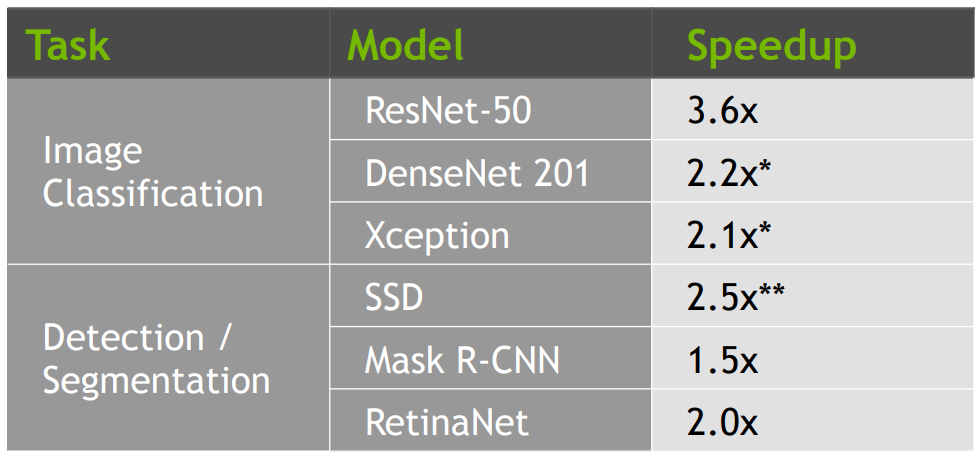

3. 利用高效训练框架

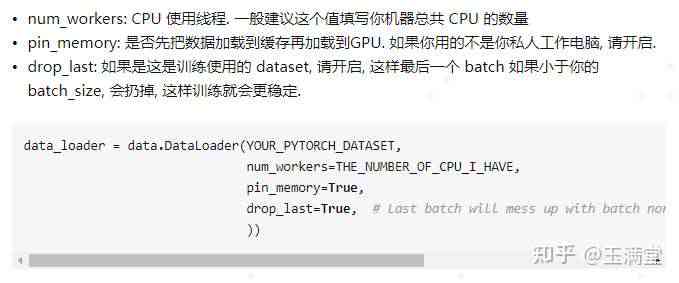

选择具有较高训练效率的框架如TensorFlow、PyTorch等,能够有效地提升显存和内存利用率。

六、总结

显存不足与内存不够用是生成模型训练中常见的难题。通过合理地调整训练策略、优化算法和数据结构,以及改进软件设置,可有效解决这些疑问。在实际应用中,需要依照具体情况选择合适的解决方案以保证生成模型的训练效果。同时随着硬件和算法的发展未来显存不足与内存不够用的疑惑也将得到更好的解决。

- 2024ai知识丨ai婚纱写真照生成文案怎么做:打造好看的高质量文案指南

- 2024ai学习丨AI婚纱摄影创意文案撰写指南:全面解决婚纱写真照生成、编辑与优化需求

- 2024ai学习丨一键免费生成哪些婚纱写真照文案软件,轻松打造梦幻婚纱照文案

- 2024ai知识丨怎么用照片生成证件照:电脑与手机操作步骤详解

- 2024ai知识丨如何找到并使用轻颜相机证件照滤镜:详解操作步骤与功能应用

- 2024ai学习丨如何在抖音找到轻颜相机特效证件照的入口及收藏步骤,记得学会怎么操作

- 2024ai学习丨轻颜相机的证件照功能怎么弄:如何使用及在手机上操作实现完整指南

- 2024ai学习丨如何彻底取消轻颜AI证件照生成服务及撤销相关照片教程

- 2024ai知识丨轻颜相机如何生成并提取抖音风格证件照照片?

- 2024ai通丨轻颜ai证件照生成了怎么取消及如何关闭相机证件照功能

- 2024ai学习丨ai代码生成器自然语言生成代码是什么及常用软件介绍

- 2024ai知识丨自动智能代码生成器:免费自然语言编程助手,一键生成代码软件工具

- 2024ai通丨智能编程助手:AI一键自动生成代码,提升开发效率与准确性

- 2024ai学习丨数字孪生和AI:区别、融合、AIoT关联、ARVRMR对比解析

- 2024ai通丨数字孪生技术案例精选:多领域应用实例文库汇编

- 2024ai通丨深入解析数字孪生技术:涵关键应用、核心技术及行业解决方案

- 2024ai学习丨数字孪生CIM:平台、系统、科技官网及底座造价指标解读

- 2024ai知识丨探究数字孪生技术:究竟是什么,怎样影响我们的生活?

- 2024ai通丨深入解析数字孪生技术:跨行业应用案例与综合效益分析

- 2024ai通丨AI绘画生成吉祥物:打造独特企业文化号与创意设计宴