文章正文

文章正文

掌握辅助编写高效爬虫脚本:全面指南与实战技巧解析

随着互联网技术的快速发展大数据时代已经来临。数据的获取和分析变得越来越要紧而爬虫技术作为数据获取的核心手受到了广大开发者和数据科学家的关注。本文将介绍怎么样利用技术辅助编写高效爬虫脚本帮助读者掌握这一实用的技能。

一、引言

传统的爬虫技术主要依靠人工编写脚本不仅效率低下,而且容易出错。随着技术的发展,咱们可利用来辅助编写爬虫脚本,提升爬虫的效率、准确性和稳定性。本文将从以下几个方面展开讲解:

1. 辅助编写爬虫脚本的优势

2. 怎样去利用编写爬虫脚本

3. 常用辅助编写爬虫脚本软件介绍

4. 实战技巧解析

二、辅助编写爬虫脚本的优势

1. 提升效率:技术可自动分析网页结构,识别目标数据从而升级爬虫的编写速度和运行效率。

2. 准确性高:技术可识别和过滤噪声数据,确信爬取到的数据准确性。

3. 稳定性强:技术可以自动解决网页结构变化,减少因网页更新造成的爬虫失效风险。

4. 可扩展性强:技术可以轻松应对多种数据源和复杂场景,具有较强的可扩展性。

三、怎样利用编写爬虫脚本

1. 数据源分析:我们需要分析目标数据源,理解其网页结构、数据分布等信息。这一步是编写爬虫脚本的基础。

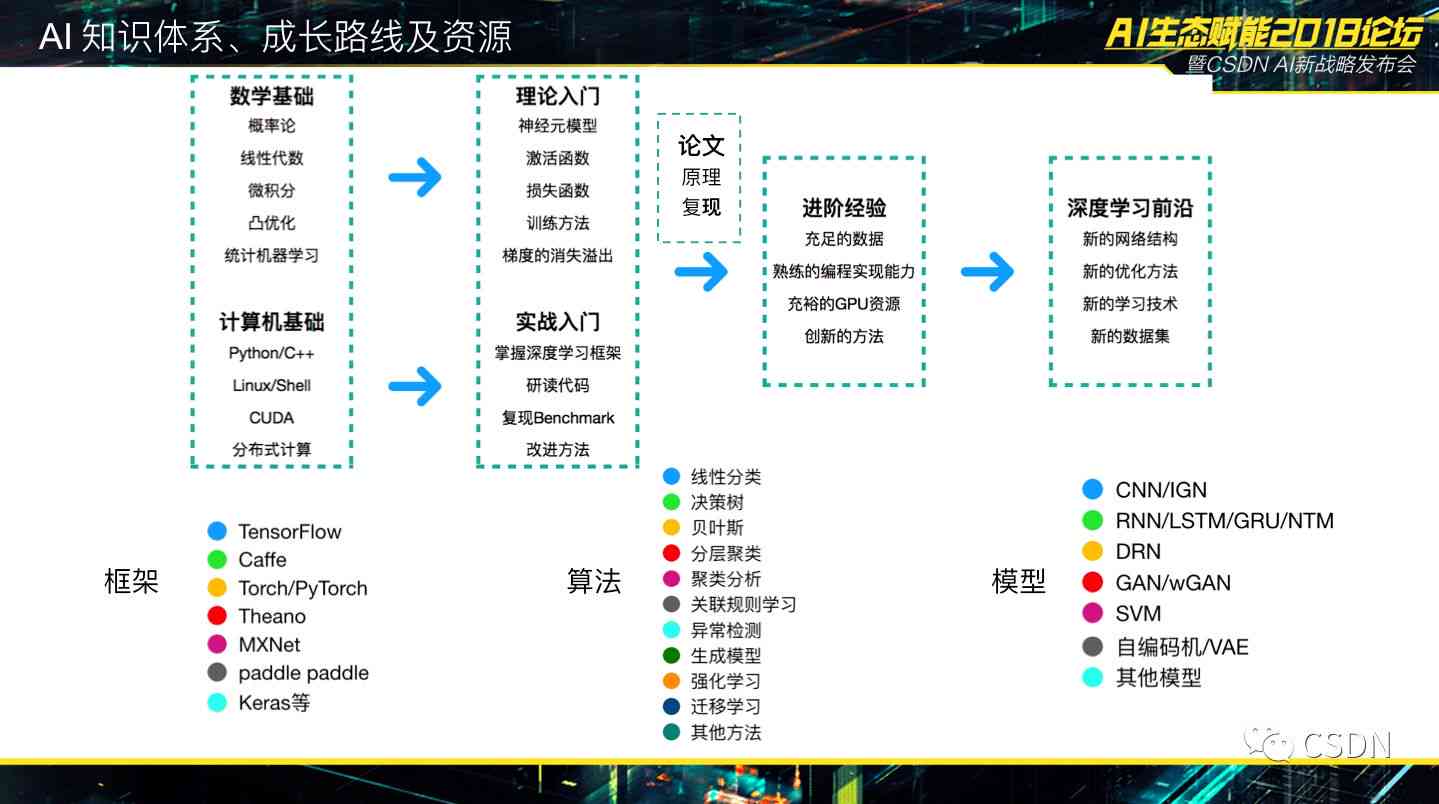

2. 选择合适的技术:按照数据源的特点,选择合适的技术,如深度学、自然语言解决等。

3. 编写爬虫脚本:利用选定的技术,编写爬虫脚本。以下是一个简单的示例:

```python

import requests

from bs4 import BeautifulSoup

import re

def get_data(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'lxml')

data_list = []

for item in soup.find_all('div', class_='item'):

title = item.find('h2').text

price = item.find('span', class_='price').text

data_list.end({'title': title, 'price': price})

return data_list

if __name__ == '__mn__':

url = 'https://example.com/products'

data = get_data(url)

print(data)

```

4. 调试与优化:运行爬虫脚本观察结果,针对出现的疑问实行调试和优化。

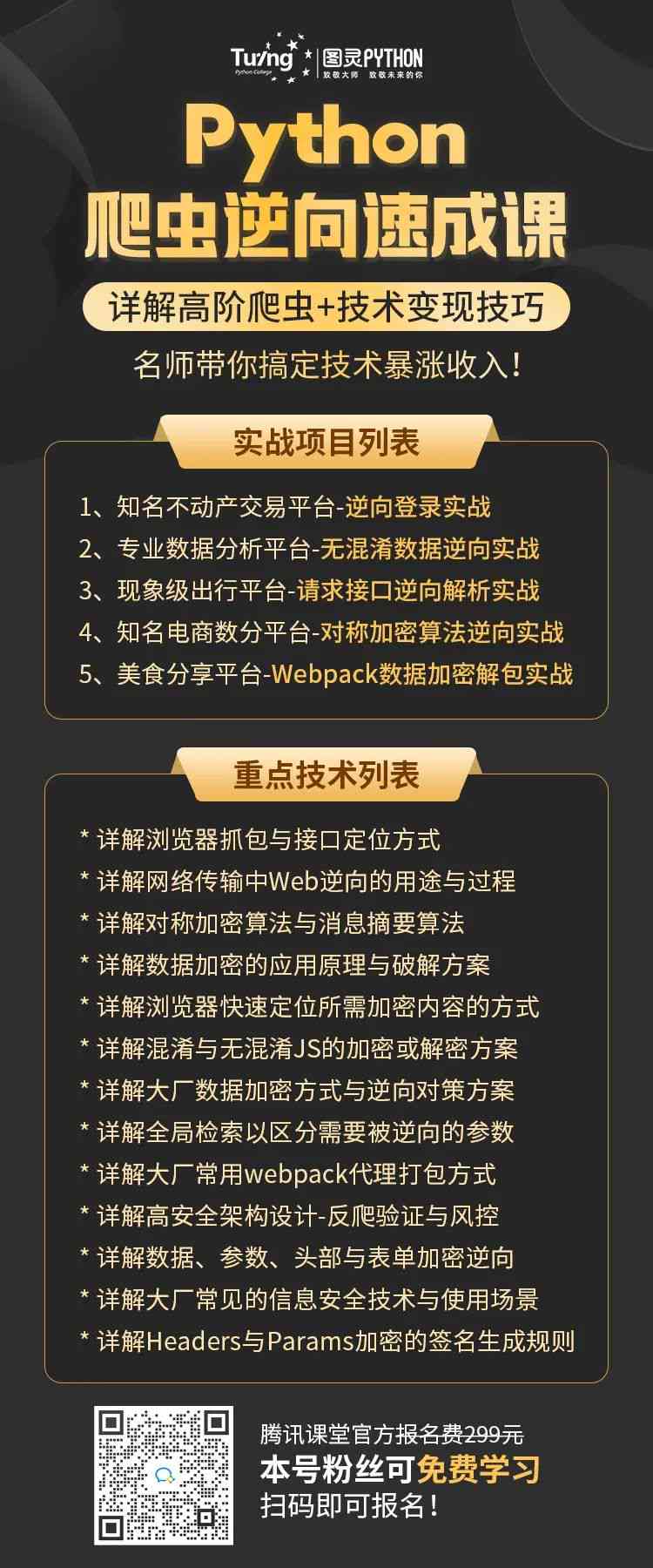

四、常用辅助编写爬虫脚本软件介绍

1. Scrapy:Scrapy是一款强大的爬虫框架,支持多种技术,如深度学、自然语言解决等。

2. BeautifulSoup:BeautifulSoup是一款基于Python的HTML解析库,可方便地提取网页中的数据。

3. Pytesseract:Pytesseract是一款OCR(光学字识别)库,可识别图片中的文字,适用于爬取含有图片验证码的网站。

4. Snipaste:Snipaste是一款截图工具可辅助我们快速获取网页中的数据。

五、实战技巧解析

1. 设置爬虫速度限制:为了防止被目标网站封禁,我们需要设置合适的爬虫速度限制。

2. 利用代理IP:为了避免IP被封,可以利用代理IP实行爬取。

3. 过滤噪声数据:通过正则表达式、关键词过滤等方法,去除噪声数据,增强数据品质。

4. 异常应对:编写爬虫脚本时,要充分考虑异常情况,如网络请求失败、数据解析错误等并实行相应的应对。

5. 数据存:爬取到的数据可实行持久化存,如保存为CSV、JSON等格式。

六、总结

本文从辅助编写爬虫脚本的优势、怎样利用编写爬虫脚本、常用辅助编写爬虫脚本软件介绍以及实战技巧解析等方面,全面介绍了怎么样利用技术提升爬虫脚本的编写效率和品质。期望读者通过本文的学,能够掌握辅助编写爬虫脚本的方法,更好地应对大数据时代的数据获取需求。