文章正文

文章正文

开源文本创作模型代码发布:支持多语言、多场景智能写作全解析

一、引言

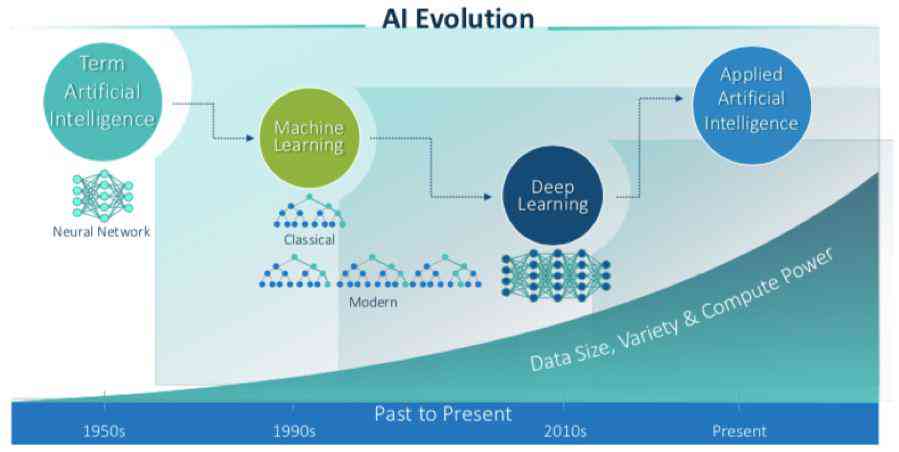

近年来人工智能技术在文本创作领域取得了显著成果各种开源文本创作模型如雨后春笋般涌现。这些模型不仅支持多语言创作还能应对多种场景下的智能写作需求。本文将为您详细介绍这些开源文本创作模型代码并解析其技术特点与应用场景。

二、开源文本创作模型代码概述

1. GPT-3(Generative Pre-trned Transformer 3)

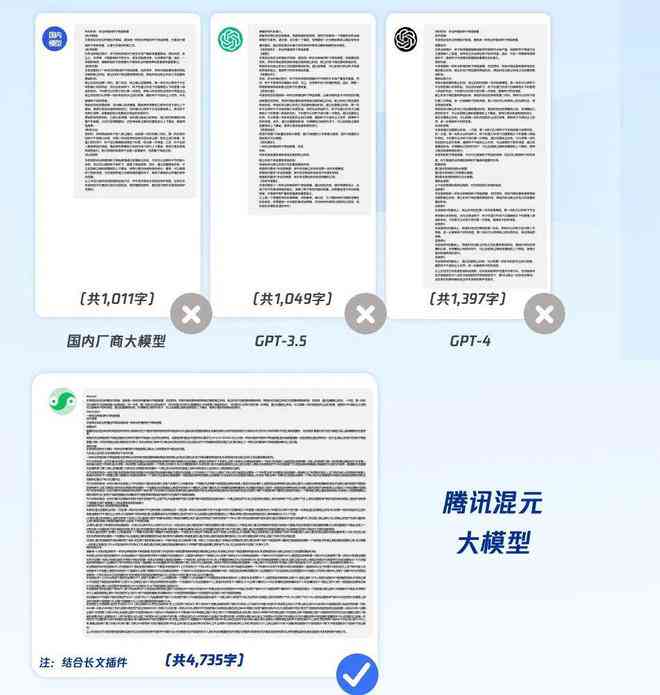

GPT-3是由Open开发的一种大规模预训练语言模型它基于Transformer架构。GPT-3拥有1750亿个参数,是迄今为止更大的语言模型之一。GPT-3支持多语言创作,涵英语、中文、法语、西班牙语等,适用于多种场景下的文本生成。

开源代码:https://github.com/open/gpt-3

2. BERT(Bidirectional Encoder Representations from Transformers)

BERT是由Google开发的一种双向Transformer语言模型。BERT通过预训练和微调的形式实现了对多种语言和场景的文本理解与生成。BERT支持多种语言,如英语、中文、德语等,广泛应用于问答系统、文本分类、情感分析等领域。

开源代码:https://github.com/google-research/bert

3. T5(Text-to-Text Transfer Transformer)

T5是由Google开发的一种通用预训练语言模型。它通过将输入文本转换为序列再生成输出文本的形式实现了对多种语言和场景的文本生成。T5支持多语言,包含英语、中文、法语等,适用于翻译、摘要、问答等任务。

开源代码:https://github.com/google-research/text-to-text-transfer-transformer

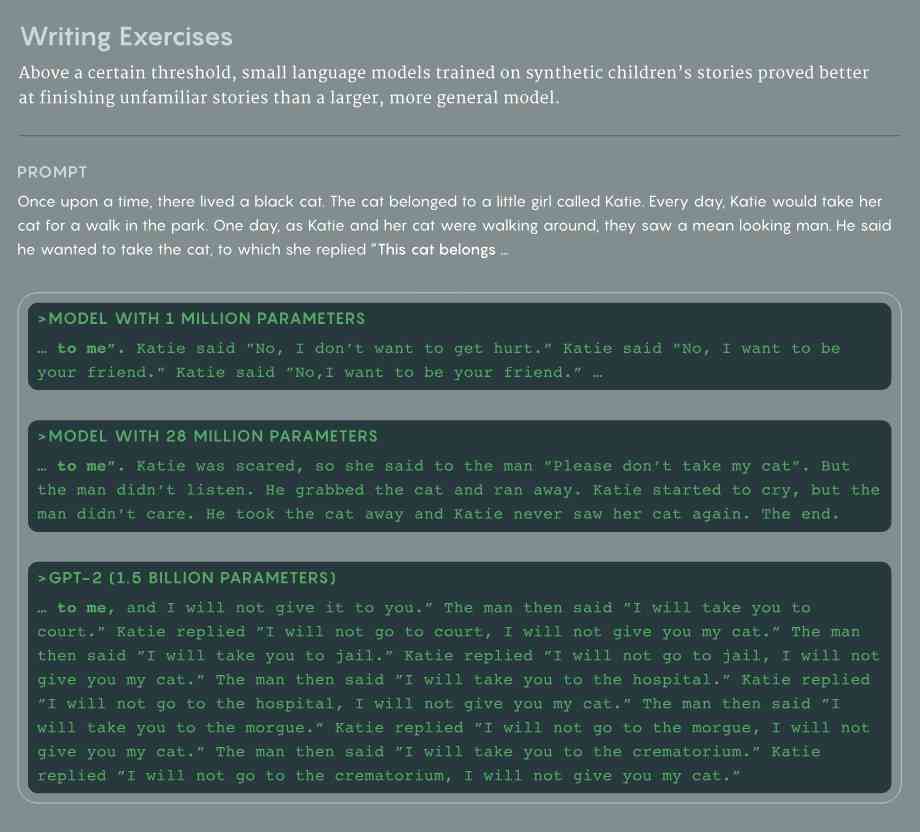

4. GPT-2(Generative Pre-trned Transformer 2)

GPT-2是由Open开发的一种小型预训练语言模型,它基于Transformer架构。GPT-2支持多语言创作涵英语、中文、法语等,适用于文章生成、对话系统等场景。

开源代码:https://github.com/open/gpt-2

5.XLNet(General Language Modeling with Transformer-XL)

XLNet是由和Google开发的一种通用预训练语言模型。它基于Transformer-XL架构,实现了对多种语言和场景的文本生成。XLNet支持多语言,涵英语、中文、法语等,适用于问答、文本分类、情感分析等任务。

开源代码:https://github.com/tensorflow/xlnet

三、技术特点与应用场景

1. 技术特点

(1)多语言支持:以上开源文本创作模型均支持多种语言,可满足不同和地区的需求。

(2)多场景应用:这些模型可以应对多种场景下的文本生成需求,如文章生成、对话系统、问答系统等。

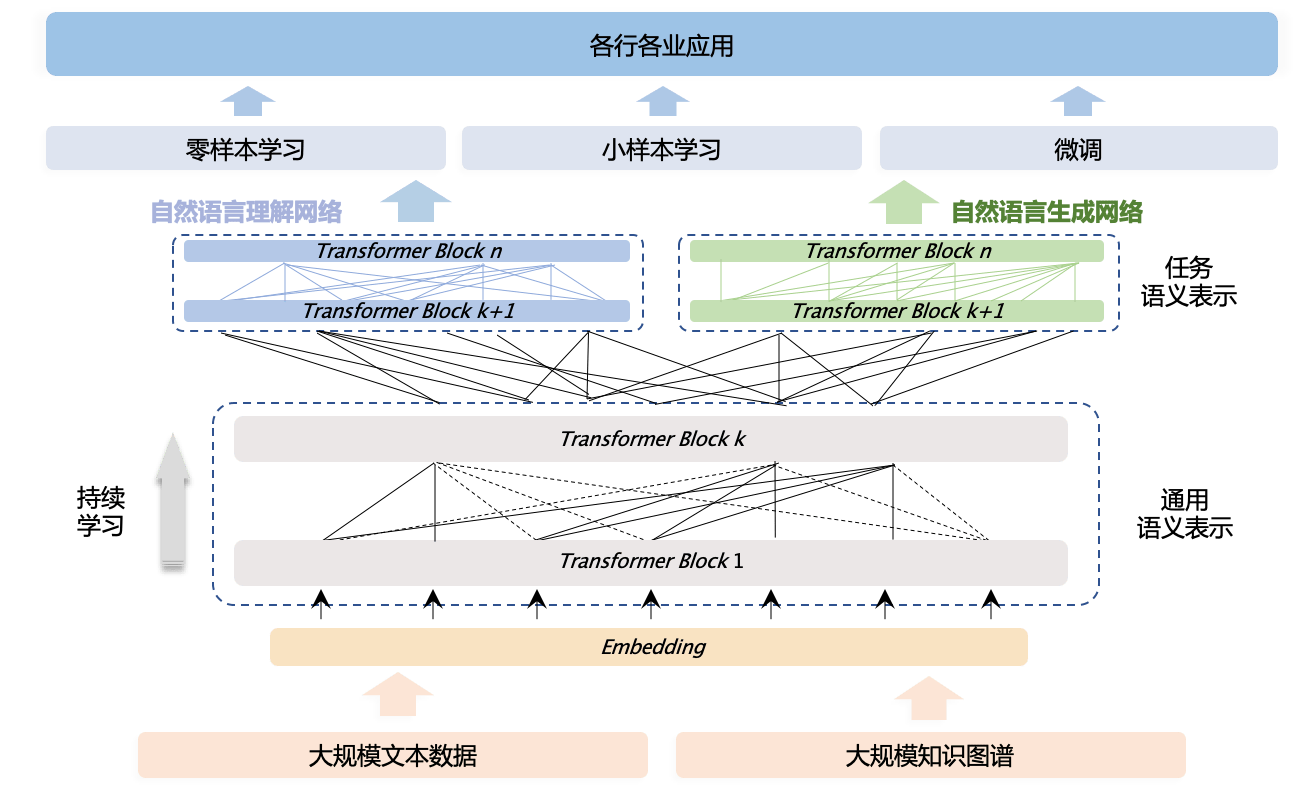

(3)预训练与微调:这些模型通过预训练和微调的形式,实现了对特定任务的优化,升级了生成文本的品质。

2. 应用场景

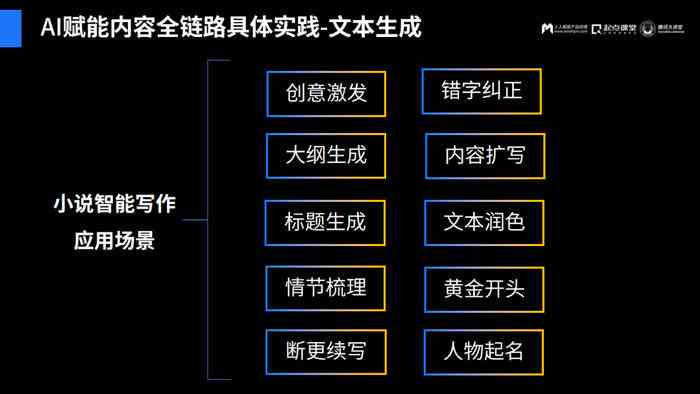

(1)文章生成:利用GPT-3、GPT-2等模型可自动生成新闻报道、博客文章、产品评测等文本。

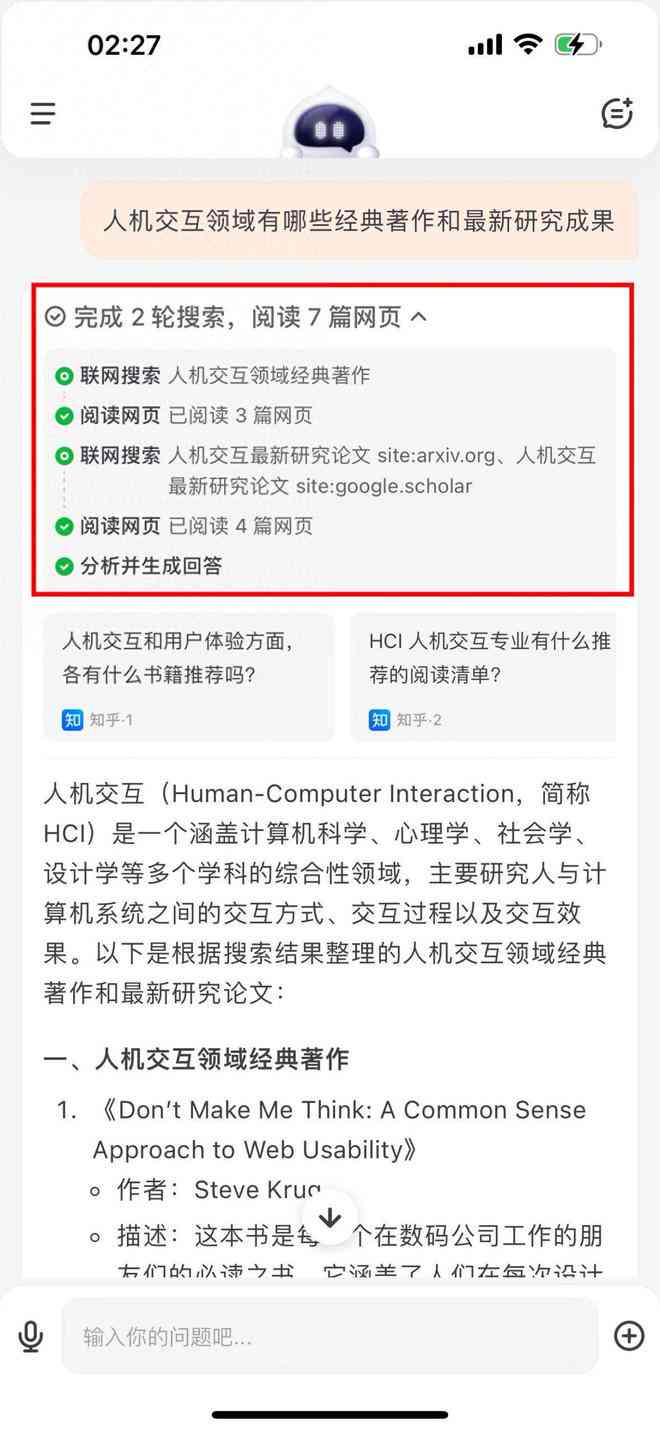

(2)对话系统:借助BERT、T5等模型,可开发出智能对话系统,实现与使用者的自然交流。

(3)问答系统:基于BERT、XLNet等模型,可实现智能问答功能,为使用者提供准确、快速的回答。

(4)文本分类与情感分析:利用BERT、T5等模型,能够对文本实行分类和情感分析,应用于舆情监测、市场调研等领域。

四、总结

随着人工智能技术的发展,开源文本创作模型逐渐成为行业关注的点。这些模型不仅支持多语言创作,还能应对多种场景下的智能写作需求。本文为您介绍了五种主流的开源文本创作模型及其代码,并分析了它们的技术特点与应用场景。相信在未来,这些模型将为文本创作领域带来更多创新与发展。