文章正文

文章正文

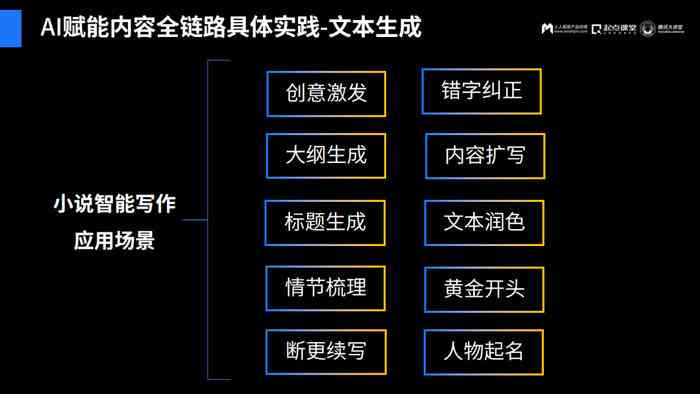

在数字化时代的浪潮中智能写作算法作为一种革命性的技术正在为内容创作领域带来前所未有的变革。无论是新闻报道、营销文案还是学术研究写作算法都能以高效、精准的形式生成和优化内容极大地升级了写作效率和品质。本文将深入探讨智能写作算法的工作原理、技术构成以及其在实际应用中的优势旨在揭示这一技术的核心奥秘和未来发展趋势。

智能写作算法:高效内容生成与优化技术解析

一、写作原理

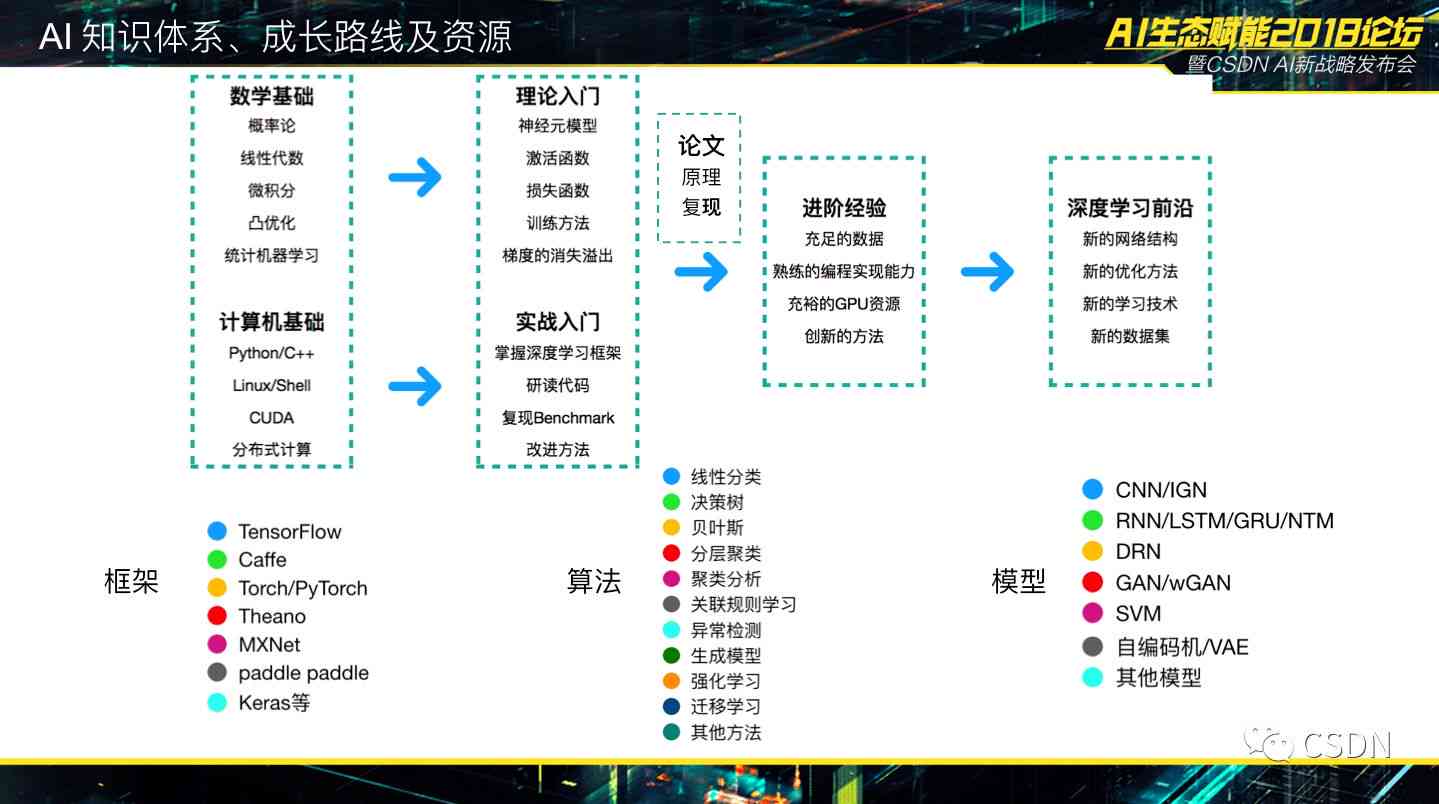

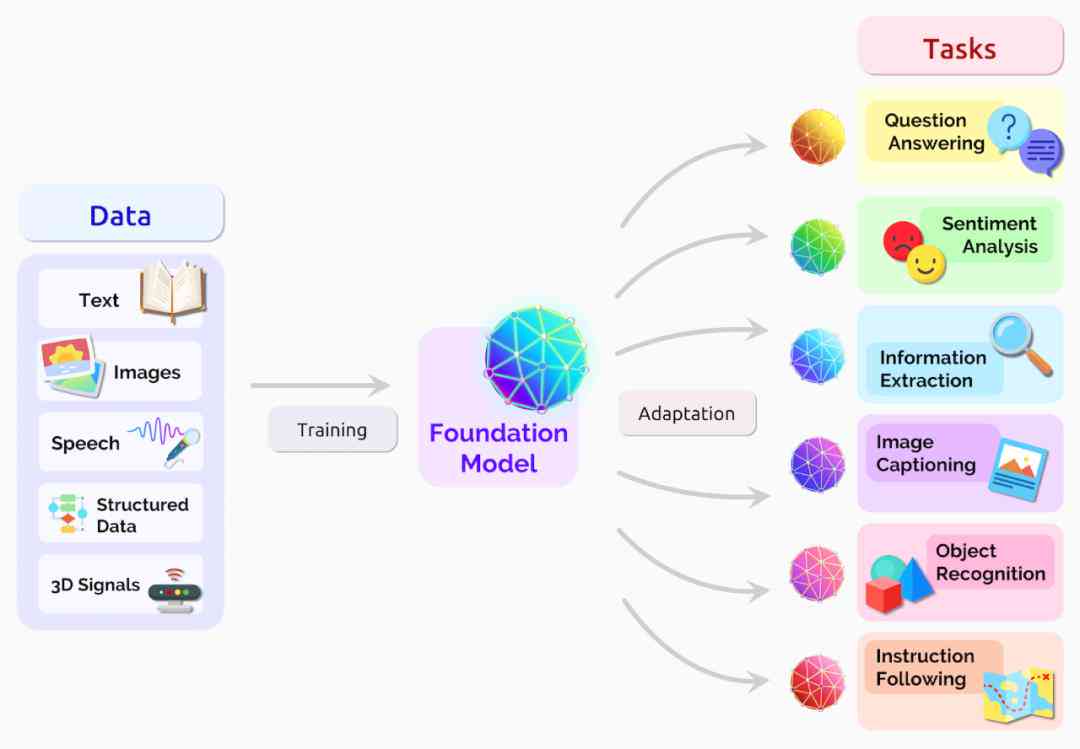

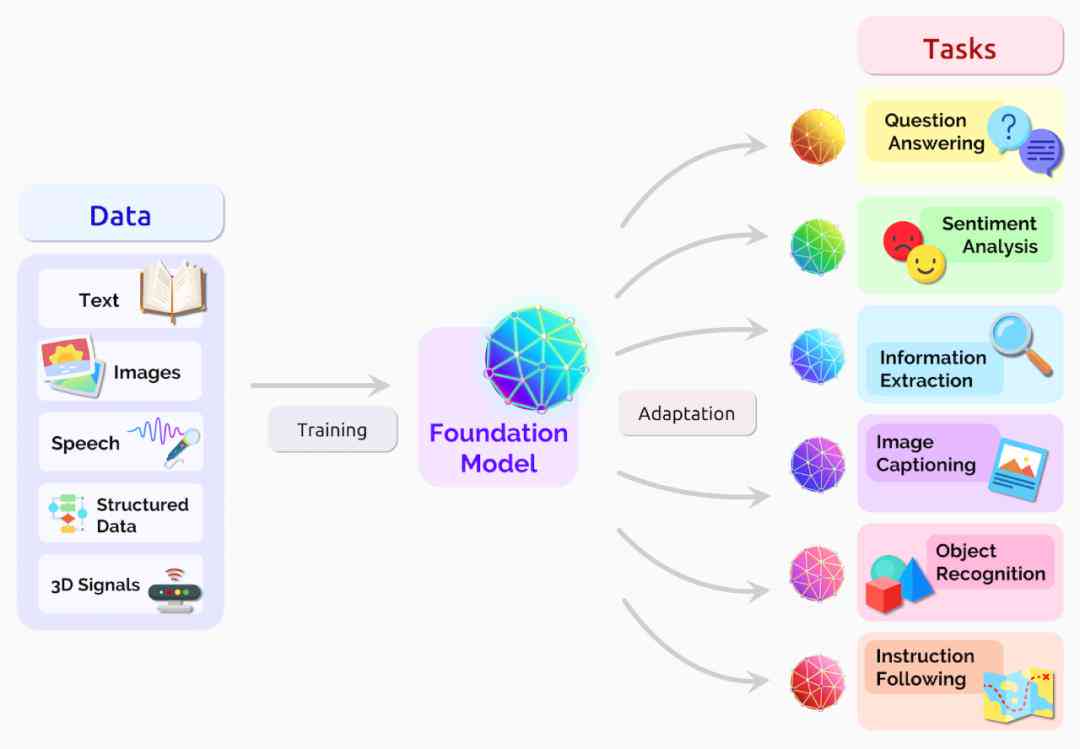

写作算法的原理基于深度学技术通过大量的数据训练使算法可以理解和模仿人类的写作风格。这一过程涵以下几个关键步骤:

1. 数据收集:算法需要大量的文本数据实训练这些数据涵各种类型的文章、书、新闻报道等。

2. 模型训练:通过深度神经网络,算法学文本中的语言规则、语法结构以及上下文关系。

3. 文本生成:训练完成后,算法能够依照客户的需求生成新的文本内容,这些内容在语法和风格上与人类写作相似。

二、写作的含义

写作指的是利用人工智能技术,自动生成或辅助生成文章、报告、故事等文本内容。这类写作方法不仅提升了写作效率,还能够在保证内容优劣的同时实现大规模的内容创作。写作的应用范围广泛,涵但不限于新闻撰写、广告文案、社交媒体内容等。

的算法

写作的核心是算法,以下是几种常见的写作算法:

1. 自然语言解决(NLP)算法:NLP算法是写作的基础,它能够解析和理解自然语言,从而生成连贯、有逻辑的文本。

2. 生成对抗网络(GAN):GAN通过两个神经网络相互竞争生成高品质、多样化的文本内容。

3. 递归神经网络(RNN):RNN算法能够应对序列数据,适用于文本生成任务,生成具有上下文连贯性的文本。

写作模型

写作模型是算法的具体实现,以下是部分主流的写作模型:

1. GPT模型:GPT(Generative Pre-trned Transformer)模型是一种基于Transformer架构的预训练语言模型,它能够生成流畅、自然的文本内容。

2. BERT模型:BERT(Bidirectional Encoder Representations from Transformers)模型是一种双向Transformer模型,它在理解上下文和生成文本方面表现出色。

3. T5模型:T5(Text-to-Text Transfer Transformer)模型是一种通用预训练模型,它能够解决多种文本生成任务,包含翻译、摘要、问答等。

以下是对每个小标题的详细解答:

一、写作原理

写作算法的核心原理在于模仿人类大脑对语言的认知和应对途径。算法通过收集大量的文本数据实训练,这些数据涵了不同领域、不同风格的文本。在训练期间,算法学文本中的语法规则、词汇采用、句子结构等语言特征。

深度神经网络是实现写作的关键技术,它能够通过多层神经元模拟人类大脑的应对能力。通过不断地调整神经元之间的连接权重,算法能够逐步提升对文本数据的理解和生成能力。

二、写作的含义

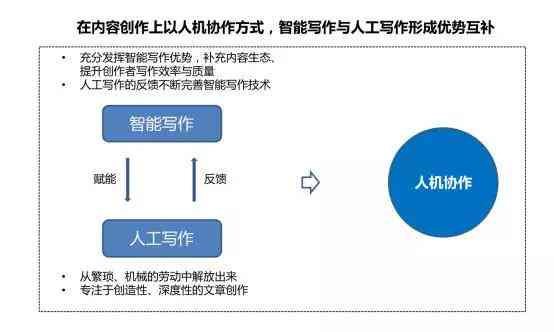

写作的含义不仅限于自动生成文本,它还包含辅助人类写作、优化文本内容等功能。在新闻领域,写作能够快速生成新闻报道,提升新闻的时效性;在营销领域写作可生成吸引人的广告文案,增进营销效果。

写作的意义在于它能够释放人类的创造力,让人类专注于更高层次的思考和创新。同时写作还能够解决大量的数据,生成规模化的内容,满足信息时代对内容的需求。

三、的算法

写作算法的实现依于多种先进的算法,以下是几种常见的写作算法:

1. 自然语言应对(NLP)算法:NLP算法是写作的基础,它涵语言理解、语言生成等多个子任务。通过NLP算法,能够理解文本的含义,生成合语法规则和语义逻辑的文本。

2. 生成对抗网络(GAN):GAN由生成器和判别器两个神经网络组成,生成器负责生成文本,判别器负责判断生成的文本品质。通过相互竞争,GAN能够生成高优劣、多样化的文本内容。

3. 递归神经网络(RNN):RNN算法适用于解决序列数据它能够记住前面的信息,并按照这些信息生成后续的文本。RNN在生成具有上下文连贯性的文本方面表现出色。

四、写作模型

写作模型是基于算法的具体实现,以下是若干主流的写作模型:

1. GPT模型:GPT模型是一种基于Transformer架构的预训练语言模型,它通过大量文本数据的预训练,能够生成流畅、自然的文本内容。GPT模型在文本生成、机器翻译等领域取得了显著的成果。

2. BERT模型:BERT模型是一种双向Transformer模型,它不仅能够理解文本中的单词,还能够理解单词之间的关系。BERT模型在问答、摘要等任务中表现出色。