文章正文

文章正文

一、引言

随着人工智能技术的不断发展脚本在各个领域中的应用越来越广泛。本文将为您详细解析脚本的采用方法、编写技巧、插件采用及存放位置,帮助您更好地理解和运用脚本。

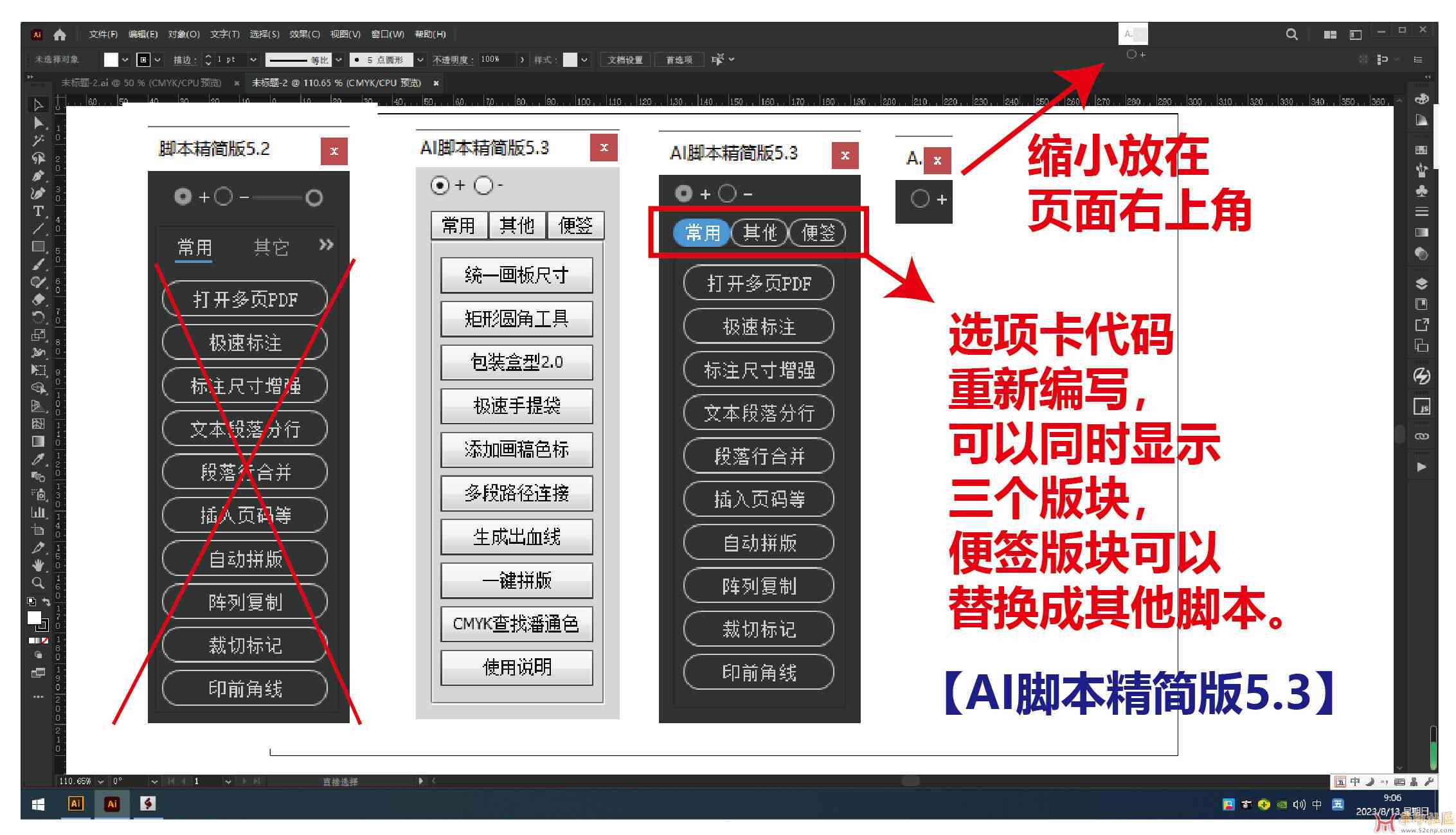

二、脚本怎么用

1. 脚本的基本概念

脚本是一种用于实现人工智能功能的编程语言通过编写脚本,可以使计算机模拟人类的思维和表现,完成特定的任务。脚本往往应用于自然语言应对、机器学、图像识别等领域。

2. 脚本的常见利用场景

(1)自然语言应对:用于实现聊天机器人、智能问答、文本分类等功能。

(2)机器学:用于构建预测模型如回归分析、分类器等。

(3)图像识别:用于识别图像中的物体、人脸等。

3. 脚本的采用方法

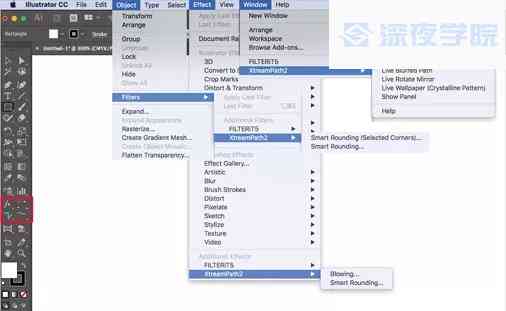

(1)安装开发环境:您需要安装Python等编程语言开发环境,以及相关的库和框架如TensorFlow、PyTorch等。

(2)编写脚本:依照您的需求,编写相应的脚本。以下是一个简单的Python示例:

```python

import numpy as np

from sklearn.linear_model import LogisticRegression

# 加载数据集

data = np.load('data.npy')

# 划分训练集和测试集

trn_data = data[:1000]

test_data = data[1000:]

# 训练模型

model = LogisticRegression()

model.fit(trn_data, trn_labels)

# 预测测试集

predictions = model.predict(test_data)

# 评估模型

accuracy = np.mean(predictions == test_labels)

print('Accuracy:', accuracy)

```

(3)运行脚本:将编写好的脚本保存为.py文件,利用Python等解释器运行。

(4)调试与优化:在脚本运行进展中,按照实际情况实调试和优化。

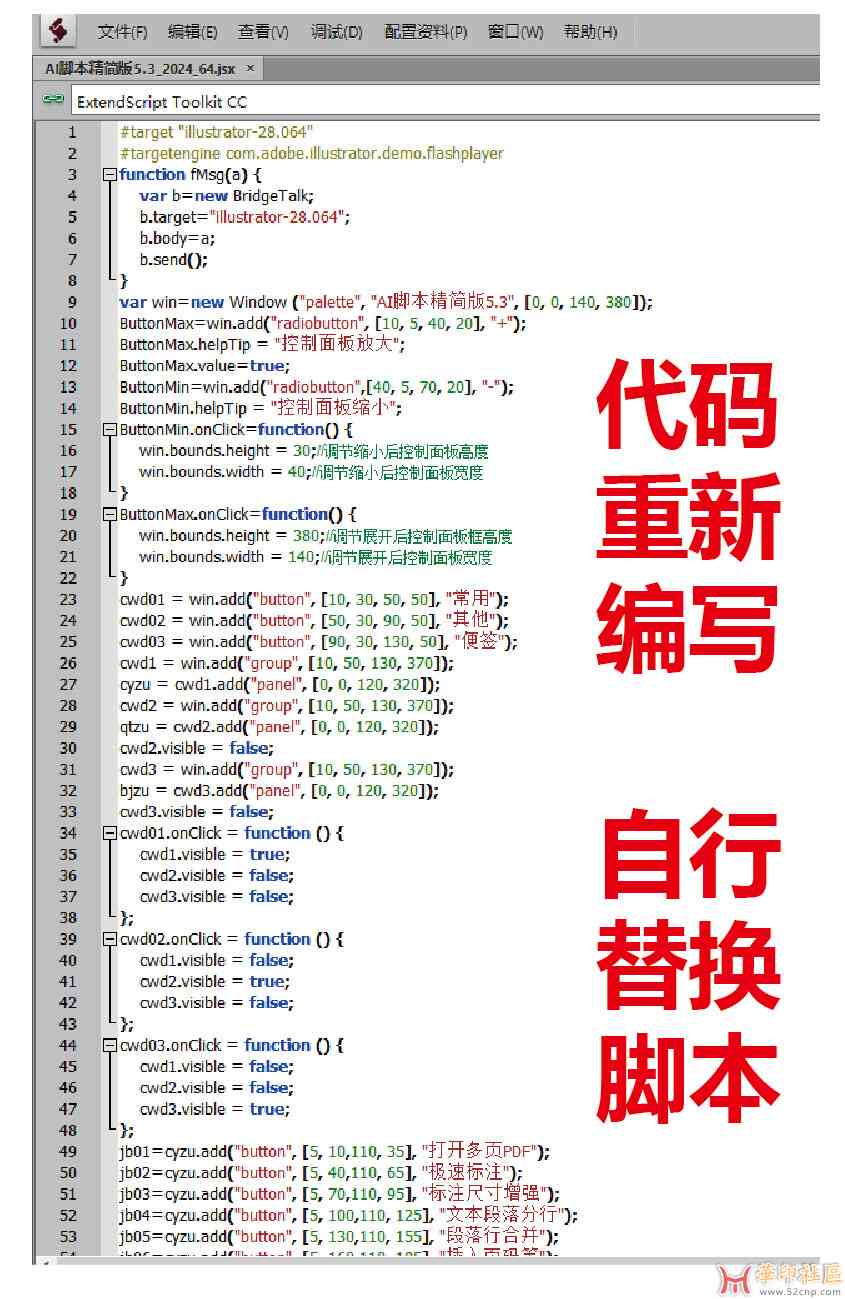

三、脚本怎么写

1. 编写脚本的基本原则

(1)明确需求:在编写脚本之前,首先要明确您的需求,熟悉要实现的功能。

(2)选择合适的框架和库:按照需求,选择合适的框架和库,如TensorFlow、PyTorch、scikit-learn等。

(3)模块化编程:将功能划分为多个模块,便于维护和复用。

(4)注释清晰:在脚本中添加注释说明代码的功能和逻辑。

2. 脚本编写实例

以下是一个简单的线性回归模型编写实例:

```python

import numpy as np

from sklearn.linear_model import LinearRegression

# 加载数据集

data = np.load('data.npy')

# 划分训练集和测试集

trn_data = data[:1000]

test_data = data[1000:]

# 训练模型

model = LinearRegression()

model.fit(trn_data, trn_labels)

# 预测测试集

predictions = model.predict(test_data)

# 评估模型

mse = np.mean((predictions - test_labels) 2)

print('Mean Squared Error:', mse)

```

四、脚本放哪里

1. 脚本存放位置的选择

(1)本地计算机:将脚本保存在本地计算机的文件中,便于管理。

(2)云平台:将脚本保存在云平台上,如GitHub、阿里云等,便于与他人协作和共享。

2. 脚本存放的实践

(1)按功能模块划分:将功能相似的脚本放在同一文件中。

(2)命名规范:采用有意义的文件名便于识别。

(3)版本控制:利用版本控制系统,如Git,对脚本实版本管理。

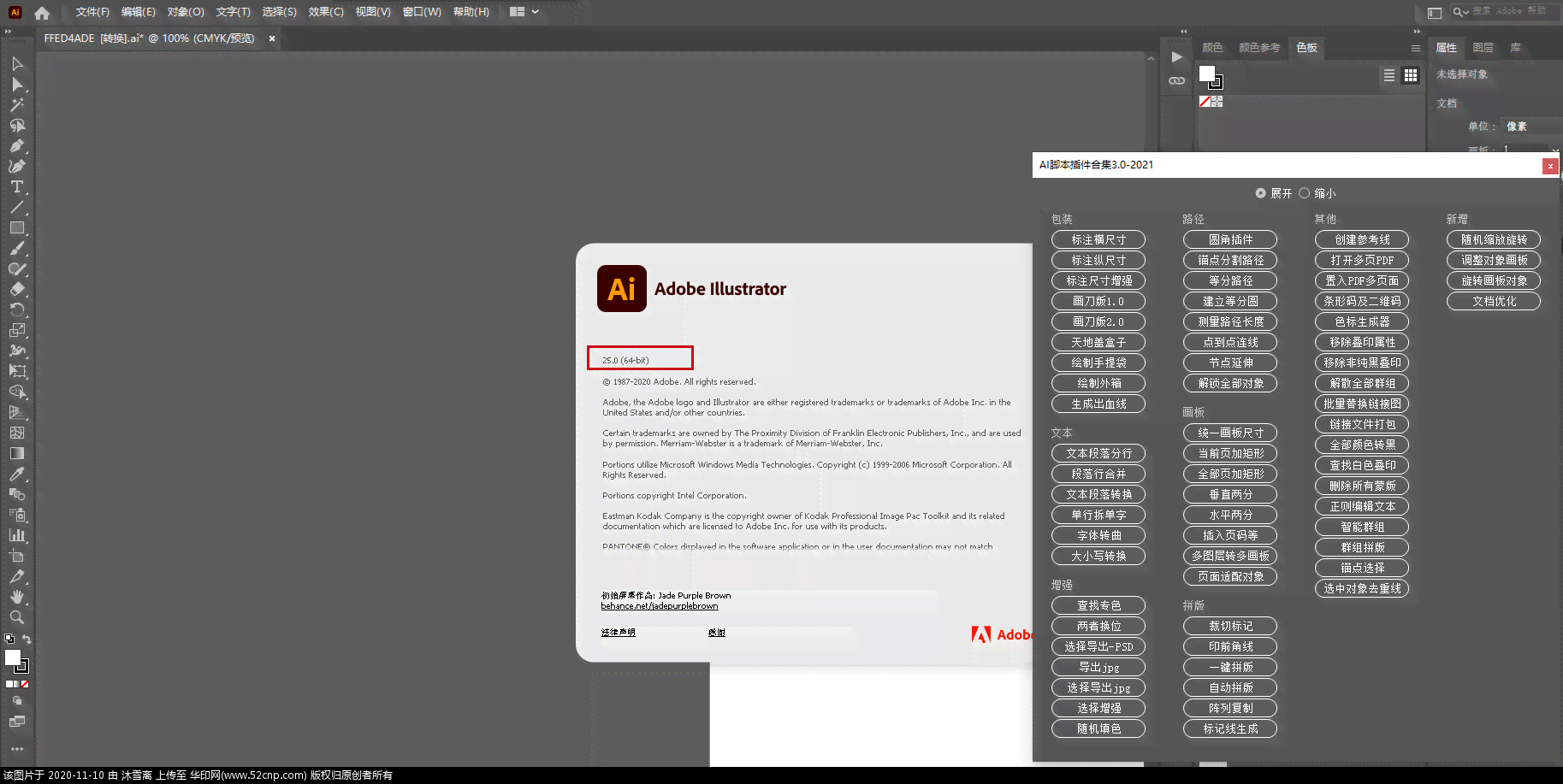

五、2021脚本

1. 2021脚本的特点

2021脚本是一种针对2021年人工智能领域的和应用场景的脚本编写方法。它具有以下特点:

(1)紧跟技术发展趋势:涵自然语言解决、机器学、图像识别等领域的。

(2)实用性:针对实际应用场景,提供实用的脚本编写技巧。

(3)易学易懂:采用简洁明了的编程语言和框架,便于学和掌握。

2. 2021脚本编写实例

以下是一个采用Python和TensorFlow实现卷积神经网络的2021脚本实例:

```python

import tensorflow as tf

# 定义模型

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D(2, 2),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(trn_images, trn_labels, epochs=10)

# 评估模型

test_loss, test_acc = model.evaluate(test_images, test