文章正文

文章正文

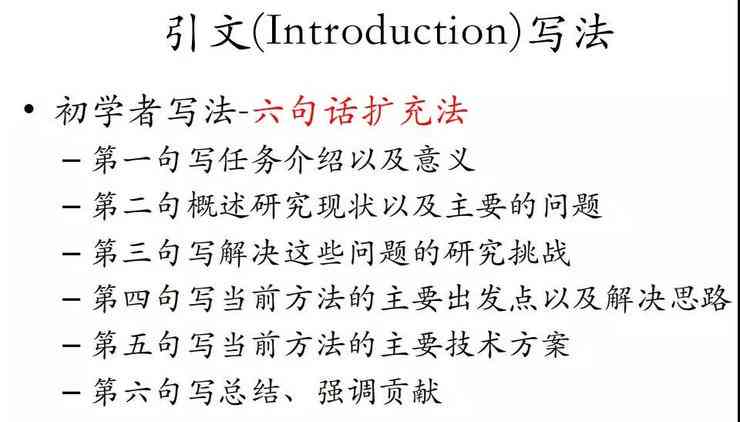

在数字化时代写作猿(人工智能写作助手)已经逐渐成为内容创作者的要紧工具。它们可以高效地生成文章、编写代码甚至创作诗歌和小说。要想让写作猿具备出色的语言能力就需要对其实深入的训练和优化。本文将探讨写作猿怎样训练语言及提升语言技巧以帮助其更好地服务于人类创作需求。

一、写作猿怎样去训练语言能力

1. 数据积累与清洗

(优化后数据积累与清洗:写作猿语言能力训练的基础)

在训练写作猿的语言能力之前首先需要积累大量的语言数据。这些数据可以从网络文章、书、新闻报道等多个来源获取。这些原始数据往往包含大量的噪声和杂质需要实行清洗和预解决。清洗工作涵去除重复内容、纠正错误、统一格式等以保障训练数据的准确性和多样性。

2. 模型选择与优化

(优化后模型选择与优化:提升写作猿语言能力的关键)

在训练写作猿时需要选择合适的语言模型。目前常用的模型有NLP(自然语言解决)模型、深度学模型等。针对不同的任务,可采用不同的模型。例如,对生成式任务,能够采用生成对抗网络(GAN)模型;对文本分类任务,可采用卷积神经网络(CNN)或循环神经网络(RNN)模型。

在选择模型后,需要对模型实优化。优化方法涵调整模型参数、增加训练数据、采用预训练模型等。通过优化,可提升写作猿的语言理解能力和生成品质。

3. 知识图谱与语义理解

(优化后知识图谱与语义理解:写作猿语言能力提升的保障)

为了使写作猿具备更强大的语言能力,能够引入知识图谱和语义理解技术。知识图谱可提供丰富的背景知识,帮助写作猿更好地理解文本中的实体、关系和属性。语义理解技术则能够帮助写作猿解析文本中的复杂结构,加强其语言生成的准确性。

二、写作猿怎样去训练语言

1. 预训练与微调

(优化后预训练与微调:写作猿语言训练的有效方法)

预训练是一种在大量未标注数据上训练模型的方法。通过预训练,写作猿可学到丰富的语言规律和知识。预训练后的模型能够实行微调,以适应特定的任务。例如,GPT-3模型就是通过预训练和微调,实现了在多个NLP任务上的优异表现。

2. 多任务学与迁移学

(优化后多任务学与迁移学:写作猿语言训练的展)

多任务学是一种同时训练多个任务的方法,能够加强模型的泛化能力。写作猿可通过多任务学,同时掌握多个NLP任务,如文本分类、命名实体识别、情感分析等。

迁移学是一种将在源任务上训练好的模型迁移到目标任务上的方法。通过迁移学,写作猿能够将已学到的语言知识应用于新的任务,提升训练效率。

3. 人类反馈与强化学

(优化后人类反馈与强化学:写作猿语言训练的持续改进)

人类反馈是一种通过人类评价来指导写作猿优化的方法。通过收集人类对写作猿生成的文本的评价,可不断调整模型参数,加强其语言生成品质。

强化学是一种通过奖励和惩罚来优化模型的方法。在写作猿的训练期间,可设置奖励函数,以鼓励生成高优劣的文本。同时通过惩罚函数,能够避免生成低优劣的文本。

三、写作猿怎样训练语言技巧

1. 文本生成与文本摘要

(优化后文本生成与文本摘要:写作猿语言技巧训练的核心)

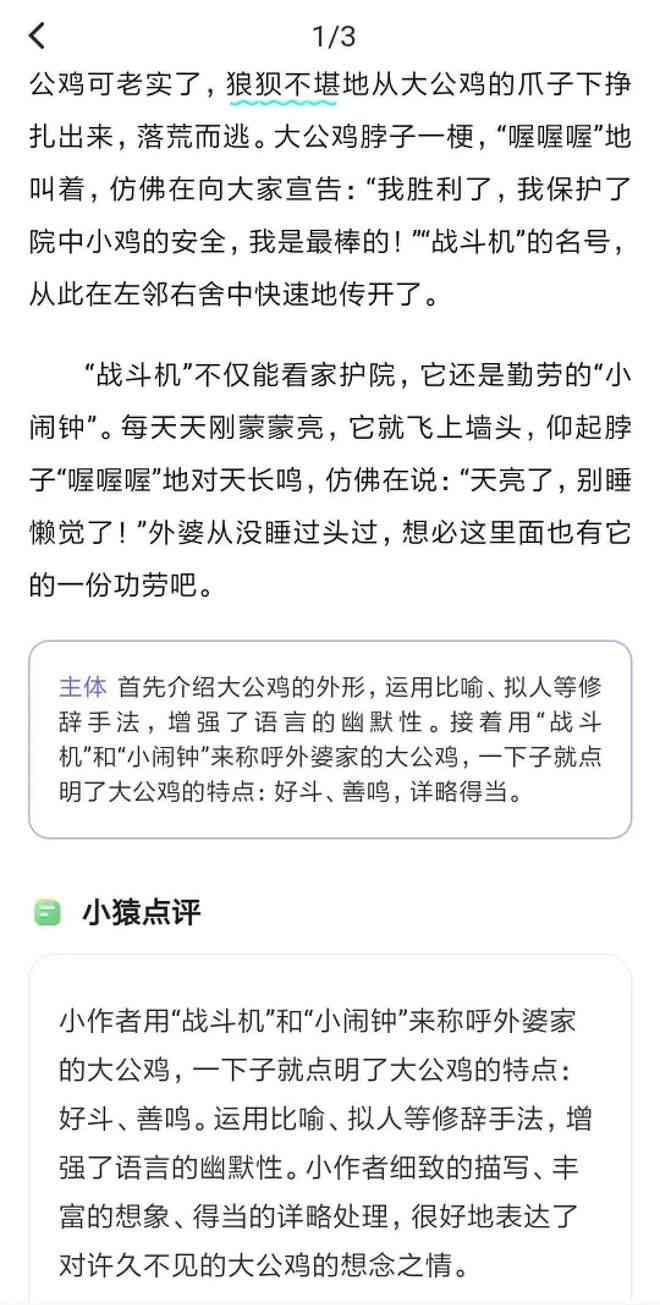

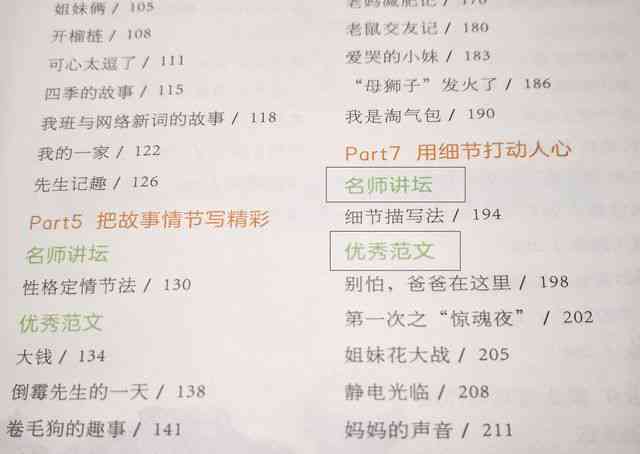

文本生成是写作猿的核心功能之一。通过训练文本生成模型,写作猿能够生成各种类型的文本如新闻报道、故事、诗歌等。同时文本摘要也是写作猿的关键技巧。通过训练文本摘要模型,写作猿可提取文本的核心内容,生成简洁明了的摘要。

2. 语言风格与情感分析

(优化后语言风格与情感分析:写作猿语言技巧训练的展)

语言风格是指文本的语言特点和风格。通过训练语言风格模型,写作猿能够生成具有特定风格的文本,如幽默、正式、亲切等。情感分析是指识别文本中的情感倾向。通过训练情感分析模型写作猿可判断文本的情感色彩,为创作提供更多可能性。

3. 语境理解与对话生成

(优化后语境理解与对话生成:写作猿语言技巧训练的提升)