文章正文

文章正文

在信息爆炸的时代,人工智能()写作逐渐成为内容创作领域的一大亮点。不仅可以高效地生成文章,还能模仿人类的写作风格甚至创造出新颖的内容。本文将深入解析人工智能写作机制的原理与技术要点,揭示其背后的算法逻辑和运作办法帮助咱们更好地理解怎样生成文章,以及它在未来内容创作中的潜力与挑战。

一、写作原理

(以下内容仅为示例,实际内容需依据实际技术和原理实展)

人工智能写作原理

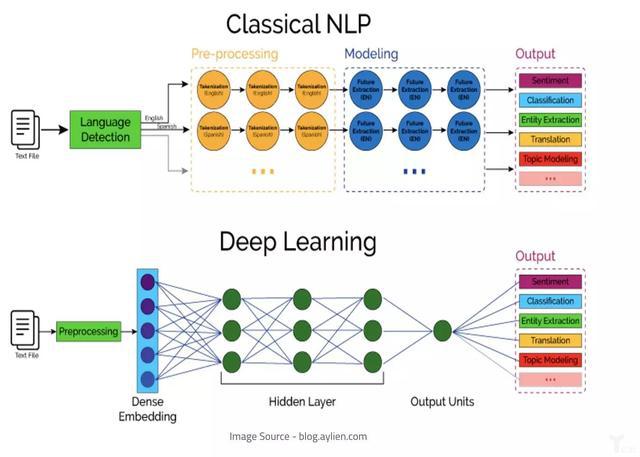

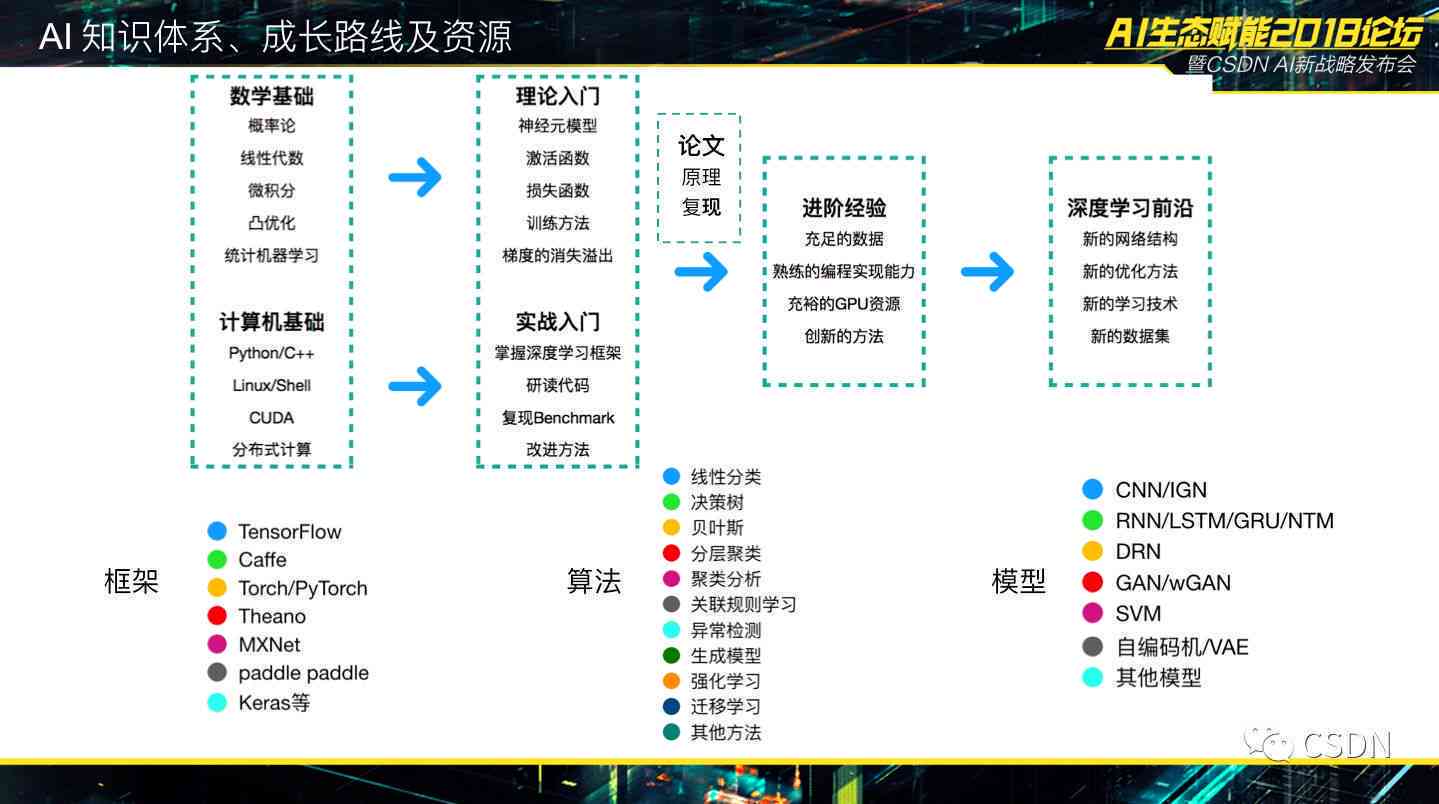

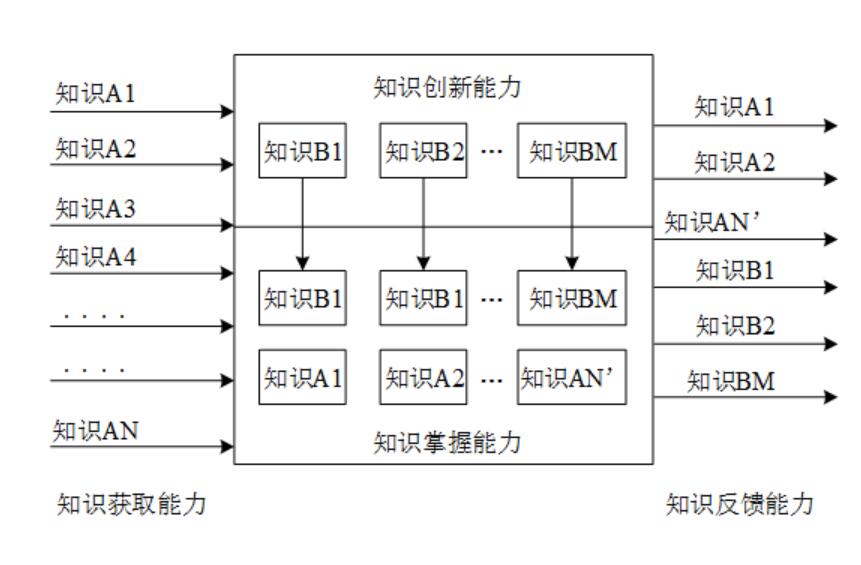

人工智能写作的核心原理是基于自然语言应对(NLP)技术,通过对大量文本数据的学和分析,构建出可以生成文本的模型。以下是写作原理的几个关键步骤:

1. 数据采集与预应对

实小编首先需要大量的文本数据实训练。这些数据多数情况下来源于互联网上的文章、书、新闻报道等。在数据采集后还需要实行预应对包含去除无关信息、标注关键词、分词等,以便于模型更好地学和理解文本内容。

二、写文章的技术要点

(以下内容仅为示例,实际内容需按照实际技术和原理实行展)

写文章的技术要点

1. 语言模型构建

语言模型是写文章的基础,它能够依据上下文预测下一个可能的词语或句子。常见的语言模型有N-gram模型、循环神经网络(RNN)和变换器(Transformer)模型等。其中,Transformer模型因其强大的并行计算能力和高效的上下文捕捉能力,在写作领域得到了广泛应用。

以下为具体的小标题和内容:

### 写作原理

人工智能写作的原理建立在复杂的算法和模型之上。通过大量的数据输入实学,这些数据涵各种文本,如书、文章、网页等。通过对这些文本的分析,能够理解语言的规则、词汇的含义以及句子的结构。关键的原理之一是自然语言解决(NLP),它使得机器能够理解和生成人类语言。

在这个进展中,实小编会采用深度学技术,特别是神经网络,来模拟人类大脑的工作办法。神经网络通过多个层次的解决能够从原始文本中提取出有用的信息,并建立起复杂的模式识别。这些模式识别是生成文章的基础,它能够帮助预测句子中下一个词或短语的可能性。

### 写文章

写文章的过程涉及多个技术要点。首先是文本生成模型的选择,目前更流行的是基于变换器架构的模型,如GPT(生成式预训练)和BERT(双向编码器表示)。这些模型通过预训练和微调,能够生成连贯、有逻辑的文章。

在生成文章时,会遵循一定的写作指导原则,例如保持文章的一致性、连贯性和逻辑性。还会考虑文章的上下文,保障生成的文本与文章的主题和意图相匹配。在生成文章时,会按照特定的目标和风格实行调整,以满足不同的写作需求。

### 模型训练与优化

写作模型的训练和优化是保证生成文章优劣的关键。训练期间,模型会接收到大量的文本数据,并通过这些数据学语言的模式和结构。为了加强模型的性能,研究人员会采用各种技术,如迁移学、对抗训练和强化学。

优化模型的过程包含调整模型的参数、增加训练数据、改进损失函数等。这些优化措有助于提升模型的生成优劣减少错误和偏差并使生成的文章更加自然和流畅。

### 应用挑战与未来展望

尽管写作取得了显著的进展但仍面临部分挑战。例如,生成的文章可能存在事实错误、逻辑漏洞或风格上的不一致。在理解和生成复杂情感或幽默内容方面仍有限制。

未来的研究将致力于应对这些难题并进一步增进写作的能力。这涵开发更先进的模型、改进训练方法、增强的常识和情感理解等。随着技术的不断进步写作有望在新闻、文学、科研等领域发挥更大的作用,为人类创造更多有价值的内容。

通过深入解析写作机制的原理与技术要点,咱们不仅能够更好地理解这一技术的运作办法还能够预见它在未来内容创作领域的巨大潜力。随着技术的不断发展和完善,咱们有理由相信,写作将成为推动人类文明进步的关键力量。