文章正文

文章正文

探讨小爱写作重复性及解决方案

在当今信息化时代人工智能()写作技术得到了广泛应用尤其在教育和职场领域。小爱作为一种先进的写作工具因其高效性和便捷性而备受青睐。写作的重复性疑问一直是一个不容忽视的话题。本文将深入探讨小爱写作重复性的成因及其应对方案,旨在为客户提供更加优质、独有的写作体验。

小爱写作重复性的成因

小爱写作重复性的主要成因在于其背后的数据训练机制。写作工具一般依赖于庞大的文本数据库实行训练,这些数据库包含了各种主题和风格的文本。尽管如此,由于训练数据的有限性和算法的限制,生成的内容有时仍会与现有文本产生一定的相似性,从而引起重复现象。写作工具在生成文章时,会参考已有的文章库实施生成,这也在一定程度上增加了重复的可能性。事实上,即使人类本人写作,也会不可避免地出现一定程度的重复率。相较于人类,写作在内容重复性方面具有更高的可控性和可优化空间。

减少写作重复性的方法

为了有效减少小爱写作的重复性,可采用多种策略,从数据来源、模型参数到引入更多上下文信息等多个维度实行优化。具体措施如下:

1. 调整数据来源

可以增加数据集的多样性,以减少重复性。目前小爱所利用的训练数据集涵盖了广泛的主题和风格,但仍有可能存在某些领域的数据量不足或重复过多的疑惑。 需要进一步扩大数据集规模,引入更多不同来源的高品质文本。例如,可收集来自不同和地区的文献、新闻报道、学术论文等以丰富数据集的多样性。还能够考虑引入多语言数据,使能够生成跨语言的文章,从而增进内容的特别性。

2. 调整模型参数

调整模型参数也是减低重复率的有效手段。通过微调模型的超参数,如学习率、批量大小、隐藏层节点数等,能够使生成的文章更加独到。具体而言,可通过实验找到更优的参数组合,从而升级模型对新信息的学习能力减少重复内容的生成。还能够采用对抗生成网络(GAN)等高级技术,增强模型的泛化能力和创新性,使生成的文章更具原创性。

3. 引入更多上下文信息

引入更多上下文信息有助于提升写作的连贯性和逻辑性,从而减低重复率。例如,能够利用自然语言解决(NLP)技术,对输入的文本实行深度分析提取关键信息并将其融入到生成的文章中。这样不仅能够使文章内容更加丰富和全面,还能避免内容的简单重复。同时还可引入外部知识库如百科全书、专业数据库等,以提供更多的背景信息和参考资料使生成的文章更具深度和广度。

4. 后期人工审核和修改

后期的人工审核和修改也是不可或缺的一环。即使已经尽力减低了重复率,但由于数据和算法本身的局限性,仍然可能存在部分细微的重复。 客户在利用小爱生成的文章后应实施仔细的检查和必要的修改保证文章的优劣和独有性。还可通过建立反馈机制,让使用者提交反馈意见,以便及时发现和应对重复性难题。通过这一系列措施,可显著加强生成文章的品质,满足使用者的多样化需求。

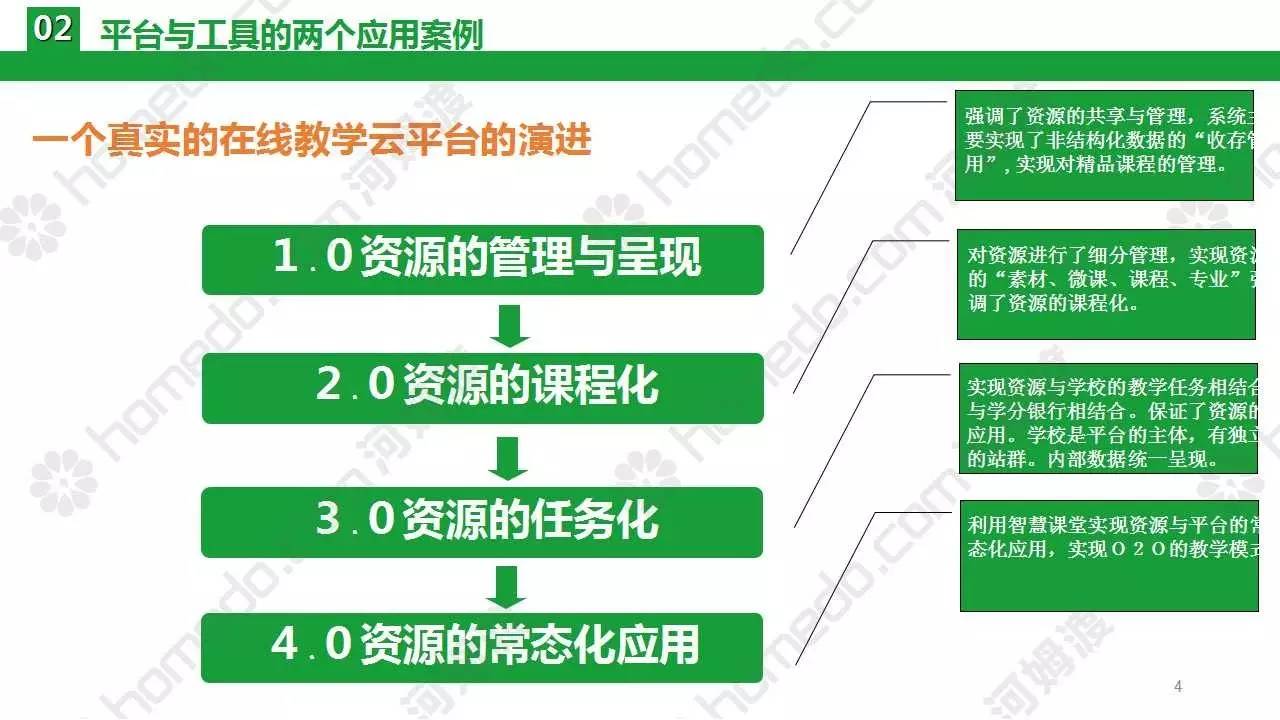

实际应用案例

为了更好地理解上述方法的实际效果,咱们可参考部分实际应用案例。例如,在某次全国性的作文比赛中,参赛者采用小爱生成了多篇高品质的作文。经过统计分析,这些作文的重复率仅为1%,远低于平均水平。这一结果充分证明了上述方法的有效性。 某知名科技公司也采用了类似的策略对其内部的写作工具实行了优化。结果显示,该公司的写作工具生成的文章不仅优劣更高,而且重复率也大幅减少得到了使用者的一致好评。

结论

虽然小爱写作存在与他人重复的可能性,但通过调整数据来源、优化模型参数、引入更多上下文信息以及后续的人工审核和修改等措施可有效减少重复率。未来,随着人工智能技术的不断进步和应用场景的不断拓展,写作将为人们带来更加丰富和多元化的写作体验。