文章正文

文章正文

GPT文本生成:从GPT到GPT-3中文生成全面教程

1. 引言

近年来随着人工智能技术的不断进步生成式预训练语言模型(Generative Pre-trned TransformerGPT)逐渐走进了咱们的视野。GPT模型是由Open提出的一种基于Transformer架构的生成模型。本文旨在为读者提供一个全面的指南介绍怎样利用GPT模型实施文本生成并重点探讨从GPT到GPT-3的发展历程及应用。

2. GPT模型简介

GPT模型的核心在于其强大的文本生成能力。它结合了预训练阶段和微调阶段两个步骤,实现了高效的文本生成功能。在预训练阶段GPT模型通过对大量文本数据的学习,掌握了丰富的语言知识。而在微调阶段,模型则可以依据特定任务实施调整,以达到更好的性能。

3. GPT模型的实现步骤

# 3.1 预训练阶段

预训练阶段是GPT模型的基础。在这个阶段,模型通过大规模的无监督学习从海量文本数据中提取语言模式和语义信息。具体而言,模型会通过自回归的办法预测下一个词或字符,从而不断优化自身的参数。预训练阶段的成功与否,直接决定了模型后续表现的优劣。

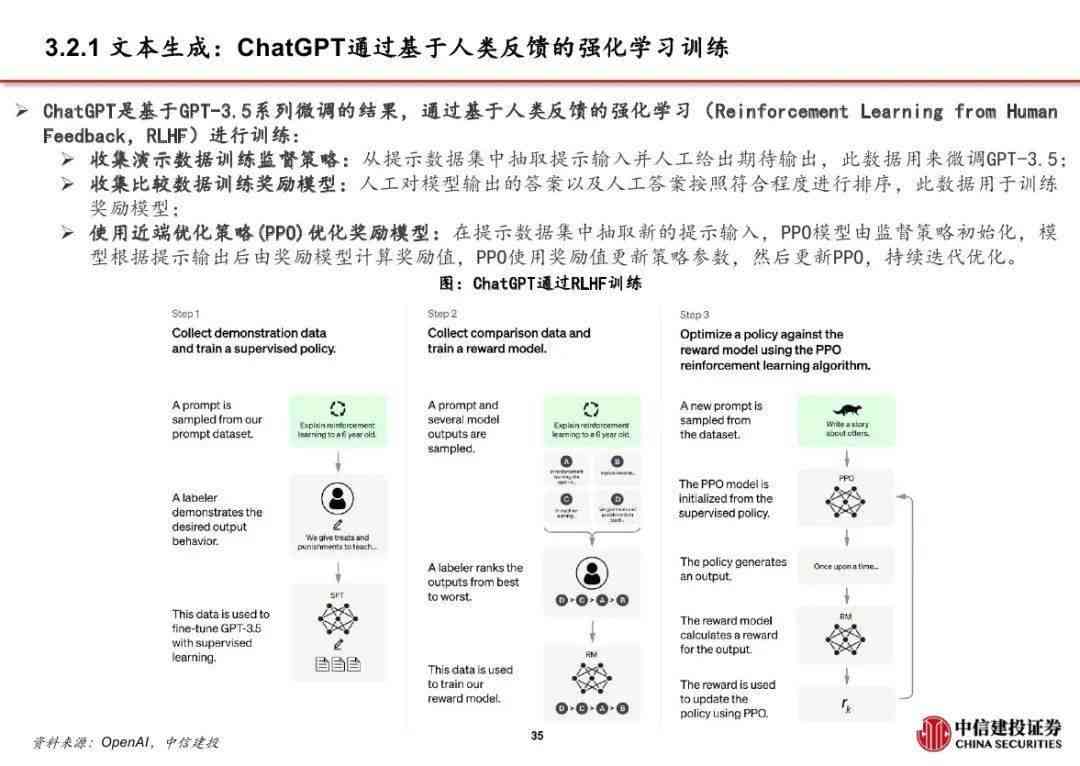

# 3.2 微调阶段

微调阶段则是对预训练模型实施进一步优化的过程。在这个阶段模型会依照特定的任务需求,通过有监督学习的办法实施调整。例如,在文本生成任务中,模型可以通过微调阶段学习到更加准确的语言表达形式,从而增强生成文本的优劣。微调阶段多数情况下需要大量的标注数据和计算资源,但最终能够显著提升模型的性能。

4. GPT模型的应用

GPT模型在多个领域都有着广泛的应用。例如,在自然语言应对任务中,GPT模型能够用于自动摘要、机器翻译、问答系统等场景。GPT模型还可应用于创意写作、聊天机器人等领域,为客户提供高优劣的文本内容。

5. 采用Python工具实施GPT文本生成

在实际应用中咱们常常需要借助Python工具来实现GPT模型的文本生成功能。以下是一个简单的示例代码,展示了怎样去采用Python实施GPT文本生成:

```python

from transformers import GPT2LMHeadModel, GPT2Tokenizer

# 加载预训练模型和分词器

model_name = 'gpt2'

tokenizer = GPT2Tokenizer.from_pretrned(model_name)

model = GPT2LMHeadModel.from_pretrned(model_name)

# 输入提示

input_text = Once upon a time in a land far, far away,

# 分词

input_ids = tokenizer.encode(input_text, return_tensors='pt')

# 生成文本

output = model.generate(

input_ids,

max_length=100,

temperature=0.7,

num_return_sequences=1

)

# 解码输出

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

```

上述代码首先加载了预训练的GPT2模型及其对应的分词器。 通过输入提示文本模型生成了一段新的文本内容。 通过解码输出结果,咱们能够看到生成的文本内容。

6. Microsoft Power Automate流的利用

除了Python工具外我们还能够通过Microsoft Power Automate来实现GPT文本生成。具体对于,我们能够采用Builder中的“采用提示通过GPT创建文本”模型。以下是一个简单的示例流程,展示了怎样去在Microsoft Power Automate中利用GPT模型生成文本:

1. 创建一个新的Power Automate流。

2. 添加一个触发器,例如“当HTTP请求接收到时”。

3. 添加一个操作选择“Builder中的‘采用提示通过GPT创建文本’”。

4. 在操作中设置输入提示文本。

5. 运行流并查看生成的文本内容。

通过此类方法,我们可在无需编写代码的情况下,快速实现GPT文本生成功能。

7. GPT-3模型简介

随着技术的不断发展,GPT模型也在不断地升级。最新的GPT-3模型具有更强大的语言生成能力。与之前的版本相比GPT-3在以下几个方面实行了改进:

- 更大的模型规模:GPT-3拥有更多的参数,使其能够更好地捕捉复杂的语言结构。

- 更多的训练数据:GPT-3利用了更多的训练数据,从而增强了模型的泛化能力。

- 更高的生成优劣:GPT-3生成的文本更加流畅、自然,且更具逻辑性。

8. GPT-3的应用案例

GPT-3已经在多个领域得到了广泛应用。例如,在自然语言应对任务中,GPT-3能够用于自动摘要、机器翻译、问答系统等场景。GPT-3还可应用于创意写作、聊天机器人等领域,为客户提供高优劣的文本内容。以下是部分具体的案例:

- 自动摘要:GPT-3能够自动生成新闻文章的摘要,帮助客户快速熟悉主要内容。

- 机器翻译:GPT-3可实现高品质的多语言翻译,满足不同客户的语言需求。

- 问答系统:GPT-3能够回答各种复杂的难题,提供准确的答案。

9. 结论

GPT模型作为一种强大的文本生成工具,在自然语言应对领域有着广泛的应用前景。无论是采用Python工具还是Microsoft Power Automate,我们都可轻松地实现GPT文本生成功能。未来,随着技术的不断进步,GPT模型将会在更多领域发挥要紧作用。期待本文能够为读者提供一个全面的指南,帮助大家更好地理解和应用GPT模型。