文章正文

文章正文

在数字化时代的浪潮中人工智能技术正以前所未有的速度发展其中写作模型作为一种创新的技术应用已经引起了广泛关注。它不仅可以增进写作效率还能辅助创作出高优劣的内容。本文将深入探讨写作模型的训练方法、开源模型的选择以及对比不同模型的性能旨在为研究者和开发者提供有价值的参考。

引言

随着互联网信息的爆炸性增长人们对高效、准确的信息应对和内容生成的需求日益增强。写作模型应运而生它通过模拟人类写作过程可以自动生成文章、报告、故事等多种类型的内容。写作模型的训练是一个复杂而挑战性的任务涉及到大量的数据准备、模型选择、参数调整等多个环节。本文将从写作模型的训练方法、开源模型的选择和对比等方面入手探讨怎么样更好地利用这些技术,以及推荐部分值得关注的写作模型。

写作模型训练

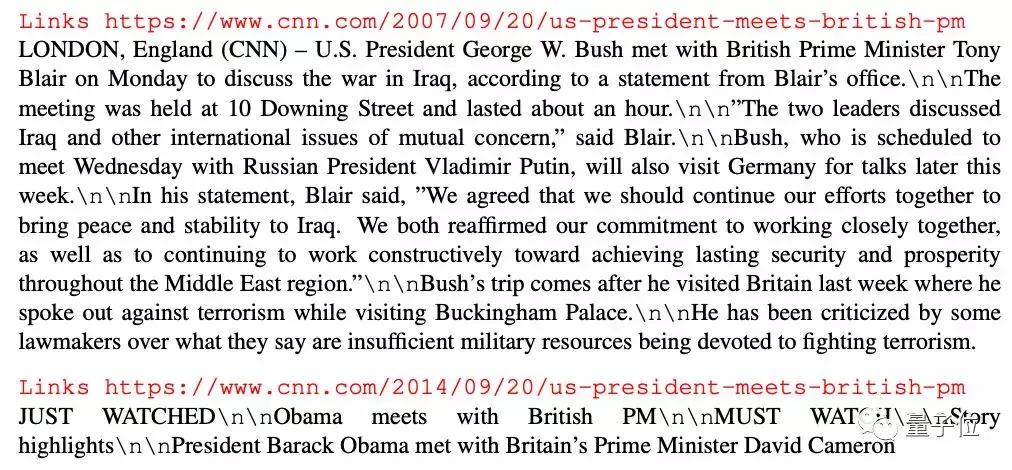

写作模型的训练是整个进展中的核心环节。需要收集大量的文本数据,这些数据应涵盖多样化的主题和风格,以确信模型的泛化能力。通过预应对数据,清洗和标注文本,为模型提供高优劣的学习材料。

在训练进展中选择合适的模型架构至关关键。目前基于Transformer的模型如BERT、GPT等,因其强大的语言解决能力而广受欢迎。训练时,需要调整学习率、批次大小等超参数,以及采用正则化、dropout等技术来防止过拟合。

评估模型的性能也是训练进展中不可或缺的一环。常用的评估指标包含BLEU分数、ROUGE分数等,它们可以衡量生成的文本与参考文本之间的相似度。

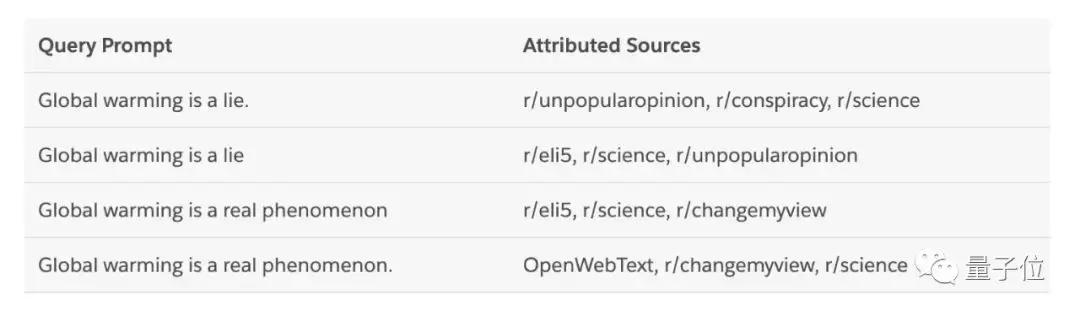

写作模型对比

目前市场上存在多种写作模型,它们各有特点。以BERT和GPT为例,BERT模型在解决长文本和上下文理解方面表现出色,而GPT模型则更擅长生成连贯、有逻辑的文本。

BERT模型通过双向关注力机制,能够更准确地理解上下文信息,适用于需要深入理解文本内容的场景,如问答系统、文本摘要等。而GPT模型则通过单向关注力机制,虽然在上下文理解上略有不足,但生成的文本流畅自然适用于文章写作、故事创作等。

除了BERT和GPT,还有许多其他开源模型如XLNet、RoBERTa等,它们在特定任务上也有很好的表现。通过对比这些模型,开发者能够按照自身的需求选择最合适的模型。

写作模型开源

开源写作模型的出现,极大地推动了这一领域的发展。开源模型不仅为研究者提供了便捷的工具,也促进了技术的交流和共享。

目前许多知名的开源项目如Hugging Face的Transformers库,提供了大量的预训练模型和工具,使得开发者能够轻松地加载和部署模型。开源社区也提供了丰富的教程和案例,帮助新手快速入门。

选择开源模型时,需要考虑模型的稳定性、社区活跃度、文档完整性等因素。一个活跃的开源项目多数情况下会有更多的贡献者,能够及时修复疑问和更新功能。

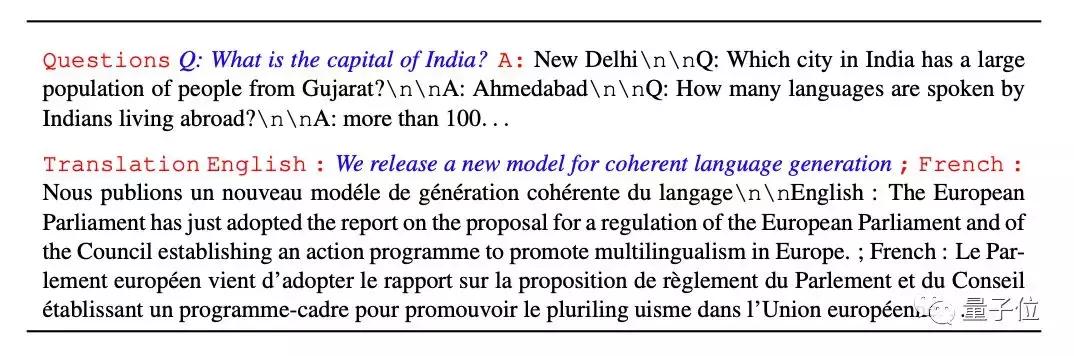

写作模型怎么训练

写作模型的训练是一个系统性的工程。以下是训练进展中的部分关键步骤:

1. 数据准备:收集和清洗大量的文本数据,保证数据的多样性和优劣。

2. 模型选择:依据任务需求选择合适的模型架构,如BERT、GPT等。

3. 参数调整:通过实验确定的学习率、批次大小等超参数。

4. 训练与评估:采用训练数据训练模型,并利用验证数据评估模型性能。

5. 迭代优化:依据评估结果调整模型参数,实施迭代优化。

在训练进展中,还需要采用若干技巧,如数据增强、迁移学习等,以增进模型的性能和泛化能力。

写作模型推荐

针对不同的应用场景,以下是若干值得推荐的写作模型:

- BERT:适用于需要深入理解文本内容的任务,如问答系统、文本摘要等。

- GPT-3:具有极高的语言生成能力,适用于文章写作、故事创作等。

- RoBERTa:在多种NLP任务上表现出色,是一个全能型的模型。

- XLNet:在长文本解决上有优势,适用于文档生成、问答系统等。

开发者可依照本人的需求,选择最合适的模型实施开发和部署。

结语

写作模型作为一种新兴的技术,正在逐渐改变咱们的写作办法。通过深入探讨写作模型的训练方法、对比不同模型的特点,以及推荐优秀的开源模型,我们期待能够为这一领域的研究者和开发者提供有价值的参考。随着技术的不断进步,相信写作模型将会在更多领域发挥要紧作用,为人类创造更多的价值。