文章正文

文章正文

爬虫软件实训报告:项目实训与总结感想实践记录及内容梳理

一、项目背景与目的

在当今信息爆炸的时代怎样高效地从海量的互联网数据中提取有价值的信息成为了一个要紧课题。本次实训旨在通过实践操作深入理解网络爬虫的原理、技术与应用评估不同等待机制在动态网页爬虫中的性能差异,并掌握Python动态网页爬虫的开发与优化方法。

二、项目实训内容

1. 熟悉爬虫基本原理

- 网络爬虫通过模拟浏览器发送HTTP请求,获取网页内容。

- 通过解析网页内容,提取所需信息。

2. 掌握常用爬虫框架

- Scrapy框架:一套成熟、快速、高层次的Python爬虫框架。

- Portia框架:可视化爬取网页,无需编程基础。

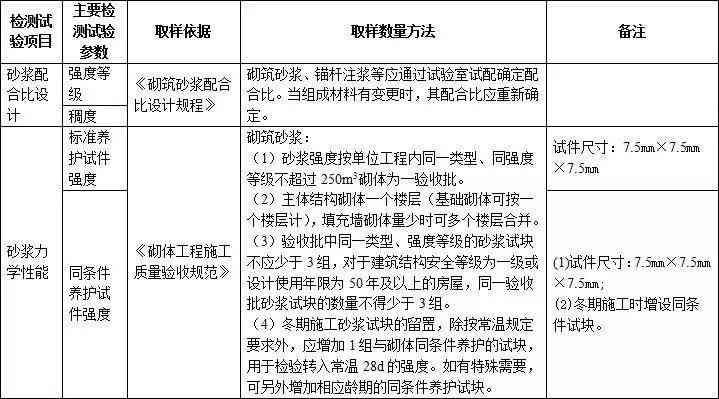

3. 评估不同等待机制

- 随机等待时间:在请求之间设置随机等待时间减低被封禁风险。

- 固定等待时间:在请求之间设置固定等待时间,增强爬取效率。

4. 编写爬虫代码

- 采用Python的requests库发送HTTP请求。

- 利用BeautifulSoup或XPath解析网页内容。

- 存爬取到的数据。

三、项目实践记录

1. 实训前期准备

- 学Python基础知识。

- 理解网络爬虫的基本原理。

2. 搭建开发环境

- 安装Python、Scrapy框架、requests库等。

- 配置爬虫框架的基本参数。

3. 编写爬虫代码

- 分析目标网页结构,确定爬取数据类型。

- 编写爬虫代码,实现数据抓取。

4. 等待机制实验

- 设置随机等待时间观察爬取效果。

- 设置固定等待时间观察爬取效果。

- 对比分析两种等待机制的性能差异。

5. 数据存与解决

- 将爬取到的数据存到数据库或文件中。

- 对数据实清洗、去重等解决。

四、项目总结与感想

1. 技术收获

- 掌握了Python网络爬虫的基本原理和开发技巧。

- 熟悉了不同爬虫框架的采用方法和优缺点。

- 学会了评估不同等待机制对爬取效果的作用。

2. 实践经验

- 实践中发现,合理设置等待时间可以减低被封禁的风险,升级爬取效率。

- 遇到疑惑时,通过查阅资料、请教同学和老师,逐步应对疑问。

3. 感想与展望

- 网络爬虫技术在数据应对、信息挖掘等领域具有广泛应用。

- 未来将继续深入研究爬虫技术,探索更多实用功能和应用场景。

五、内容梳理

1. 项目背景与目的

- 介绍项目背景和目的,明确实训目标。

2. 项目实训内容

- 概述实训内容,包含爬虫基本原理、常用框架、等待机制等。

3. 项目实践记录

- 记录实训过程,包含前期准备、环境搭建、代码编写等。

4. 项目总结与感想

- 总结实训收获,分享实践经验,展望未来发展方向。

5. 内容梳理

- 对项目实训报告实行内容梳理,使结构更加清晰。

通过本次实训,我对网络爬虫技术有了更深入的理解,不仅掌握了基本的爬虫原理和开发技巧,还学会了评估不同等待机制的性能差异。未来我将继续深入研究爬虫技术,为我国信息产业的发展贡献自身的力量。