文章正文

文章正文

怎样自身部署写作模型:软件教程与详细步骤

随着人工智能技术的不断发展写作模型逐渐成为辅助咱们增强写作效率、优化文本品质的要紧工具。那么怎样本人部署一个写作模型呢?本文将为您详细介绍部署写作模型的软件教程与详细步骤。

一、什么是写作模型?

写作模型是一种基于深度学技术的自然语言解决模型,它可以通过学大量文本数据,掌握语言规律,进而生成具有连贯性、合理性的文章。目前常见的写作模型有GPT(生成式预训练模型)、BERT(双向编码器表示模型)等。

二、部署写作模型的准备工作

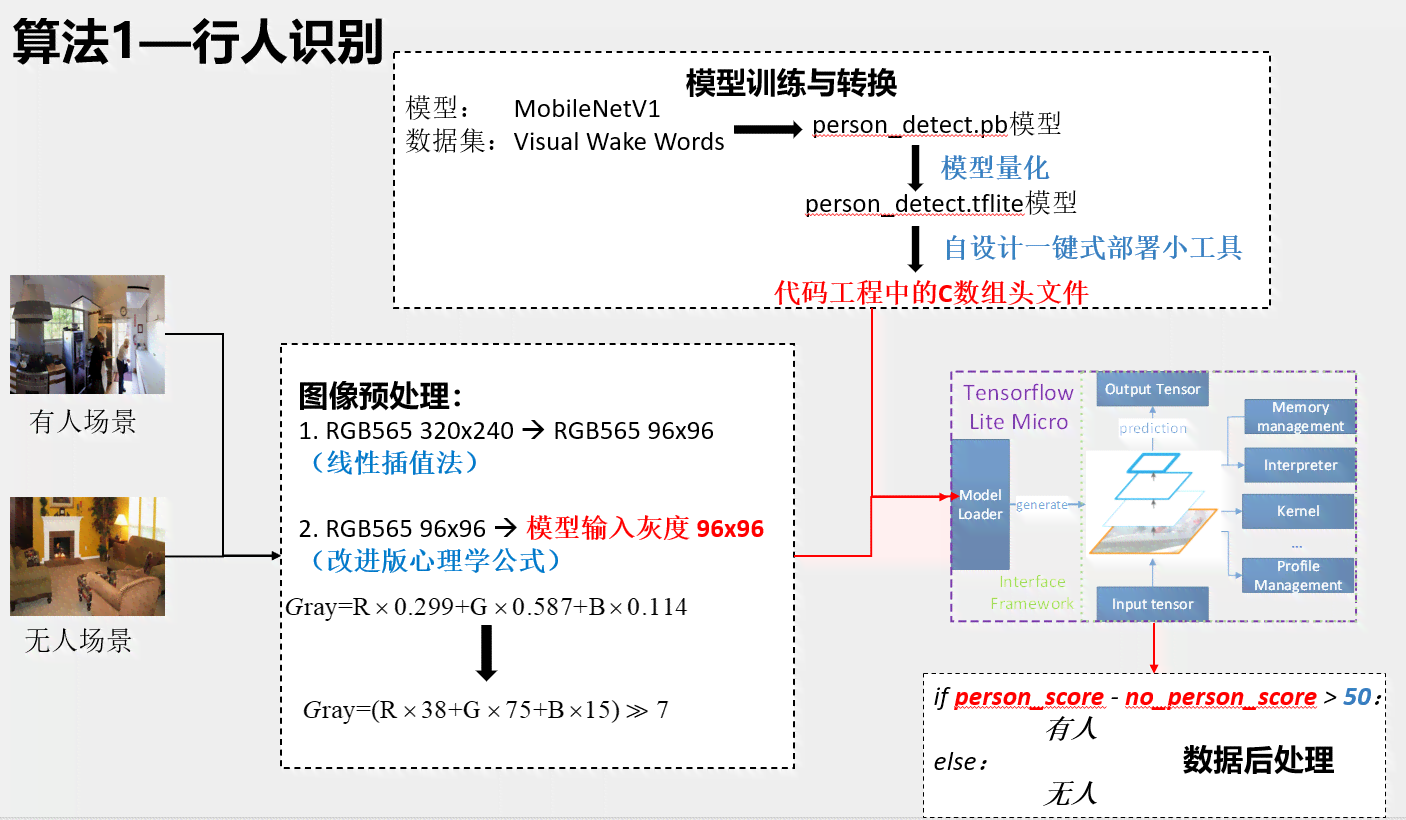

1. 硬件设备:部署写作模型需要一定的计算资源,建议采用具有较高性能的CPU和GPU。

2. 软件环境:部署写作模型需要安装Python环境,以及相关的库和框架如TensorFlow、PyTorch等。

3. 数据集:为了训练写作模型您需要准备大量文本数据。这些数据可是网络文章、书、新闻等。

4. 模型源代码:您可从网上开源的写作模型源代码,如GPT、BERT等。

三、部署写作模型的详细步骤

以下是采用Python和TensorFlow框架部署一个简单的写作模型的详细步骤:

1. 安装Python环境

您需要在计算机上安装Python环境。可从Python官网(https://www.python.org/)最新版本的Python安装包并依据提示实安装。安装完成后,打开命令行窗口,输入以下命令,确信Python环境已正确安装:

```bash

python --version

```

2. 安装TensorFlow库

在Python环境中,利用pip命令安装TensorFlow库:

```bash

pip install tensorflow

```

3. 写作模型源代码

从GitHub等平台开源的写作模型源代码,例如GPT模型。以下是一个示例:

```bash

git clone https://github.com/open/gpt-2.git

```

4. 准备数据集

将的文本数据集放入源代码目录中,并实行预解决。以下是一个简单的预解决脚本:

```python

import os

import re

def preprocess_text(text):

# 去除标点号

text = re.sub(r'[^\\w\\s]', '', text)

# 转换为小写

text = text.lower()

return text

# 读取文本数据

with open('data.txt', 'r', encoding='utf-8') as f:

lines = f.readlines()

# 预解决数据

processed_lines = [preprocess_text(line) for line in lines]

# 将预解决后的数据保存到新文件

with open('processed_data.txt', 'w', encoding='utf-8') as f:

f.writelines(processed_lines)

```

5. 训练写作模型

采用预应对后的数据集训练写作模型。以下是一个简单的训练脚本:

```python

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, LSTM, Dense

# 载入数据集

with open('processed_data.txt', 'r', encoding='utf-8') as f:

text = f.read()

# 创建字级编码

chars = sorted(list(set(text)))

char_indices = dict((c, i) for i, c in enumerate(chars))

indices_char = dict((i, c) for i, c in enumerate(chars))

# 创建训练数据

seq_length = 40

dataX = []

dataY = []

for i in range(0, len(text) - seq_length):

seq_in = text[i : i seq_length]

seq_out = text[i seq_length]

dataX.end([char_indices[char] for char in seq_in])

dataY.end(char_indices[seq_out])

# 向量化数据

X = tf.keras.preprocessing.sequence.pad_sequences(dataX, maxlen=seq_length, dtype='int32')

y = tf.keras.utils.to_categorical(dataY, num_classes=len(chars))

# 创建模型

model = Sequential()

model.add(Embedding(len(chars), 256, input_length=seq_length))

model.add(LSTM(128))

model.add(Dense(len(chars), activation='softmax'))

# 编译模型

model.compile(loss='categorical_crossentropy', optimizer='adam')

# 训练模型

model.fit(X, y, epochs=10, batch_size=128)

```

6. 保存模型

训练完成后,将模型保存到磁盘:

```python

model.save('my_model.h5')

```

7. 利用模型生成文章

加载训练好的模型并采用它生成文章:

```python

from tensorflow.keras.models import load_model

# 加载模型

model = load_model('my_model.h5')

# 生成文章

def generate_text(model, seed_text,