文章正文

文章正文

# 脚本怎么用:2021脚本编写指南与插件合集8.5版利用教程

在当今人工智能技术飞速发展的背景下脚本编写和应用已经成为多开发者和爱好者的必备技能。本文将为您详细介绍脚本怎么用,以及怎样去在2021年编写高效的脚本,并带来插件合集8.5版的利用教程。

## 1. 脚本简介

脚本是一种用于实现人工智能功能的程序代码,它可嵌入到各种应用程序中,实现智能化操作。脚本一般利用Python、JavaScript等编程语言编写通过调用各种API和库来实现语音识别、图像识别、自然语言解决等功能。

## 2. 脚本编写指南

### 2.1 选择合适的编程语言

在选择编程语言时,Python是编写脚本的首选。Python具有丰富的库和框架,如TensorFlow、PyTorch、Keras等这些库为开发提供了强大的支持。

### 2.2 学基础知识

在编写脚本之前需要掌握以下基础知识:

- 编程语言基础:熟悉Python或其他编程语言的基本语法。

- 数据结构与算法:理解常用的数据结构和算法,如数组、列表、字典、树、图等。

- 数学知识:掌握线性代数、概率论、统计学等基本数学知识。

- 机器学:熟悉常用的机器学算法,如线性回归、决策树、神经网络等。

### 2.3 调用API和库

编写脚本时需要调用各种API和库来实现功能。以下是部分常用的API和库:

- TensorFlow:用于实现深度学算法的框架。

- PyTorch:另一个深度学框架,具有动态图特性。

- Keras:一个高级神经网络API,可简化模型的构建和训练过程。

- OpenCV:用于图像解决的库可以实现图像识别、目标检测等功能。

- NLTK:自然语言应对库,可实现文本分析、分词、词性标注等功能。

### 2.4 调试与优化

编写完脚本后,需要对其实行调试和优化。以下是部分建议:

- 仔细检查代码,保证未有语法错误。

- 采用print语句或调试工具来查看程序的运行状态。

- 对代码实行性能优化,加强运行效率。

- 采用版本控制系统(如Git)来管理代码,便于回溯和协作。

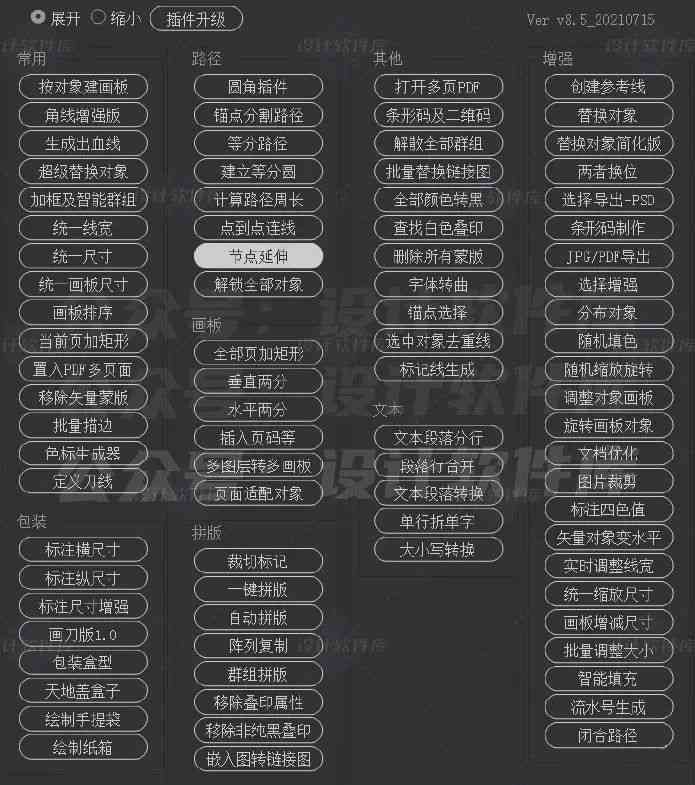

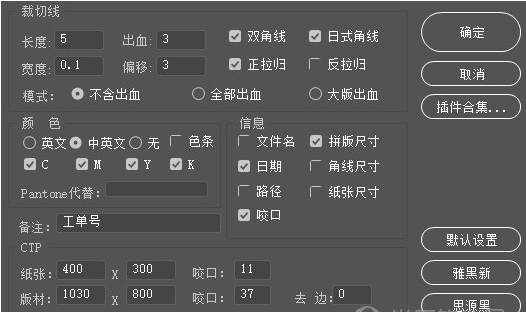

## 3. 脚本插件合集8.5版利用教程

脚本插件合集8.5版包含了一系列实用的功能插件,下面将为您介绍怎样采用这些插件。

### 3.1 安装插件

您需要从官方网站脚本插件合集8.5版。完成后,解压文件,然后依照以下步骤实安装:

1. 打开您的编程环境(如PyCharm、Visual Studio Code等)。

2. 在项目目录下创建一个名为“plugins”的文件。

3. 将的插件文件复制到“plugins”文件中。

4. 重新启动编程环境,插件即可生效。

### 3.2 采用插件

以下是若干常用插件的采用方法:

#### 3.2.1 语音识别插件

1. 导入插件:在代码中导入“speech_recognition”模块。

2. 创建识别器:创建一个SpeechRecognition类的实例。

3. 调用API:利用recognize_sphinx方法实语音识别。

示例代码:

```python

import speech_recognition as sr

recognizer = sr.Recognizer()

with sr.Microphone() as source:

audio = recognizer.listen(source)

text = recognizer.recognize_sphinx(audio)

print(text)

```

#### 3.2.2 图像识别插件

1. 导入插件:在代码中导入“opencv-python”模块。

2. 读取图像:采用cv2.imread函数读取图像文件。

3. 调用API:采用cv2.CascadeClassifier实图像识别。

示例代码:

```python

import cv2

image = cv2.imread('example.jpg')

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades 'haarcascade_frontalface_default.xml')

faces = face_cascade.detectMultiScale(image, 1.1, 4)

for (x, y, w, h) in faces:

cv2.rectangle(image, (x, y), (x w, y h), (255, 0, 0), 2)

cv2.imshow('Image', image)

cv2.wtKey(0)

cv2.destroyAllWindows()

```

#### 3.2.3 自然语言解决插件

1. 导入插件:在代码中导入“nltk”模块。

2. 加载语料库:利用nltk.download('punkt')加载分词工具。

3. 调用API:利用nltk.word_tokenize实行分词。

示例代码:

```python

import nltk

from nltk.tokenize import word_tokenize

n