文章正文

文章正文

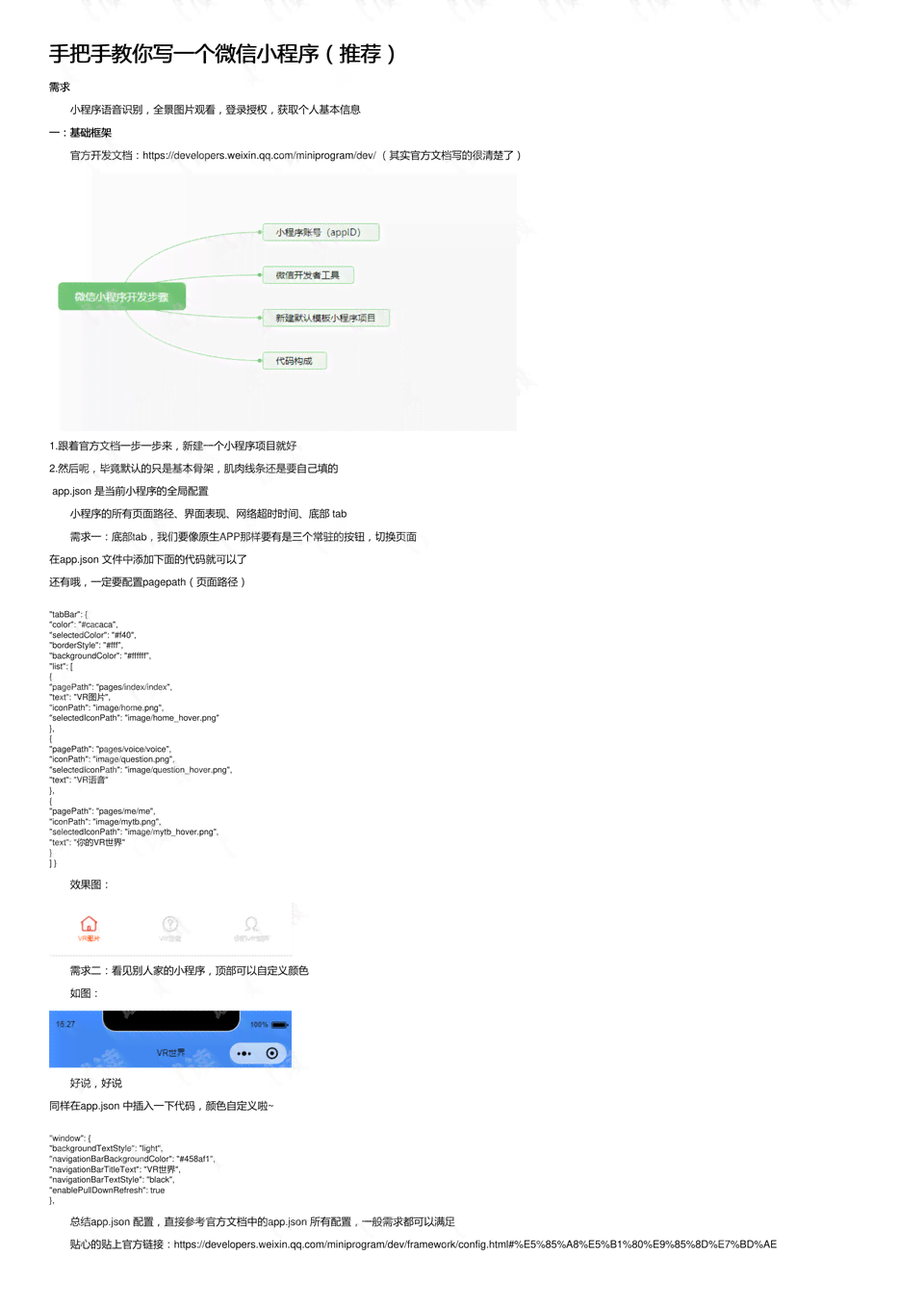

手把手教你编写简易脚本:从入门到精通教程

随着科技的不断发展人工智能逐渐成为咱们生活中不可或缺的一部分。越来越多的应用程序和软件开始采用人工智能技术使得咱们的生活变得更加便捷。而脚本,就是实现这些智能操作的关键。本文将手把手教你编写简易脚本,让你从入门到精通。

一、什么是脚本?

脚本是一种用于实现人工智能操作的程序,通过编写特定的代码,让计算机模拟人类的思维和表现。脚本广泛应用于聊天机器人、智能推荐、数据挖掘等领域。编写脚本可增进工作效率,减少人力成本,为咱们的生活带来更多便利。

二、编写脚本前的准备工作

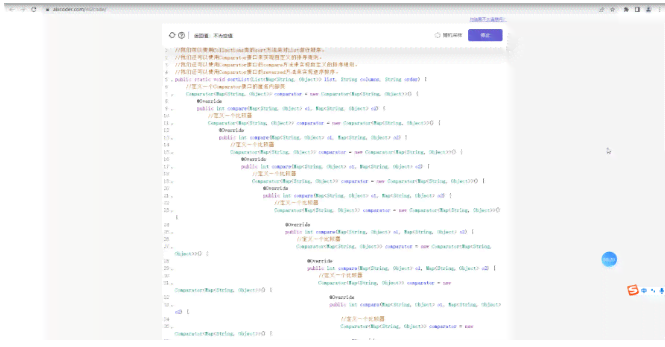

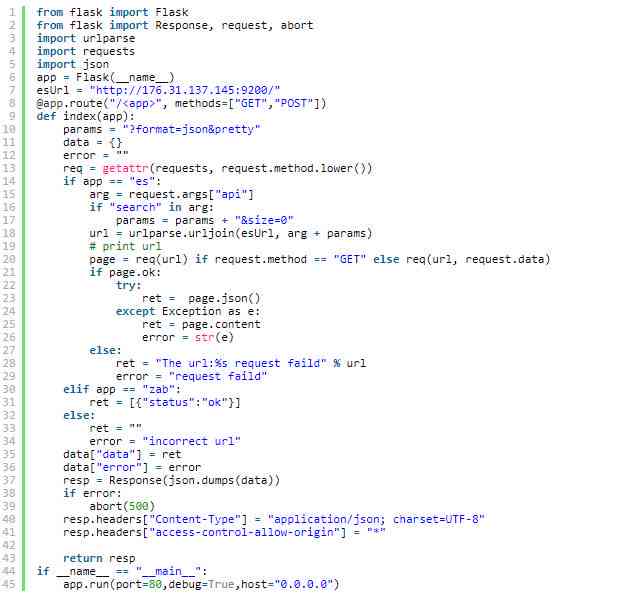

1. 学编程语言:编写脚本需要掌握一定的编程知识,如Python、Java等。这里我们以Python为例,介绍怎样编写简易脚本。

2. 准备编程环境:安装Python编程环境如PyCharm、Visual Studio Code等。

3. 学基础库:理解并学若干常用的Python库如requests、BeautifulSoup等,这些库可以帮助我们实现网络请求、数据解析等功能。

4. 学相关教程:查阅部分关于脚本编写的教程,熟悉基本概念和方法。

三、手把手教你编写简易脚本

1. 创建一个Python文件:我们需要创建一个Python文件,用于编写脚本。在文件中,编写以下代码:

```python

# 导入所需库

import requests

from bs4 import BeautifulSoup

# 定义一个函数用于发送网络请求

def send_request(url):

response = requests.get(url)

return response.text

# 定义一个函数,用于解析网页内容

def parse_html(html):

soup = BeautifulSoup(html, 'html.parser')

return soup

# 主函数

if __name__ == '__mn__':

# 发送网络请求

url = 'https://www.example.com'

html = send_request(url)

# 解析网页内容

soup = parse_html(html)

# 输出解析结果

print(soup.prettify())

```

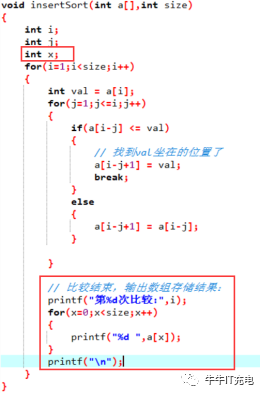

2. 分析网页结构:通过观察网页源代码,熟悉目标网页的结构。例如,我们需要提取网页中的标题、落、图片等元素。

3. 修改代码提取目标元素:

```python

# 导入所需库

import requests

from bs4 import BeautifulSoup

# 定义一个函数,用于发送网络请求

def send_request(url):

response = requests.get(url)

return response.text

# 定义一个函数用于解析网页内容

def parse_html(html):

soup = BeautifulSoup(html, 'html.parser')

# 提取标题

title = soup.title.string

# 提取落

paragraphs = soup.find_all('p')

# 提取图片

images = soup.find_all('img')

return title, paragraphs, images

# 主函数

if __name__ == '__mn__':

# 发送网络请求

url = 'https://www.example.com'

html = send_request(url)

# 解析网页内容

title, paragraphs, images = parse_html(html)

# 输出解析结果

print('Title:', title)

print('Paragraphs:')

for paragraph in paragraphs:

print(paragraph.get_text())

print('Images:')

for image in images:

print(image['src'])

```

4. 完善脚本功能:依据实际需求,完善脚本的功能。例如,我们可添加一个功能,将提取到的网页内容保存到本地文件:

```python

import requests

from bs4 import BeautifulSoup

import os

def send_request(url):

response = requests.get(url)

return response.text

def parse_html(html):

soup = BeautifulSoup(html, 'html.parser')

title = soup.title.string

paragraphs = soup.find_all('p')

images = soup.find_all('img')

return title, paragraphs, images

def save_to_file(title, paragraphs, images):

# 创建一个文件,用于保存文件

if not os.path.exists('output'):

os.makedirs('output')

# 保存标题

with open('output/title.txt', 'w', encoding='utf-8') as f:

f.write(title)

# 保存落

with open('output/paragraphs.txt', 'w', encoding='utf-8') as f:

for paragraph in paragraphs:

f.write(paragraph.get_text() '\

')

# 保存图片

for index, image in enumerate(images):

image_url = image['src']

image_response = requests.get(image_url)

image_name = f'output/image_{index}.jpg'

with open(image_name, 'wb') as f:

f.write(image_response.content)

if __name__ == '__mn__':

url = 'https://www.example.com'

html = send_request(url)

title, paragraphs, images = parse_html(html)

save