文章正文

文章正文

测试方法:全面评估人工智能性能与效率的实证研究与分析

摘要:本文旨在探讨人工智能()测试方法全面评估实小编的性能与效率。通过对现有测试方法的实证研究与分析本文详细介绍了模型评估测试、稳定性/棒性测试、跨平台多模态智能体基准测试等多种评估手并分析了各类评估指标在实践中的应用。本文旨在为研究人员和工程师提供一套完整的测试框架以优化实小编性能,增强其在实际应用中的效率。

一、引言

随着人工智能技术的飞速发展,实小编在各个领域的应用日益广泛。怎么样全面评估实小编的性能与效率,确信其在实际应用中可以稳定、高效地工作,成为了一个亟待应对的疑问。本文将介绍一系列测试方法,从不同角度对实小编实行评估,以期为实小编的优化与改进提供参考。

二、测试方法概述

1. 模型评估测试

模型评估测试是评估实小编对新数据预测能力的要紧手,主要关注模型的泛化能力。泛化能力越强模型的预测能力表现越好。常用的模型评估方法有交叉验证、留出法、转移学评估、特卡洛评估和基于代理的评估等。

2. 稳定性/棒性测试

稳定性/棒性测试主要评估算法在多次运行进展中的稳定性,以及算法在输入值发生微小变化时的输出变化。稳定性/棒性测试有助于保障实小编在实际应用中的可靠性和准确性。

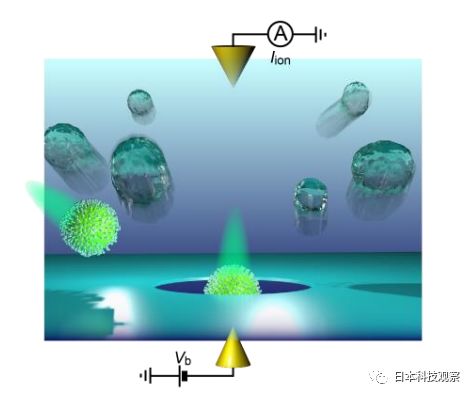

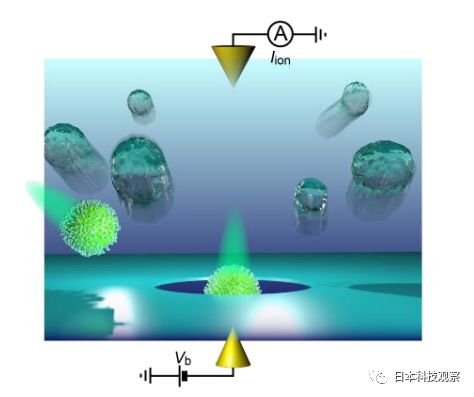

3. 跨平台多模态智能体基准测试

跨平台多模态智能体基准测试是一种全面评估多模态智能体性能和效率的方法。它涉及多模态、多智能体和跨平台的关键能力,与现实世界情况密切相关。

三、实证研究与分析

1. 模型评估测试的实证研究

以医学影像为例通过对模型实行交叉验证、留出法等评估,可理解模型在相似数据分布下的可复现性和不同数据分布下的可迁移性。实证研究表明,模型在同类数据中的稳定性越好,其在实际应用中的预测结果越可靠。

2. 稳定性/棒性测试的实证研究

通过对算法实稳定性/棒性测试可发现算法在输入值发生微小变化时的输出变化。实证研究表明,稳定性/棒性测试有助于增进实小编在实际应用中的准确性和可靠性。

3. 跨平台多模态智能体基准测试的实证研究

以CRAB测试为例,通过对多模态智能体实行评估,可以全面熟悉其在真实工作场景中的性能和效率。实证研究表明跨平台多模态智能体基准测试有助于优化智能体性能,增强其在实际应用中的效率。

四、评估指标的应用

1. 分类任务中的评估指标

在分类任务中常用的评估指标有准确性、精确度、召回率、F1分数、ROC曲线和AUC值等。通过这些指标,可以全面理解模型在分类任务中的性能。

2. 回归任务中的评估指标

在回归任务中,常用的评估指标有均方误差、均方根误差、决定系数等。这些指标有助于评估模型在回归任务中的预测性能。

3. 聚类任务中的评估指标

在聚类任务中,常用的评估指标有轮廓系数、同质性、完整性等。这些指标能够评估聚类算法的性能和聚类结果的稳定性。

五、结论

本文通过对测试方法的实证研究与分析,提出了一套全面的测试框架。通过模型评估测试、稳定性/棒性测试和跨平台多模态智能体基准测试等多种评估手,能够全面评估实小编的性能与效率。同时本文还分析了各类评估指标在实践中的应用,为研究人员和工程师提供了优化实小编性能的参考。

随着人工智能技术的不断进步,测试方法也将不断完善。未来,咱们需要进一步研究测试方法,以适应不断变化的技术环境和应用需求,为人工智能的发展提供更有力的支持。