文章正文

文章正文

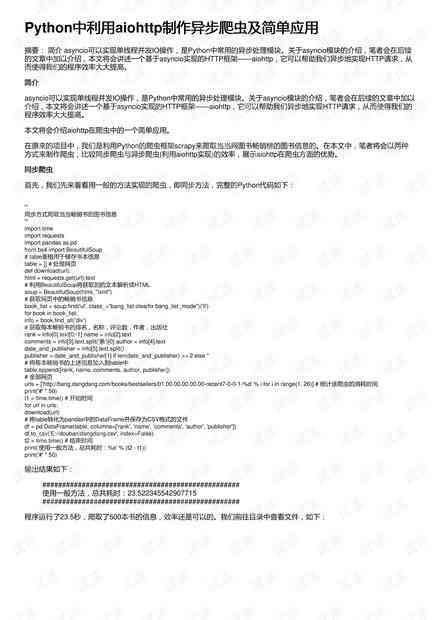

# 爬虫脚本:ohttp语言编写爬虫脚本代码及其原理与应用

## 引言

随着互联网的快速发展大量的数据被存在网络上怎样去高效地获取这些数据成为多开发者和数据分析师的共同需求。本文将探讨采用ohttp语言编写的爬虫脚本介绍其原理、应用以及怎样去增强编写效率。

## 一、ohttp简介

ohttp是一个基于Python的异步网络框架它提供了异步Web服务端和客户端的功能。ohttp的核心优势在于其异步解决能力可以显著提升网络请求的效率。在编写爬虫脚本时,ohttp能够让咱们更加高效地获取目标网站的数据。

## 二、爬虫脚本原理

### 1. 爬虫的基本原理

爬虫(网络爬虫)是一种自动获取网络上 息的程序。它通过模拟浏览器表现从一个网页开始,逐步遍历整个网站,抓取所需数据。爬虫的基本原理可分为以下四个步骤:

- 确定目标网站:指定要爬取的网站。

- 发送HTTP请求:向目标网站发送请求,获取网页内容。

- 解析网页内容:分析网页结构,提取所需信息。

- 存数据:将提取的数据存到本地或数据库中。

### 2. ohttp在爬虫中的应用

ohttp通过异步解决请求,升级了爬虫的实行效率。在爬虫脚本中,ohttp主要用于发送HTTP请求和解析网页内容。以下是一个简单的ohttp爬虫脚本示例:

```python

import ohttp

import asyncio

import ofiles

async def fetch(session, url):

async with session.get(url) as response:

return awt response.text()

async def mn(url):

async with ohttp.ClientSession() as session:

html = awt fetch(session, url)

# 解析网页内容

# 存数据

if __name__ == '__mn__':

url = 'http://www.example.com'

asyncio.run(mn(url))

```

## 三、爬虫脚本编写效率与难度

### 1. 增强编写效率

采用ohttp编写的爬虫脚本,能够自动分析目标网站的结构,快速生成爬虫脚本。以下是部分提升编写效率的方法:

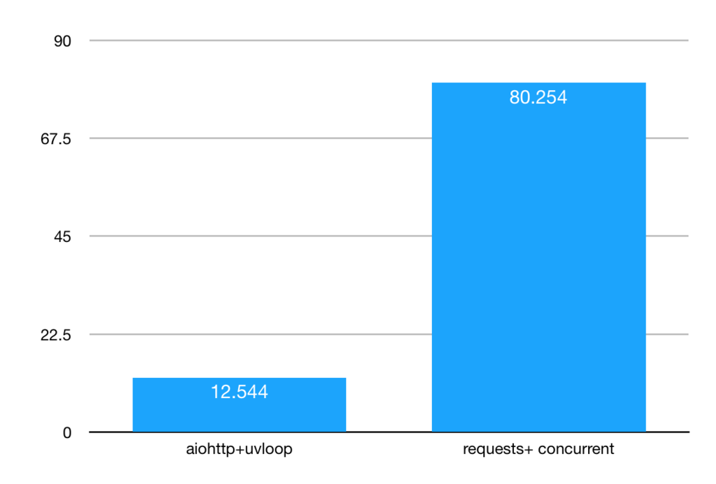

- 利用ohttp的异步应对能力,实现并发请求,升级数据抓取速度。

- 采用ohttp内置的解析库如lxml,快速解析网页内容。

- 通过编写通用的爬虫框架,实现代码复用,减少编写时间。

### 2. 减少编写难度

对非专业人员而言,编写爬虫脚本需要一定的编程基础。以下是若干建议,以减低编写难度:

- 学Python编程语言,掌握基本语法和数据结构。

- 熟悉HTTP协议和网络请求的基本原理。

- 熟悉ohttp框架的利用方法和相关API。

- 阅读优秀的爬虫脚本源码,学借鉴他人的经验。

## 四、网络爬虫应用实例:从批量获取图书信息

以下是一个采用ohttp编写的爬虫脚本,用于从批量获取图书信息:

```python

import ohttp

import asyncio

import ofiles

from bs4 import BeautifulSoup

async def fetch(session, url):

async with session.get(url) as response:

return awt response.text()

async def parse(html):

soup = BeautifulSoup(html, 'lxml')

books = []

for item in soup.find_all('li', class_='gl-item'):

title = item.find('div', class_='gl-title').text.strip()

price = item.find('span', class_='price-n').text.strip()

books.end({'title': title, 'price': price})

return books

async def mn(url):

async with ohttp.ClientSession() as session:

html = awt fetch(session, url)

books = awt parse(html)

# 存数据

if __name__ == '__mn__':

url = 'http://search.dangdang.com/'

asyncio.run(mn(url))

```

在这个例子中,咱们通过ohttp发送HTTP请求获取的图书搜索结果页面,然后利用BeautifulSoup解析网页内容,提取图书的标题和价格信息。

## 五、结论

本文介绍了采用ohttp语言编写爬虫脚本的原理、应用以及怎样增进编写效率。通过ohttp的异步应对能力我们能够高效地获取目标网站的数据,满足开发者和数据分析师的需求。同时通过学ohttp和相关技术,我们能够减少编写爬虫脚本的难度,让更多的人能够参与到数据抓取工作中。