文章正文

文章正文

一、引言

1.1 背景介绍

随着科技的飞速发展人工智能()逐渐成为各个领域的要紧工具。在文案创作领域文案生成器以其特别的优势正在引领一场革命性的变革。GitHub作为全球更大的开源社区汇集了众多优秀的文案生成器项目。本文将全面介绍GitHub上的文案生成器项目涵盖智能写作、代码示例与实践指南。

1.2 文章目的

本文旨在帮助读者理解GitHub上文案生成器的相关项目掌握其技术原理、优势与未来展望,为企业和个人提供实用的智能写作工具。

二、文案生成器技术原理

2.1 基本原理

文案生成器基于自然语言解决(NLP)技术,通过训练大量文本数据,使计算机具备理解和生成自然语言的能力。其主要原理涵盖词向量、语言模型和生成模型三部分。

2.2 词向量

词向量是一种将词汇映射为高维空间中的向量的技术,可表示词汇的语义信息。通过词向量计算机可更好地理解词汇之间的关联。

2.3 语言模型

语言模型是一种用于预测给定上下文中下一个词汇的概率的模型。通过语言模型,文案生成器可以生成符合语法规则的句子。

2.4 生成模型

生成模型是一种按照输入的上下文生成文本的模型。常见的生成模型有生成对抗网络(GAN)和变分自编码器(VAE)等。

三、GitHub上的文案生成器项目

3.1 项目概述

GitHub上有很多优秀的文案生成器项目,以下是部分具有代表性的项目:

1. GPT-2:由Open开发的开源自然语言解决模型,可生成高品质的文本。

2. Transformer:一种基于自留意力机制的深度神经网络模型,被广泛应用于文案生成任务。

3. Word2Vec:一种词向量训练模型,可用于升级文案生成器的语义理解能力。

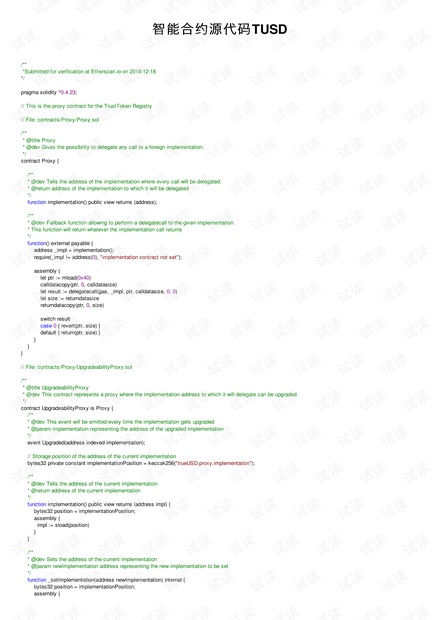

3.2 项目代码示例

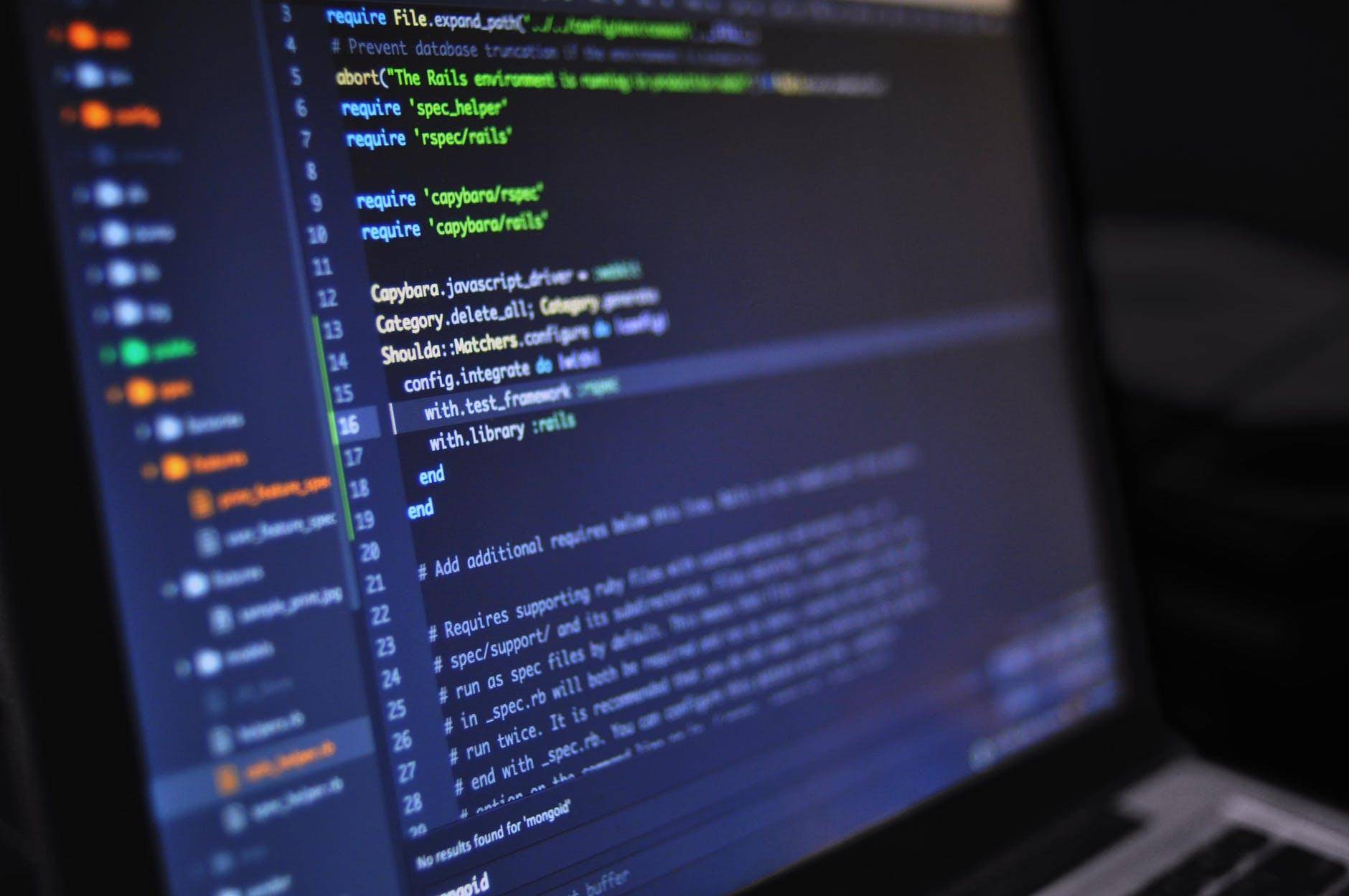

以下是一个基于GPT-2的文案生成器代码示例:

```python

import torch

from transformers import GPT2LMHeadModel, GPT2Tokenizer

def generate_text(prompt, model, tokenizer, max_length=50):

input_ids = tokenizer.encode(prompt, return_tensors='pt')

output_sequences = model.generate(

input_ids=input_ids,

max_length=max_length,

temperature=0.7,

top_k=50,

top_p=0.95,

repetition_penalty=1.2

)

generated_text = tokenizer.decode(output_sequences[0], skip_special_tokens=True)

return generated_text

# 加载模型和分词器

model_name = 'gpt2'

model = GPT2LMHeadModel.from_pretrned(model_name)

tokenizer = GPT2Tokenizer.from_pretrned(model_name)

# 生成文本

prompt = The writer can

generated_text = generate_text(prompt, model, tokenizer)

print(generated_text)

```

3.3 实践指南

1. 选择合适的模型:依照项目需求选择合适的模型,如GPT-2、Transformer等。

2. 训练数据集:收集和整理相关领域的数据集,用于训练模型。

3. 调整模型参数:依照实际需求,调整模型参数,如学习率、批量大小等。

4. 评估模型性能:通过交叉验证等方法评估模型性能,优化模型。

5. 部署模型:将训练好的模型部署到实际应用场景中。

四、文案生成器的优势与应用场景

4.1 优势

1. 加强创作效率:文案生成器可以快速生成高品质的文本,节省人力成本。

2. 突破灵感瓶颈:文案生成器可提供多样化的创意,帮助创作者突破灵感瓶颈。

3. 适应多种场景:文案生成器能够应用于新闻、广告、营销等多个领域。

4.2 应用场景

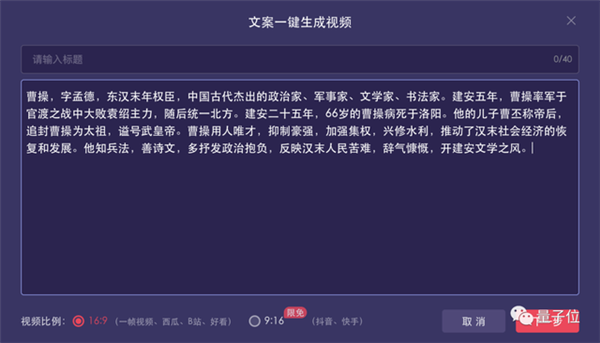

1. 新闻报道:文案生成器可自动生成新闻报道,增强新闻传播效率。

2. 广告创意:文案生成器可为广告创意提供多样化方案,增进广告效果。

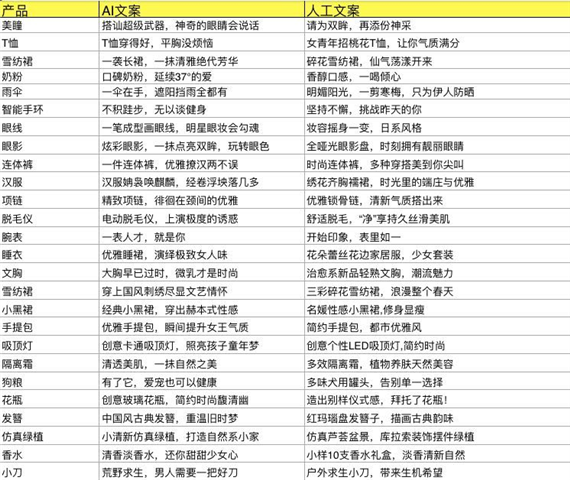

3. 营销推广:文案生成器能够生成吸引人的营销文案,提升产品销量。

五、未来展望

随着人工智能技术的不断发展,文案生成器将在以下方面取得突破:

1. 模型性能:模型性能将不断提升,生成更加高优劣的文本。

2. 跨领域应用:文案生成器将拓展到更多领域,为不同行业提供应对方案。

3. 个性化定制:按照使用者需求,提供个性化的文案生成服务。

六、结论

本文对GitHub上的文案生成器项目实行了全面介绍,包含技术原理、代码示例和实践指南。文案生成器作为一种创新性工具,在数字化时代具有广泛的应用前景。随着人工智能技术的不断发展咱们有理由相信,文案生成器将为文案创作领域带来更加美好的未来。