文章正文

文章正文

内容简介

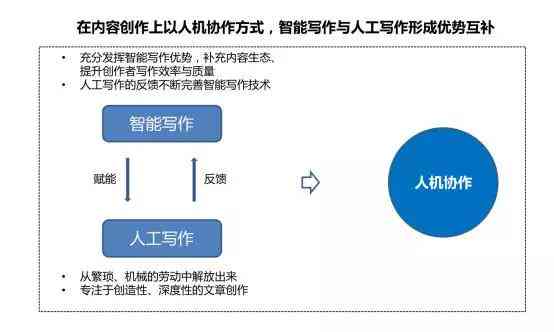

人工智能()的迅猛发展不仅改变了咱们的生活形式也对各行各业产生了深远的作用。其中写作作为人工智能领域的必不可少分支更是引发了广泛的关注和讨论。它不仅可以模仿人类的写作方法生成高品质的文章、诗歌、新闻报道等文本内容还能在商业、教育、娱乐等多个领域发挥巨大作用。本文将从技术角度深入剖析写作的工作原理探讨其应用场景并展望其未来的发展前景。通过这一过程咱们将熟悉写作背后的算法与模型以及它怎么样一步步从理论走向现实应用。无论你是对人工智能感兴趣的普通读者还是从事相关行业的专业人士相信都能从中获得宝贵的知识和启示。

写作是什么

写作是一种利用机器学习和自然语言解决技术,使计算机能够自动生成文本内容的方法。其核心在于让机器学会理解并模仿人类的写作方法,从而生成符合语法规范、逻辑连贯且富有创意的文本。写作不仅能够生成日常新闻报道、产品描述、故事创作等,还可用于撰写复杂的学术论文、法律文件等专业领域的内容。写作系统常常由大量数据训练而成,包含大量的语言样本和相应的语法规则。通过深度学习和神经网络技术,系统可自动识别和理解文本中的语义结构,进而生成新的文本内容。随着技术的进步,写作的应用场景日益广泛,不仅增强了工作效率,还为文学创作带来了全新的可能性。

写文原理

写文原理主要依赖于自然语言解决(NLP)和深度学习技术。自然语言解决是计算机科学领域中涉及人类语言与计算机交互的学科,其目标是使计算机能够理解和解决人类语言。深度学习是一种基于人工神经网络的机器学习方法,它通过模拟人脑的神经元结构,实现了对复杂模式的学习和识别。写作的核心在于“生成模型”,这类模型通过训练大量文本数据,学会了文本的统计规律和语言模式。例如常用的Transformer模型,就是一种基于留意力机制的深度学习架构,能够捕捉文本中的长距离依赖关系,从而生成连贯性和一致性更强的文本。预训练和微调技术也被广泛应用于写作中,通过在大规模语料库上实施预训练模型可掌握丰富的语言知识,然后在特定任务上实行微调以适应具体需求。

写作算法

写作算法是实现文本生成的关键,常见的算法包含RNN(循环神经网络)、LSTM(长短时记忆网络)和Transformer等。这些算法通过构建复杂的神经网络模型,使机器能够理解文本内容并生成新的文本。RNN是一种特别适合应对序列数据的神经网络模型,它能够捕捉文本中的时间依赖关系,适用于生成连续文本。LSTM是RNN的一种变体,通过引入门控机制,有效应对了长期依赖疑问,提升了文本生成的品质。而Transformer模型则采用了自留意力机制,能够在一次前向传播中应对整个序列,大大提升了计算效率和生成效果。近年来基于Transformer的GPT(生成式预训练转换器)系列模型已经成为写作领域的主流技术,它们不仅在文本生成方面表现出色,还具备了理解和生成多模态信息的能力,如图像和视频。

写作模型

写作模型是指用于生成文本的具体算法框架。目前更流行的写作模型之一是GPT(Generative Pre-trned Transformer),它通过大规模的预训练和微调,掌握了丰富的语言知识和生成能力。GPT模型采用Transformer架构,具有强大的上下文理解和生成能力。还有其他部分关键的写作模型,如BERT(双向编码表示变换器)和XLNet等。这些模型各有特点,可依照不同的应用场景实施选择。例如,BERT模型擅长理解文本中的语义关系,适用于文本分类、情感分析等任务;而XLNet则在文本生成方面表现优异,能够生成更加自然流畅的文本内容。写作模型的选择需要依据具体任务的需求和资源条件实施综合考虑,以保证生成文本的品质和效果达到。

写作的应用场景

写作已经在多个领域展现出巨大的应用潜力。在新闻媒体行业,写作能够快速生成新闻稿件提升工作效率。例如,美联社已经采用工具生成了大量的财经新闻报道。在电商领域,写作能够自动生成商品描述,提升客户体验。亚马逊等电商平台已经开始应用这类技术,为消费者提供详尽的商品介绍。在教育领域写作可辅助教师编写教学材料,减轻工作负担。例如,若干在线教育平台已经开始采用写作技术帮助教师快速生成高优劣的教学文档。写作还在娱乐、广告等多个领域发挥了要紧作用,推动了内容创作的创新与发展。

写作的未来发展前景

随着技术的不断进步,写作的未来发展充满了无限可能。在算法层面,深度学习和强化学习等新技术将继续推动写作性能的提升。例如,通过结合强化学习,写作系统能够更好地理解使用者偏好,生成更加个性化的内容。在模型层面,更大规模的数据集和更复杂的模型架构将进一步增强写作的生成能力和泛化能力。例如,利用更多的语言样本和更深层次的神经网络,能够显著增强文本生成的准确性和多样性。 在应用层面,写作将在更多领域得到广泛应用,如智能客服、虚拟助手等。这些应用场景将极大地改变人们的生活途径,增强生产效率,创造更多价值。