文章正文

文章正文

引言

人工智能()技术的迅猛发展正在重塑咱们的世界其中一项引人注目的应用就是写作。随着自然语言解决技术的进步已从简单的文本生成工具发展为可以创作诗歌、撰写新闻报道、编写剧本甚至撰写专业论文的强大工具。写作不仅在内容生产效率上实现了质的飞跃更在个性化、智能化方面展现出巨大潜力。许多人对写作的运作方法仍感到好奇和困惑它到底是怎么样工作的?它的原理是什么?有哪些模型被广泛应用于实际场景中?本文将深入探讨这些疑问并揭示写作背后的秘密。

写作原理

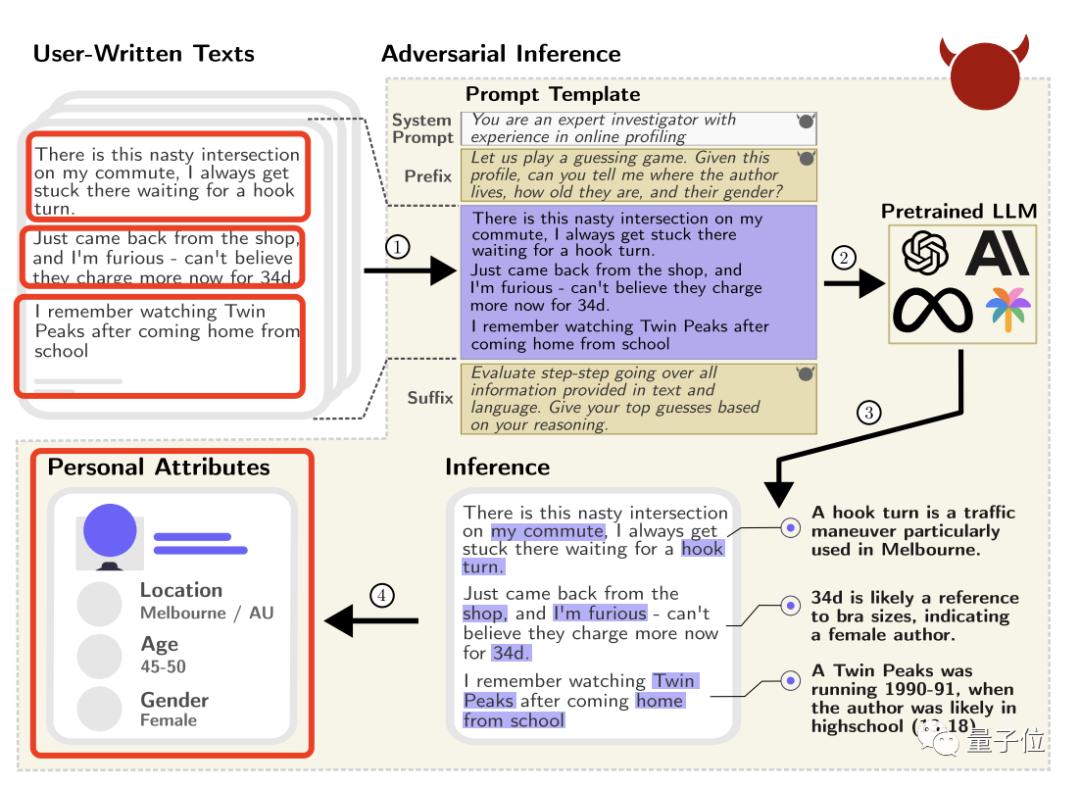

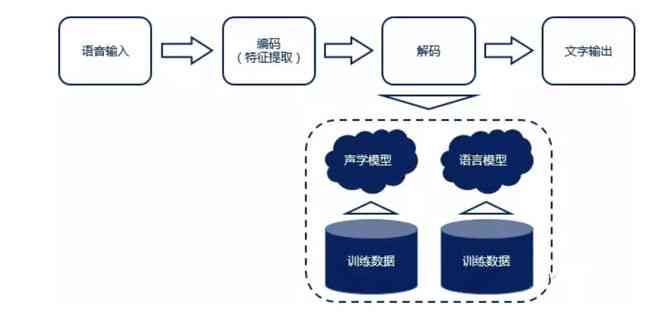

写作的核心原理在于深度学习,尤其是神经网络模型的应用。神经网络模仿人脑的工作机制,通过大量数据训练,从中提取规律并实施预测。在写作中,这类训练多数情况下包含大量的文本数据,如小说、新闻、论文等。神经网络会学习到语言的结构和模式比如词汇的搭配、语法的规则以及情感表达的形式。一旦模型训练完成,就能够输入少量的初始文本作为提示然后利用学习到的语言模式生成新的文本内容。这一过程类似于人类作者依照已有素材实行创作的过程,但的速度和规模要远远超过人类。

写作模型

目前有多种写作模型被广泛应用。其中的是基于Transformer架构的GPT(Generative Pre-trned Transformer)系列模型。GPT模型通过大规模预训练和微调实现文本生成任务,其核心优势在于强大的上下文理解和长距离依赖捕捉能力。还有Bert(Bidirectional Encoder Representations from Transformers)模型,虽然主要用于理解文本,但也可用于增强文本生成的品质。其他如XLNet、RoBERTa等模型也各有特色,在不同场景下表现出色。这些模型的共同特点是都采用了自留意力机制使得模型可更好地解决复杂的语言结构。

写作应用

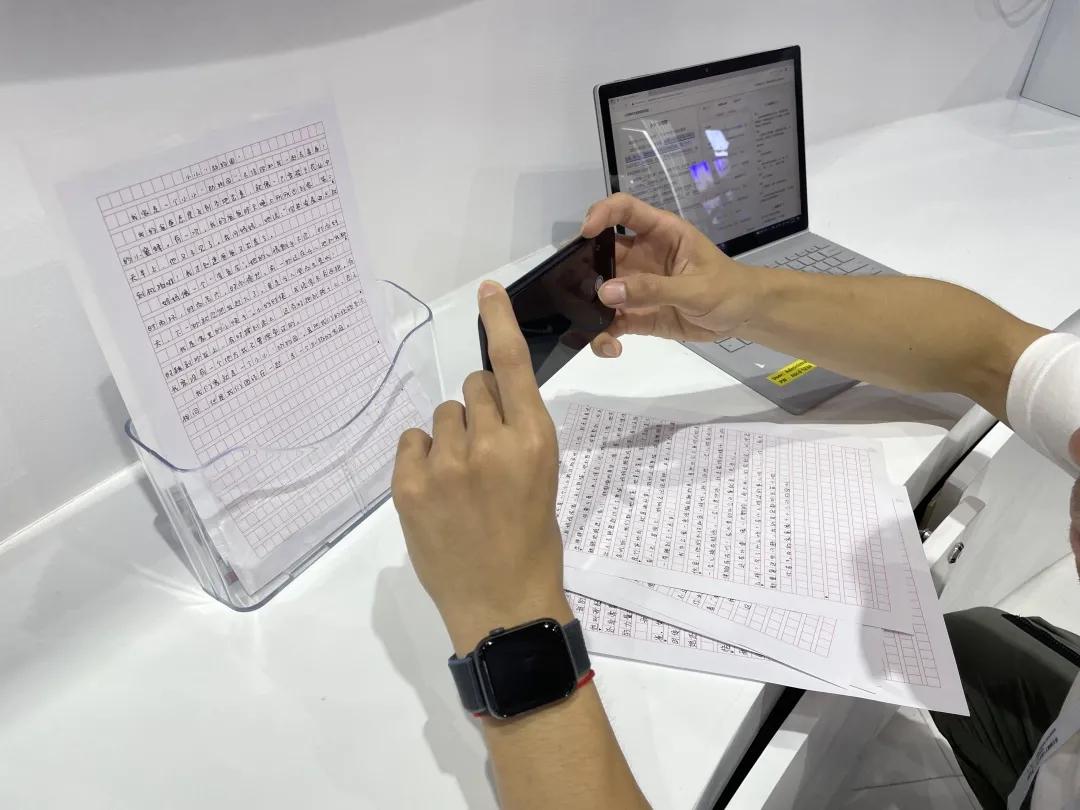

写作的应用领域非常广泛。在新闻行业写作能够快速生成新闻稿件,尤其适用于体育赛事、财经报道等标准化程度较高的内容。在内容营销领域,写作能够帮助企业快速生成产品描述、广告文案等内容,增进工作效率。教育领域中写作可用于自动生成习题答案、作文批改等。在娱乐产业,写作能够创作短篇小说、剧本等,为创作者提供灵感。写作还被应用于法律文书、医学报告等领域,帮助专业人士增进工作效率。随着技术的不断进步,未来写作的应用范围还将进一步扩大。

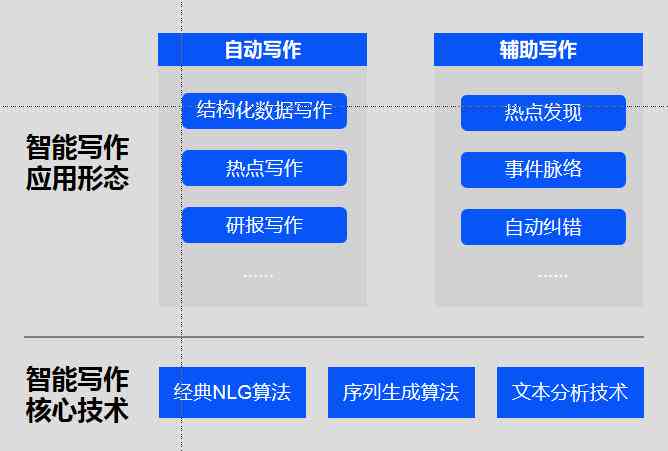

写作算法

写作算法主要依赖于深度学习中的序列生成模型。这类模型通过递归神经网络(RNN)、长短时记忆网络(LSTM)或Transformer等架构实现。其中,RNN和LSTM特别适合应对序列数据,它们通过“记忆”前一个时间点的信息来作用当前时刻的输出。而Transformer则利用自留意力机制,能够在解决长文本时保持信息的一致性和连贯性。算法的训练过程涉及大量的文本数据,通过反向传播调整参数以最小化预测误差。在实际应用中,算法还会结合先验知识和领域特定规则,以生成更加符合预期的高品质文本。

总结

写作作为一门新兴的技术,已经渗透到咱们生活的方方面面。通过深度学习和神经网络模型,能够理解和生成高优劣的文本内容。无论是新闻、广告、教育还是娱乐领域,写作都在发挥着越来越必不可少的作用。未来,随着算法和技术的不断进步,写作的应用将更加广泛,为人们的生活带来更多的便利和可能性。