文章正文

文章正文

引言

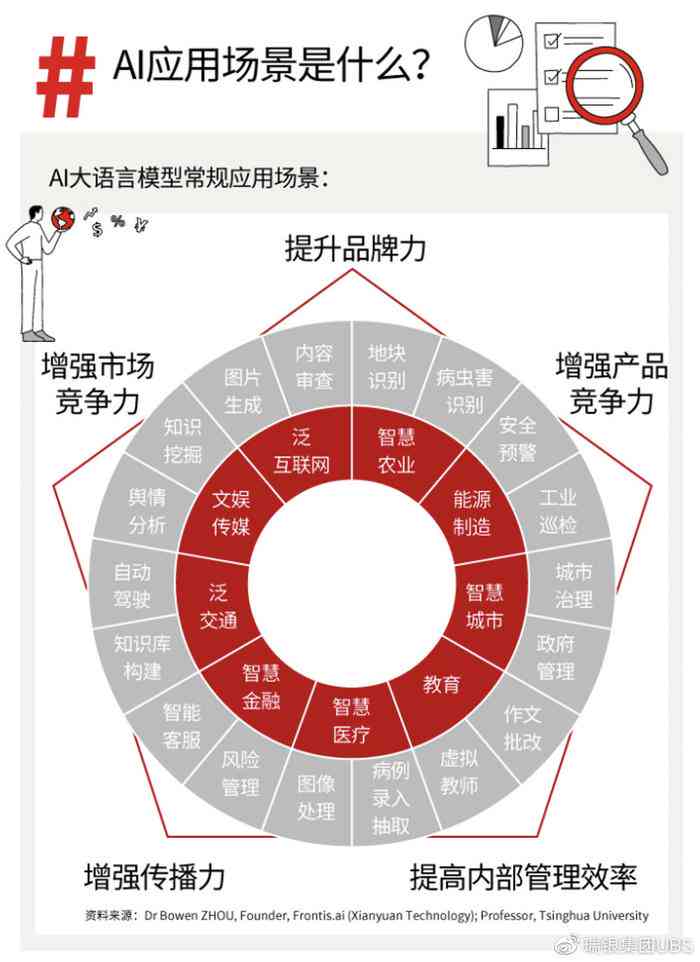

随着人工智能()技术的迅猛发展写作已经成为一个热门话题。无论是新闻报道、学术论文还是日常写作都能快速生成高品质的文章。写作的一个显著疑问就是其生成的内容可能存在较高的相似度。这一现象引发了广泛的关注和讨论。本文旨在深入探讨创作相似度高的起因并分析技术背后的根本疑问。

写作的基本原理

写作的核心在于深度学习模型这些模型通过大量的文本数据实施训练从而学会理解和生成自然语言。具体而言写作系统往往采用的是神经网络模型如循环神经网络(RNN)、长短时记忆网络(LSTM)和Transformer模型。这些模型可以捕捉文本中的模式和结构从而生成新的句子和段落。例如BERT(Bidirectional Encoder Representations from Transformers)模型可以理解上下文信息生成更加连贯和自然的语言。

写作系统的训练过程也存在一定的局限性。由于训练数据集往往是大规模的文本 其中包含了各种各样的表达形式和主题,系统不可避免地会学到这些常见的表达和主题。这使得生成的内容在一定程度上可能与其他已有的文本相似,进而造成较高的查重率。

缺乏原创性思维的疑惑

尽管写作在生成文本方面表现出色,但它仍然缺乏真正的人类原创性思维。人类在写作进展中,往往会结合本人的经验和独有的视角,形成独到的观点和见解。而写作则更多依赖于现有的数据和规则,难以创造出完全新颖的内容。这类局限性在学术研究和创意写作中尤为明显,因为这些领域往往需要高度的创新性和独有性。

具体而言,写作系统在解决复杂和抽象的概念时显得力不从心。例如,文学作品中的象征手法、隐喻以及情感表达,这些都需要深刻的情感体验和复杂的逻辑推理,而在这方面的能力有限。 生成的文本可能在形式上看似完美但在内容上的创新性却远不及人类创作。

写作系统在生成文本时,缺乏对整体语境和背景的深刻理解。它们往往只能依照局部的语法和语义规则生成句子,而无法全面把握文章的整体逻辑和结构。这使得生成的文本在某些情况下显得生硬和机械,缺乏流畅性和连贯性。

数据集的作用

写作系统的训练数据集对生成内容的品质和相似度有着直接的影响。当前,许多写作工具都是基于大规模的文本数据集实行训练的。这些数据集多数情况下包含了互联网上的各类文章、书籍、新闻报道以及其他公开资源。这些数据集本身也可能包含了大量的重复内容和相似的主题从而影响了生成文本的特别性。

以Google的BERT模型为例,该模型在训练进展中采用了庞大的语料库,其中包含 、BooksCorpus和英文新闻网站等。这些数据集中的文本涵盖了广泛的领域和主题,但同时也包含了大量重复的表达和相似的结构。这使得BERT模型在生成文本时,不可避免地会受到这些已有文本的影响,从而引起生成的内容与已有的文本存在较高的相似度。

另一个例子是GPT-3(Generative Pre-trned Transformer 3),它是目前的语言模型之一。GPT-3在训练进展中利用了包含超过45TB未压缩文本的数据集。尽管这个数据集包含了丰富多样的内容,但由于训练数据的庞大和多样性,GPT-3生成的文本仍然有可能与已有的文本存在较高的相似度。

技术局限性

写作系统的技术局限性也是引起生成内容相似度高的关键起因。尽管现代技术已经取得了长足的进步,但在理解和生成复杂文本方面仍存在一定的局限性。以下是几个主要的技术限制:

上下文理解能力不足

写作系统在生成文本时往往缺乏对上下文的深刻理解。例如,系统在解决具有多重含义的词汇或短语时,也许会误解其具体含义,从而引发生成的内容出现偏差。此类偏差不仅会影响文本的准确性,还会增加与已有文本相似的风险。例如,若是一个系统在生成一段关于“苹果”的描述时,不存在正确理解“苹果”指的是水果而不是科技公司,那么生成的文本有可能与其他有关苹果公司的文章存在相似之处。

缺乏创造性思维

系统在生成文本时,缺乏真正的创造性思维。它们一般只能依据已有的数据和规则生成内容,而无法像人类一样创造全新的概念和观点。这类缺乏创造力的表现使得生成的文本在创新性和特别性方面存在明显的不足。例如,系统在生成诗歌或小说时,或许会重复采用已有的诗句或情节,而无法创造出真正新颖的作品。

对情感和语境的理解不足

写作系统在应对情感表达和语境变化时表现得不够准确。例如,在生成描述情感波动的文本时,系统可能无法精确捕捉到细微的情感变化,从而致使生成的内容显得平淡无奇或过于生硬。同样,在应对不同语境下的语言表达时,系统也可能出现偏差,进一步增加了生成文本与已有文本相似的可能性。

模型训练数据的局限性

写作系统的训练数据集往往是基于特定领域的文本实行构建的,这使得模型在生成文本时,容易受到这些已有数据的影响。例如,假若训练数据集中包含了大量关于某个特定主题的文章,那么系统在生成相关主题的文本时,就可能重复采用这些已有的表达和结构。此类数据集的局限性,不仅限制了生成内容的多样性,还增加了生成文本与已有文本相似的风险。

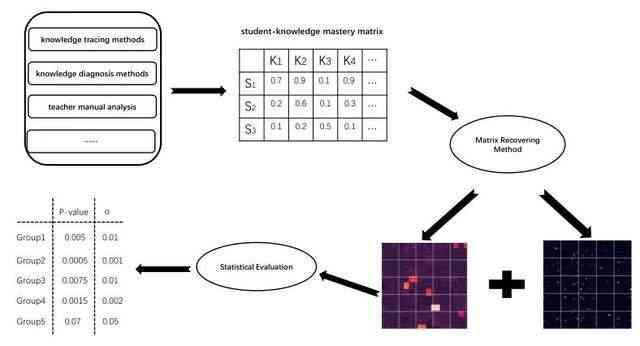

查重系统的作用

查重系统在检测生成文本的相似度方面发挥着要紧作用。这些系统通过将待检测的文本与数据库中的大量文献实行比对,找出相似度较高的部分,从而判断是不是存在抄袭现象。查重系统的算法一般包含文本匹配、相似度计算和统计分析等步骤。例如,Turnitin和Grammarly等查重工具,能够高效地检测出文本中的重复内容,并提供详细的相似度报告。

查重系统的工作原理多数情况下如下:

1. 文本预应对:查重系统会对输入的文本实行预解决包含分词、去停用词和标准化等操作。

2. 文本比对: 系统会将预应对后的文本与数据库中的大量文献实施比对寻找相似的片段。

3. 相似度计算:系统会计算每个比对片段的相似度得分,并按照预设的阈值判断是不是存在抄袭现象。

4. 结果输出: 系统会生成详细的报告,显示文本中的重复内容及其来源。

应对方案与未来展望

针对写作中存在的相似度高疑惑,研究人员和开发者正在探索多种解决方案。以下是部分可能的改进方向:

提升模型的上下文理解能力

通过引入更先进的自然语言应对技术,如增强型的Transformer模型或基于留意力机制的方法,能够加强系统对上下文的理解能力。这些技术能够更好地捕捉句子之间的关系,从而生成更加连贯和自然的文本。例如采用预训练模型如XLNet或RoBERTa,可在保持高效生成的同时提升对复杂语境的理解能力。

增强创造性思维

为了增强系统的创造性思维,可尝试引入更多的外部知识和数据源,如百科全书、专业书籍和学术论文等。这些数据源能够为系统提供更多元化的知识背景,帮助其生成更具创新性的内容。还能够开发专门的算法来模拟人类的创造过程,例如通过引入随机性和启发式方法,促使系统在生成文本时尝试不同的组合和表达方法。

改进数据集的选择和应对

在选择训练数据集时,应尽量避免采用含有大量重复内容和相似主题的数据。同时可通过数据清洗和去重等方法,优化训练数据的优劣。例如,能够利用自然语言解决技术,自动识别和去除数据集中的重复条目,保障训练数据的多样性和丰富性。还能够引入更多的跨领域数据,以拓宽系统的知识范围和应用场景。

结论

写作系统在生成文本时存在较高的相似度,这主要是由技术的局限性、数据集的影响以及查重系统的作用所造成的。要解决这一难题,需要从提升模型的上下文理解能力、增强创造性思维和改进数据集选择等方面入手。随着技术的不断进步相信未来写作将在保持高效生成的同时展现出更高的原创性和特别性。