文章正文

文章正文

引言

在数字化时代人工智能技术正以前所未有的速度发展。随着大数据和高性能计算能力的提升基于预训练模型的自动写作方法因其出色的语言理解和生成能力而备受关注。这些预训练模型常常通过大规模的文本语料实行训练使得机器可以理解复杂的语言结构和上下文关系。笔灵写作助手正是这一领域的创新者它以大模型为支撑融合了智能改写与续写功能成为写作领域的一大亮点。

写作模型概述

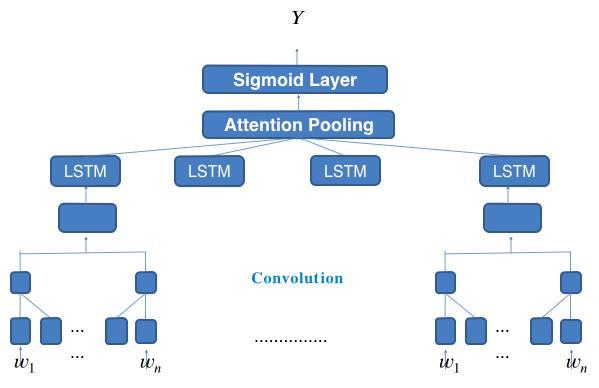

写作模型的核心在于其强大的语言理解和生成能力。这些模型多数情况下通过深度学习算法实行训练通过对大量文本数据的学习模型可捕捉到语言中的模式和规律。目前常用的写作模型涵盖BERT、GPT-2、T5等这些模型在各种自然语言解决任务中表现出色。其中,BERT(Bidirectional Encoder Representations from Transformers)是一个双向编码器表示模型,它能同时考虑上下文信息,从而更好地理解文本内容。而GPT-2(Generative Pre-trned Transformer 2)则是一种单向语言模型,主要侧重于文本生成任务。相比之下T5(Text-to-Text Transfer Transformer)将所有自然语言解决任务转化为文本到文本的格式,具有更高的灵活性和通用性。

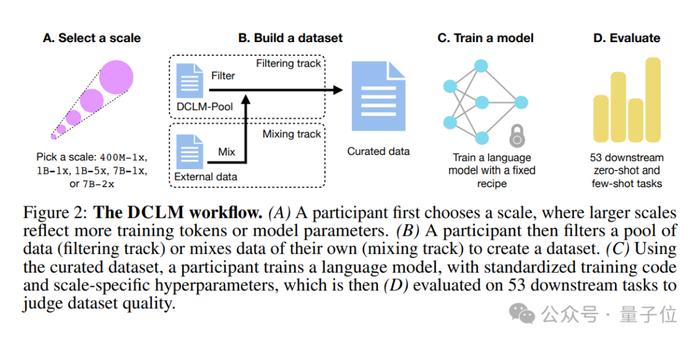

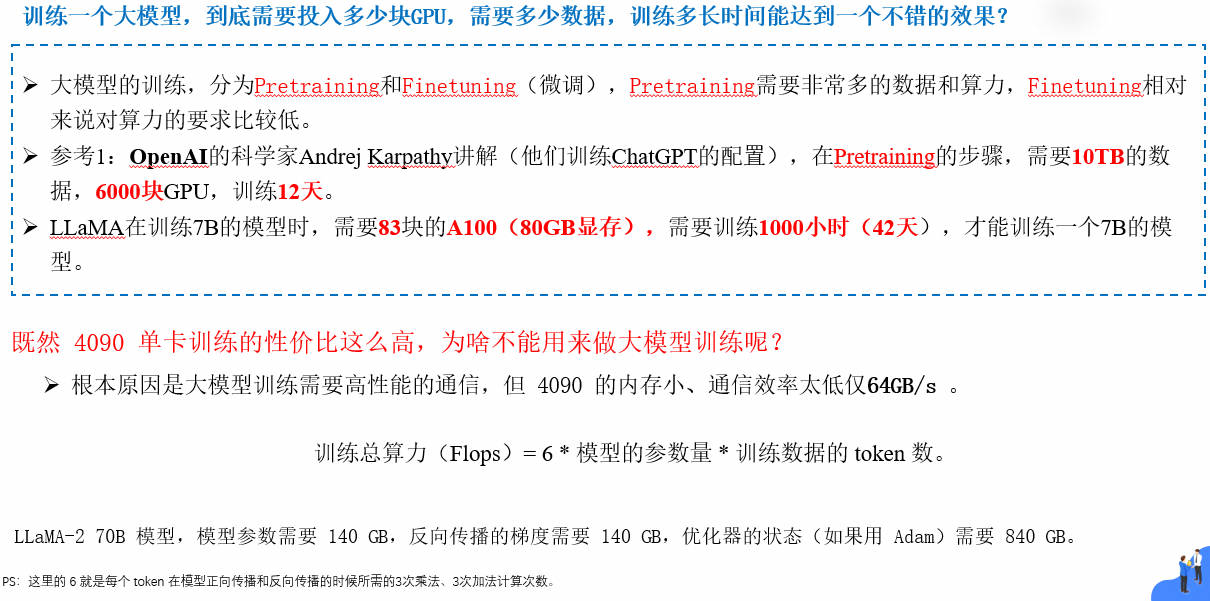

预训练模型的训练方法

预训练模型的训练过程主要包含两个阶段:预训练和微调。预训练阶段多数情况下利用无监督学习方法,即在大规模文本语料上实施训练,让模型学会捕捉语言中的统计规律。在预训练完成后,模型会进一步通过有监督学习的方法实施微调,使其适应特定的任务需求。例如,在微调阶段,可利用标注过的写作数据集对模型实施训练,使其具备更精准的写作能力。为了提升模型的效果还可以采用部分高级技巧,如对抗训练、迁移学习等。

开源写作模型推荐

BERT

BERT是当前更流行的预训练模型之一由Google开发。它采用了双向Transformer架构可以全面地理解文本的上下文信息。在写作任务中,BERT可用于生成摘要、分类文章类型以及改写文本等。由于BERT模型已经在大规模语料上实行了预训练,因而在实际应用中,只需实行少量的数据微调即可获得较好的效果。

GPT-2

GPT-2是由Open开发的另一个强大的预训练模型,主要用于文本生成任务。该模型采用了单向Transformer架构,能够依照给定的前文生成连贯的后续文本。在写作领域,GPT-2能够用于续写文章、创作诗歌和故事等。值得一提的是,GPT-2的生成能力非常强大甚至能够模拟人类的写作风格,生成高度逼真的文本。

T5

T5模型由Google研究团队开发,它将所有的自然语言应对任务都转换为文本到文本的格式。这类设计使得T5具有极高的灵活性和通用性,能够在不同的任务之间实行无缝切换。在写作任务中,T5能够用于翻译、摘要、问答等。由于T5模型的灵活性,它非常适合需要多任务解决的应用场景。

笔灵写作助手的特点与优势

笔灵写作助手是一款结合了大模型技术的写作工具,其核心特点在于智能改写与续写功能。通过整合多种先进的预训练模型,笔灵能够按照使用者的需求实施高品质的文本改写和续写。例如,在改写功能方面,笔灵能够帮助使用者将原始文本转换成不同的风格或表达形式,从而满足多样化的写作需求。而在续写功能方面,笔灵能够依照给定的前文自动生成连贯且富有创意的后续内容,极大地升级了写作效率和品质。

实际应用案例分析

为了更好地展示写作模型的实际应用效果,咱们选取了几个具体案例实行分析。某新闻网站利用BERT模型来生成每日新闻摘要。通过对大量新闻文本的预训练,BERT模型能够准确地提取关键信息并生成简洁明了的摘要。这不仅节省了编辑人员的时间,还提升了新闻报道的优劣和可读性。一家出版社利用GPT-2模型来创作科幻小说。GPT-2的强大生成能力使得该模型能够快速生成充满想象力的故事内容,并且保持了较高的逻辑性和连贯性。 一个在线教育平台采用了T5模型来制作教学视频的字幕。T5模型能够将教学内容自动转化为文字,并实施翻译和优化,从而增进了视频的可访问性和传播范围。

总结与展望

基于预训练模型的自动写作方法因其出色的语言理解和生成能力而备受关注。无论是用于生成摘要、分类文章类型,还是续写文本,这些模型都能够提供高效且高优劣的服务。未来,随着技术的不断进步,写作模型将会更加智能化和个性化,为各行各业带来更多的可能性。