文章正文

文章正文

怎样去本身训练一个写作:从零开始的全面指南

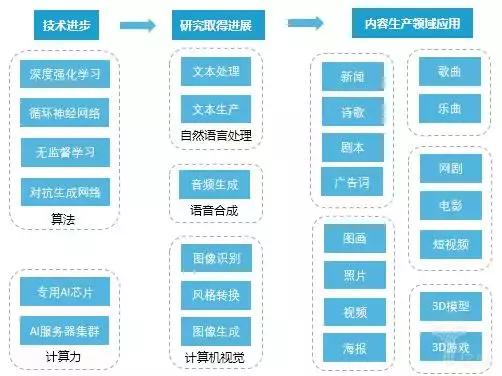

在当今这个信息爆炸的时代写作已经成为了一种必不可少的技能。无论是为了商业用途、学术研究还是个人兴趣写作都是表达思想和观点的要紧办法。随着人工智能技术的发展越来越多的人开始关注怎样利用来辅助或甚至替代人类实施写作。本文将详细介绍怎样去从零开始训练一个写作涵盖从数据准备到模型训练的全过程。

一、准备工作

在开始训练写作之前你需要准备部分必要的工具和资源。选择一个适合你的写作工具至关必不可少。市面上有许多优秀的写作平台,如Kimi、豆包等。这些平台提供了丰富的功能,可以帮助你快速地生成高优劣的文章。

你需要收集大量的训练数据。数据的优劣和数量直接作用到最终模型的效果。你能够从互联网上抓取大量文本,也可采用现有的公开数据集。还能够考虑与其他开发者合作,共享数据资源。

二、数据预应对

数据预应对是训练写作的关键步骤之一。在这一阶段你需要对收集到的数据实施清洗和整理。具体包含以下几点:

1. 去除噪声数据:删除无关信息,如HTML标签、特殊字符等。

2. 分词解决:将文本拆分成一个个单词或短语,以便于后续应对。

3. 标准化应对:统一大小写格式,去除多余的空格等。

4. 构建词汇表:统计所有单词的出现频率,并建立一个词汇表。

三、选择合适的模型

目前深度学习技术已经广泛应用于自然语言解决领域。对写作而言,常用的模型有RNN(循环神经网络)、LSTM(长短期记忆网络)以及Transformer等。每种模型都有其特点和适用场景。例如,RNN擅长应对序列数据,而Transformer则在应对长距离依赖方面表现优异。

在选择模型时,你需要依照你的具体需求和数据特点来决定。倘使你的数据量较大且包含较长的文本那么利用Transformer模型可能更为合适;假如你的数据量较小,则可尝试采用RNN或LSTM。

四、训练模型

在完成上述准备工作之后,就可开始训练模型了。训练过程多数情况下分为以下几个步骤:

1. 初始化参数:为模型设置初始参数。

2. 前向传播:将输入数据通过模型实行前向计算得到预测结果。

3. 计算损失:比较预测结果与实际标签之间的差异,计算损失函数。

4. 反向传播:按照损失函数更新模型参数。

5. 迭代优化:重复上述步骤,直到模型收敛。

在训练进展中,需要留意的是要控制好学习率和批次大小。过高的学习率可能引起模型训练不稳定,而过低的学习率则会造成训练速度变慢。同样,批次大小的选择也会影响到模型的泛化能力。

五、评估与调优

训练完成后需要对模型实行评估。评估指标能够是准确率、F1分数等。同时还需要通过交叉验证等方法来检测模型的泛化能力。

若是评估结果显示模型性能不佳那么就需要对模型实行调优。常见的调优方法包含增加训练数据量、调整模型结构、修改超参数等。还能够尝试利用集成学习方法,如Bagging和Boosting,以进一步增强模型的性能。

六、部署与应用

最后一步是将训练好的模型部署到实际应用中。这能够通过API接口的形式提供服务,也能够将其嵌入到现有的系统中。无论哪种办法,都需要保证模型的稳定性和可靠性。

在实际应用中,还需要不断地收集客户反馈,持续改进模型。只有这样,才能保证模型能够满足不断变化的需求。

总结

训练一个写作并不是一件容易的事情,它需要综合运用多种技术和方法。但只要掌握了正确的方法,并持之以恒地努力,就一定能够训练出一个高品质的写作。期待本文能够为你提供部分有用的指导和启示,帮助你在写作的道路上越走越远。

通过以上步骤,你可从零开始训练一个写作。这只是一个基本的框架,具体的实现细节有可能因数据特点、硬件条件等因素有所不同。期望你能在这个进展中不断探索和创新,创造出更多有价值的成果。