文章正文

文章正文

智能写作技术解析:写作原理深入探究

随着人工智能技术的飞速发展写作作为一种新型的创作形式正逐渐渗透到咱们的日常生活和工作之中。本文将深入探讨写作的核心原理剖析其技术细节并展望未来的发展趋势。

一、写作概述

写作是指利用人工智能技术实现自动生成文本的过程。它基于自然语言解决(NLP)和机器学技术通过对大规模的语料库和预训练模型的学模仿人类的写作能力。近年来写作在各个领域得到了广泛应用如新闻报道、广告文案、科技文章等。

二、写作原理深入探究

1. 数据收集与预应对

写作的之一步是收集和准备训练数据。这些数据常常来源于互联网上的大量文本涵书、文章、网页等。在收集数据后,需要对数据实行预解决,包含去噪、分词、词性标注等,以便神经网络更好地学。

2. 深度学模型

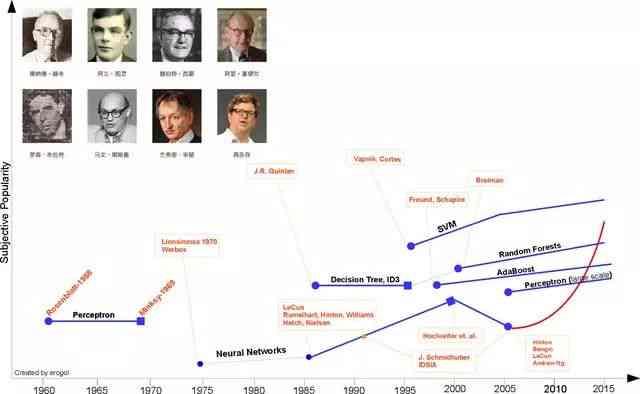

深度学模型是写作的核心。其中,神经网络通过对大量文本数据实训练,学语言的规律和上下文关系。以下几种深度学模型在写作中具有关键作用:

(1)循环神经网络(RNN):RNN具有短期记忆能力可以捕捉文本中的长距离依关系。但在应对长文本时,梯度消失和梯度爆炸疑惑较为严重。

(2)长短期记忆网络(LSTM):LSTM是RNN的一种改进,通过引入门控机制,有效应对了梯度消失和梯度爆炸难题,升级了文本生成的品质。

(3)Transformer模型:Transformer模型采用自留意力机制,可以捕捉文本中的全局依关系。其优势在于并行计算能力较强,训练速度较快。

3. 预训练模型

预训练模型是指在大规模文本数据上实预训练的模型,可学到丰富的语言知识和表达形式。近年来预训练模型在写作中得到了广泛应用。以下几种预训练模型具有代表性:

(1)Word2Vec:Word2Vec是一种基于词袋模型的预训练模型,通过将文本转换为向量表示,实现了词与词之间的相似度计算。

(2)BERT:BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer模型的预训练模型,具有双向编码能力,能够更好地理解文本中的上下文信息。

(3)GPT:GPT(Generative Pre-trned Transformer)是一种基于Transformer模型的预训练模型,具有较强的文本生成能力。

4. 写作过程

在深度学模型和预训练模型的基础上,写作系统通过以下步骤生成文本:

(1)编码:将输入的文本转换为向量表示,以便神经网络应对。

(2)解码:依据向量表示生成文本。

(3)优化:通过调整神经网络参数,使生成的文本尽可能接近真实文本。

三、写作的优势与应用场景

1. 优势

(1)高效:写作能够快速生成大量文本,加强写作效率。

(2)多样性:写作能够依据需求生成不同风格、不同领域的文本。

(3)智能:写作能够学人类的写作技巧和风格,实现个性化写作。

2. 应用场景

(1)新闻报道:写作能够自动生成新闻报道,升级新闻传播速度。

(2)广告文案:写作能够依照产品特点和客户需求,生成具有吸引力的广告文案。

(3)科技文章:写作能够自动生成科技文章,帮助人们熟悉前沿科技。

四、写作的挑战与未来发展趋势

1. 挑战

(1)价值观缺失:写作生成的文本往往缺乏明确的价值观,难以应对涉及价值观和道德伦理的难题。

(2)优劣不足:尽管写作在文本生成方面取得了显著进展,但在文本品质和准确性方面仍有待升级。

2. 未来发展趋势

(1)模型优化:未来,研究人员将继续优化深度学模型,增进写作的品质和准确性。

(2)跨领域应用:写作将在更多领域得到应用,如文学创作、历研究等。

(3)个性化写作:写作将按照客户需求和喜好,实现更加个性化的写作。

写作技术作为一种新兴的创作形式,具有广泛的应用前景。通过深入探究其原理,咱们可更好地熟悉这一领域的发展趋势,为未来的科技创新和应用提供有力支持。